微软正在计划投资1150亿美元、数百万芯片建造数据中心,支持OpenAI持续扩展其AI系统的规模达到千万级参数。

这个被称为星门 (Stargate)的超级计算机,将于2028年推出。这一数据中心预计将需要5GW电力,为OpenAI提供的算力将提升几个数量级。

这1150亿美元计划,相当于微软目前全年资本支出的3倍,分为五个阶段,微软已经开始了第四阶段,为OpenAI构建一个较小的超级计算机,预计2026年推出。目前OpenAI与微软正忙于前三个阶段。

进入最后两个阶段,微软将采购大量的芯片,预计英伟达的GPU仍然是主力,但芯片供应将会更加多元化,既包括微软自己研发的主要用于推理的芯片,也包括其他芯片厂商的供应。

据硅谷科技媒体Information透露,OpenAI CEO奥特曼正在推动这一计划,微软也做出了初步的成本估算。

微软很可能负责资助该项目,其成本将是目前一些最大数据中心的100倍,这表明未来几年可能需要巨额投资来建设AI的计算能力。

据硅谷业内传闻,目前GPT-5已经完成预训练,正处于对齐阶段,预计夏季推出。如果像业内预估的那样其参数规模将是GPT-4的十倍,GPT-5的参数规模将在20万亿左右。

微软已经开始为GPT-6的训练部署算力,按照目前的大模型扩展节奏,以每代模型一年到一年半左右扩展一个数量级,GPT-6的参数规模将在200万亿左右,2026年推出。2028年将是GPT-7推出的时间,参数规模将会达到2000万亿。

不仅仅是训练需要耗费大量的算力,随着生成式人工智能进入大规模部署应用阶段,推理需要的算力更大。

正如对Sora所需算力的估算,其推理的峰值,需要72万个H100GPU的算力,以目前H100的市场价计算【3.65万美元/每H100(80GB)】,GPU的投资就需要274亿美元。预计Sora将于年内推出。

据博通公司透露,它的一个重要客户,正在准备在几年内打造一个百万加速芯片级的算力集群,业内认为就是谷歌。而目前 Metak号称最大的算力集群,相当于65万张H100GPU。

另外,苹果真正入局生成式AI,宣告个人AI时代的到来,被认为是AI真正进入大规模部署应用阶段。据传苹果与谷歌、OpenAI都在洽谈,在其超过20亿的设备上建立SOTA大模型Gemini和GPT等的入口。而谷歌正在迅速把Gemini模型部署到数十亿部安卓设备上,包括三星和谷歌自己的终端设备。最近亚马逊也在加快部署Claude3。今年下半年,AI PC的推出也将进入高潮。目前ChatGPT上亿的活跃用户,日耗电约50万度。

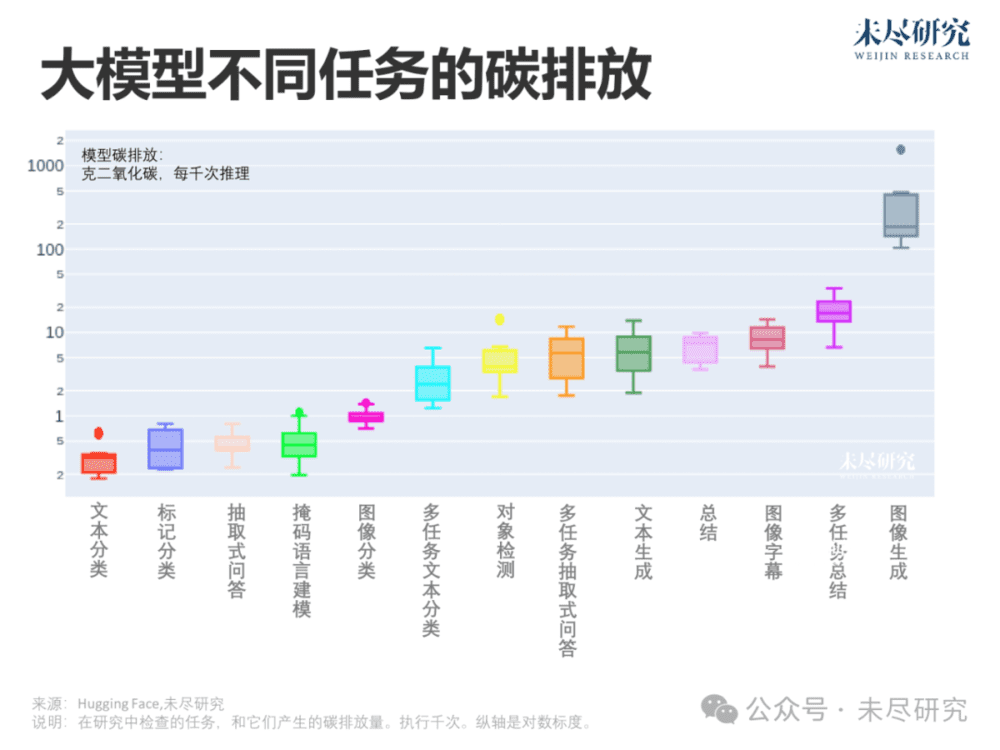

大模型的训练和推理阶段,都将耗费巨大的能源。尤其是大模型的功能越来越强,从大型语言模型扩展到多模态模型,并且通过视觉理解物理世界,视觉的能耗强度比语言功能能耗强度高出三个数量级。

据The Information报道,微软和OpenAI可能考虑选址威斯康星州的Mount Pleasant。这个系统可能需要的电力达到5GW,以至于微软和OpenAI正在考虑配套建设核电厂。

这么大规模的数据中心将面临种种挑战,因为需要“在一个机架中放入比微软通常使用的更多的GPU,以提高芯片的效率和性能。”这意味着还需要设计新的冷却技术。

微软和OpenAI也可能利用这项目的设计,减少对英伟达的依赖。尽管微软在当前项目中使用英伟达的InfiniBand电缆,但OpenAI希望在星门项目中避免使用InfiniBand。OpenAI声称它更愿意使用以太网电缆。

今年早些时候传出奥特曼有意打造AI芯片,并寻求筹集高达7万亿美元的资金投资芯片的工厂。去年,微软公布了其专为AI项目设计的128核心Arm数据中心CPU和Maia 100 GPU。还有报道称微软正在为其AI数据中心开发自己的网络设备。

但超级计算机将位于何处,以及它将建在一个单一的数据中心还是“在地理位置相近的多个数据中心中”,也都存在着不确定性。

为2028年的算力做规划,也必须考虑芯片和数据中心技术的进步。

台积电预测,在未来10年,GPU集成的晶体管数将达到1万亿个。与此同时,未来15年,每瓦GPU性能将提高1000倍。

GTC 2024大会上,英伟达CEO黄仁勋祭出世界最强GPU——Blackwell B200 ,整整封装了超2080亿个晶体管,它包括了两个GPU的芯粒(die)。比起上一代H100(800亿),B200晶体管数是其2倍多,而且训AI性能直接飙升5倍,运行速度提升30倍。价格将在3万美元到4万美元之间。

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究