去年9月,甲骨文董事长埃里森、特斯拉CEO马斯克,一起请英伟达创始人黄仁勋在硅谷一家豪华餐厅吃日料。

年届八旬的埃里森回想起那顿饭仍难以平静。“席间埃隆(马斯克)和我在乞求,我想用这个词来形容我们再恰当不过了。吃了一个小时的寿司,也乞求了一个小时。”

两位以狂妄著称的大佬甘愿伏低做小,只为能多分到一些“比毒品还难搞到”的英伟达GPU,最终两人未能如愿。

而另一家硅谷巨头思科为了保护刚买来的英伟达GPU,干脆动用装甲车来运。

正如科幻作品《沙丘》将香料设定为宇宙最重要的资源。今天同样可以大胆宣称:谁掌握了GPU,谁就掌握了AI时代的命脉。

去年以来,在加速计算和生成式AI的带动下,算力需求陡增。英伟达GPU作为提供算力的核心硬件,业界对其的需求早已“远远超过了英伟达所能供应的极限”。

为了获得尽可能多的GPU,全球科技圈从贵族俱乐部化身为私酒时代的芝加哥,产品、流量与增长交织的史诗,让位于充斥着贪婪、炫耀、谄媚与背叛的大模型舞台剧。

从破产边缘到80亿美元估值

在过去一年,英伟达GPU极度短缺,全世界的大厂或创业公司都在各显神通解决“芯荒”难题。

对中国企业来说,GPU短缺则是政策和产能两方面造成的。

从2022年10月开始,英伟达就被禁止向中国出口A100、H100这两款高端GPU。二道贩子们敏锐地嗅到了其中的商机。

一些企业从自家机房里把芯片禁令生效前购买的A100拆出来,卖给贩子。这些没有保修、没有质保的旧芯片,非但没有贬值,价格还从出厂时的8万多元涨到了10多万元。

A100、H100分别由英伟达在2020年及2022年推出,上市时间并不长,其在国内市场的存货相当有限。

另外,A100分为80GB、40GB两个显存版本,显存越大,所能运行的神经网络越大,训练大语言模型效果越好。厂商都想买80GB显存版本的A100,导致存货更加紧缺。

因此,有一些黑心贩子将A100的40GB版本改成80GB的来卖,很多急于购买的企业一时失察,买回去才发觉货不对板。由于这类GPU来源特殊,上当的买家根本没有质保和维权的途径,只能吃哑巴亏。

可即便如此,低配置的二手A100在2023年依然供不应求。

过去一年,市面上英伟达GPU价格涨幅一度到了200%。A100最火爆的时候,网传最高成交价接近25万元。按照这个价格,两块GPU就能换来一辆全新奔驰E级轿车。

二道贩子卖机房拆来的A100赚差价,毕竟只是小打小闹。真正靠倒卖二手GPU发家的,还要属一家名为CoreWeave的美国公司。

CoreWeave最开始是一家“挖”比特币的公司,其CEO回忆:“2016年,我们购买了第一块英伟达GPU,插上电源后,将其放在曼哈顿办公室的台球桌上,然后挖到了以太坊网络上的第一个币。”

在生成式AI火爆之前,英伟达GPU除了作为游戏显卡,最赚钱、最大的应用场景就是用于加密货币“挖矿”。因为GPU能以最快速度处理海量简单重复的问题,天然就很适合用于昼夜不停地挖比特币。

而CoreWeave的三位创始人,一开始也只是将”挖矿”用于赚取额外收入,他们的本职工作是经营对冲基金和家族办公室。可由于2016年加密货币热,他们的GPU越买越多,导致“华尔街的办公桌上堆满了GPU”。

到2018年底,CoreWeave已经成为了北美最大的以太坊“矿场”,拥有超过五万块GPU,占以太坊网络总量的1%以上。

通过将英伟达GPU用作“矿卡”,CoreWeave在加密货币领域赚到了第一桶金。但在2018年之后,市场行情急转直下,加密货币大幅贬值,与加密货币深度绑定的CoreWeave也几度面临财务危机,险些倒闭。

到2019年,CoreWeave决定转型做服务。

CoreWeave加入英伟达的云服务提供商计划,也就是围绕英伟达的芯片构建了专门的云基础设施。如果说英伟达是算力厂商,那CoreWeave就相当于算力经销商。

到2022年底,ChatGPT发布,生成式AI突然爆火,CoreWeave手头数万块GPU成为了硬通货,因为GPU非常适合用于训练AI大模型。它摇身一变,依靠手中积攒的GPU,向OpenAI、微软、Inflection等众多AI巨头卖算力。

2023年4月,CoreWeave还获得来自英伟达的B轮融资。黄仁勋在业绩电话会上点名:“一大批新的GPU专业化云服务提供商正在出现,最知名的当属CoreWeave,他们做得非常出色。”

英伟达对“亲信”CoreWeave可谓非常偏心。在一份研究机构Omdia披露出的英伟达H100供货单中,CoreWeave获得的H100数量,比特斯拉还多。

也正因为英伟达的“偏心”,除了卖算力服务,CoreWeave以囤积的英伟达芯片为抵押,从黑石、Coatue等顶级机构获得了23亿美元的债务融资。一举将公司从破产边缘,拉到了投后估值80亿美金。

冒高风险,买走私卡

不是谁都有CoreWeave这么好的运气。

跟英伟达关系不够亲密的企业,尤其是中小企业,购买“走私芯片”就成为一种无奈之下的选择。

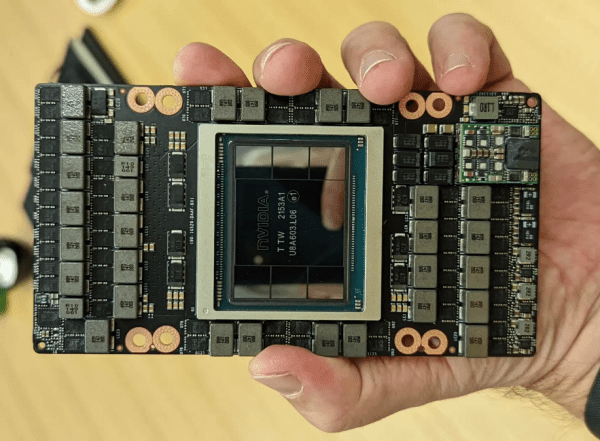

随着全球AI大模型竞争愈发激烈,A100已经不能满足一些企业的需求,性能更强劲的H100日趋抢手。

问题在于,H100实在太新了,存货更少。没有存货,二道贩子也无处发挥,走私贩子们登场了。

走私贩子们的来货渠道主要有两条:一是等英伟达向美国大型企业发货后,抢购市场上的剩余库存;二是通过在印度、新加坡、马来西亚等地注册公司进口。

相比于只有指甲盖大小的微型芯片,H100的尺寸并不小。根据英伟达官方公布的尺寸,H100整个芯片大小为814平方毫米,大概有两个手掌大,走私贩子只能将H100放进背包,接受正式的过关安检。

有走私贩子透露,由于每个国家把控严格度不一,如果把H100放在包里,把它报成普通电子设备。

麻烦的是服务器架。H100需要插在服务器架上,才能用于训练AI大模型。一套完整AI服务器要配置8块H100,加上一台超微电脑的服务器架,大约相当于一个保险柜。

面对如此庞然大物,自然无法靠人肉背回。一般的做法是化整为零,将服务器拆开,用蚂蚁搬家地方式发回。至于运输途中关键部件是否会损坏,运到目的地如何拼装回去,一切都存在极大的风险。

H100在2022年3月刚发售时,售价折合人民币约24.2万元。如果在两年前屯了一批H100,什么都不用做,每张到现在能净赚6到9万元。

在过去一年间,从朋友圈、小红书等社交平台,到拼多多、闲鱼等电商平台,再到各类垂直社区、垂直社群,有无数贩子打出了“H100现货,手慢无!”、“稀缺H100现货,先到先得!”、“原厂H100,见货付款,欲购从速!”的标签。

而如果进一步私聊,这些芯片贩子会告诉你,产品没有保修或支持服务,到货最起码需要6到8周,并且需要先付定金。如果问及发货地和货源,贩子们大多会回答称“海外发货,大陆交付,可以送至指定地点。”

据买家爆料,走中小型中间商渠道,风险很高。

首先,交了定金,后续也可能因各种原因拿不到货。其次,即使能拿到货,诸如运输过程中磕碰、泡水等现象,也时有发生,“碰到这种情况就只能自认倒霉,根本不存在退货一说。”

可即便如此,在各个社交平台“H100预购从速”的帖子下方,仍然有成群结队的用户在咨询价格。

抢购、加钱、售罄

购买走私GPU不是常态,对大公司而言,终究还是得跟英伟达做正经生意,从官方渠道购买A100、H100。

2022年的出口禁令下发后,经英伟达游说,重新获得了出口许可。在2023年3月1日之前,英伟达可以继续给中国大陆提供A100产品。

各家科技巨头赶紧行动,经历了“从抢购,到加钱,到售罄”的心路历程。

据《晚点》报道,张一鸣在卸任CEO后,把工作重点放在了研究AI上,不仅自己看AI相关论文,还经常跟一些字节高层分享论文学习心得,以及对ChatGPT的思考。高层对AI的重视,让字节在提前抢购英伟达芯片时占得了先机。

在GPT-4发布后不到3个月,字节就被爆出,向英伟达订购了超过10亿美元(约合人民币71亿)的GPU,到货和没到货的A100和H800总计有10万块。考虑到2022年全年,英伟达数据中心GPU在中国销售额大约100亿元,也就是说,字节一家公司的订单,几乎超过了英伟达过去一年在中国的总销量。

另一家提前向英伟达下单,囤积GPU的巨头是阿里。据一位阿里云内部人士向《人物》透露,阿里云专门成立了一个供应链团队,其中有几十人负责芯片采购,直接听命于CTO。在阿里云前CEO张勇卸任之前,通义千问等AI项目都向他直接汇报。

提前抢购A100、H100最直接的好处是——省钱。因为英伟达芯片的涨价,实际上与大模型的发展息息相关。2022年在ChatGPT刚刚发布时,大厂们普遍认为生成式AI很有潜力,但不成熟,不值得大批采购AI芯片。

但到2023年3月14日,OpenAI发布GPT-4后,大厂和VC们终于意识到,GPT的颠覆性威力,以至于各界迅速形成了共识——快搞大模型、快屯AI芯片!

也是从GPT-4发布后,大模型赛道涌进了大量热钱,以及不差钱的大厂,英伟达芯片的价格也随之水涨船高。大家都必须加钱才能抢到芯片。

按照《人物》的描述:“来自美团的高管带着采购团队,把数百台8卡A100服务器,像买白菜一样全部扫走。尽管一台机器的价格要大几十万,总订单额过亿,美团的人丝毫没有犹豫,下单、签合同、打预付款、提货……流程飞快。”

再到后来,连加钱都买不到AI芯片了。商业巨头和小公司处境几乎一致。

亚马逊云CEO亚当·塞利普斯基就表示:“H100是最先进的……可即使对于AWS来说也很难获得。”

富士康董事长刘永伟也表示,过去一年只有少数公司能获得足够的英伟达AI芯片来维持需求。在台北富士康年度员工聚会上,刘永伟对记者表示:“当要满足(AI芯片)需求时,也许需要建立新工厂。”

吃英伟达的剩饭

英伟达GPU像香料一样,诱惑着越来越多人参与到这场争夺中。

在2023年拉斯维加斯的CES科技大会上,AMD CEO苏姿丰表示:“AI已是AMD的第一战略重点。预计AMD最新推出的Instinct MI300加速卡,可以帮助AMD占领市场。”在介绍中,MI300X芯片是一款全面超越英伟达H100 AI芯片的产品。

投放市场后,MI300也迅速成为了AMD历史上销售额最快达到10亿美元的产品。

根据AMD财报,MI300芯片订单的主要来源是微软、Meta、甲骨文、谷歌、亚马逊等大厂。与英伟达H100的客户群体高度重合。

无怪乎《福克斯》认为:“如果业界还有英伟达潜在的对手,那一定包括苏姿丰和她掌管的AMD。”

除了AMD,老牌芯片巨头英特尔也不想在AI时代掉队。

在过去一年,英特尔CEO帕特·基辛格多次表示:“生成式AI不只可以在英伟达芯片上运行。”虽然英特尔最先进的AI加速芯片Gaudi 2在性能上不及英伟达H100。但基辛格认为,Gaudi 2成本更低,主打价格优势,可以在性价比方面缩小与H100的差距。

与此同时,英特尔还宣布正在调整GPU策略,整合现有的Habana Labs、数据中心GPU两大部门,于2025年推出新平台“Falcon Shores”,进一步增强AI芯片设计能力。

按基辛格的说法:“以后的AI算力竞争一定会很有趣。”

甚至除了老牌芯片巨头,一大批半导体新生力量,也在试图抢夺英伟达的市场份额。根据外媒报道,腾讯、阿里等互联网巨头,已经有些“看不上”英伟达的特供版芯片,转而寻求与国内GPU厂商合作了。这些GPU厂商包括华为、燧原科技、摩尔线程等。

在黄仁勋最近的采访中,连AMD都看不上的老黄表示:“在生产最好的AI芯片的竞争中,华为是英伟达非常强大的竞争对手之一。”

而诸如燧原科技、摩尔线程等第二梯队国产GPU公司,也在2023年拿到了数十亿元不等的大额融资。

这一切变化都源于,全球企业都在寻找英伟达GPU的替代品。毕竟,英伟达的GPU再好,只有能用上才是真好。单是英伟达满足不了的市场需求,已经足以喂饱一大批GPU新兴企业。

但要取代英伟达又谈何容易?

造成英伟达GPU短缺最根本的原因在于,GPU是一种极端复杂的产品,需要世界上最先进的生产工艺,目前只有台积电能够加工生产,而台积电的产能是有限的。

目前H100都由台积电代工,使用4纳米工艺(A100使用的是7纳米),从开始生产到出售给客户,H100中间经历的生产、包装和测试环节,一共需要6个月左右。

根据GPU Utils发布的一份研究报告,制约GPU扩大生产的一个主要瓶颈,是所谓的CoWoS封装技术。

CoWoS可以拆分成“CoW”和“WoS”来看。“CoW(Chip-on-Wafer)”指芯片堆叠;“WoS(Wafer-on-Substrate)”则是将芯片堆叠在基板上。CoWoS就是把芯片堆叠起来,再封装于基板上,最终形成2.5D、3D的型态,减少芯片的空间,同时减少功耗和成本。CoWoS封装技术目前的月产量也就1万片左右。

台积电可不止为英伟达代工,AMD以及博通、思科和赛灵思等都同样在使用CoWoS封装技术制作芯片。

产能瓶颈限制GPU供应的难题,在短期内是无解的。即便如AMD设计出了强大的MI300加速卡,归根结底还是要找台积电代工,台积电就算把给英伟达的产能给到AMD,等于市场上GPU的总量其实没有增加。

与此同时,英伟达真正的壁垒,并不只有GPU硬件性能,还在于其庞大的AI软件生态CUDA。

简单来说,决定GPU使用效果的不只是本身性能,还包括配套软件和开发工具对应用的支持。目前英伟达定义了GPU通用计算编程框架CUDA,开发者们早已习惯了用CUDA专有的编程语言,制作GPU驱动的应用程序。

如果开发者要迁移到谷歌、亚马逊、微软或国产的GPU,他们甚至需要学习全新的软件语言,迁移成本显然很高。

但后发厂商完全不必妄自菲薄,正如中国工程院院士、清华大学计算机系教授郑纬民所言:“今天国产AI芯片只要达到国外芯片60%的性能,如果生态做好了,客户也会满意。”

只是在达到英伟达GPU 60%的性能之前,企业们看起来先选择了以拆旧货、走私、抢购、加钱扫货等方式,缓解自身的AI芯片荒。

参考资料:

Nvidia’s Stunning Ascent Has Also Made It a Giant Target

How a Shifting AI Chip Market Will Shape Nvidia’s Future

Nvidia’s New China Pickle: Customers Don’t Want Its Downgraded Chips

Armored Cars and Trillion Dollar Price Tags: How Some Tech Leaders Want to Solve the Chip Shortage

The Desperate Hunt for the A.I. Boom’s Most Indispensable Prize

How Nvidia Came to Rule AI

极客公园:英伟达力挺,这家“AI 算力黄牛”4 年估值 560 亿

人物:互联网大厂,有钱难买A100

芯潮IC:天价H100流向黑市

晚点LatePost:争夺 AI 入场券:中国大公司竞逐 GPU