ChatGPT发布将满一年,被称为开启了通用人工智能的大门。而之后发布的GPT-4,因为在诸多的测试中表现了惊艳的效果,立即被一些研究人员称为一种“通用技术”,迸发出“通用人工智能的火花”。

通用人工智能一年来的发展,也伴随着诸多的争论。对人工智能的发展非常自信的声音,认为到2030年左右就可以实现“通用人工智能”,即人工智能将达到甚至超过人类的水平,反对的声音认为现在人工智能还处于很初级的水平,还根本谈不上通用人工智能。

“深度学习之父”辛顿(Geoffrey Hinton)认为实现通用人工智能,即AI达到或超过人类的时间会大大提前,最快至2030年,他也担忧超级智能将会对人类带来“生存威胁”。这种观点遭到许多人工智能专家的反对,认为目前人工智能还不配引发生存威胁。

通用人工智能的发展,会带来风险,需要监管,这已经成为共识。但是,如果把理论上或者科幻小说中存在的风险带入监管,而对现实的风险无计可施,可能会阻挠创新,监管本身也会脱离人工智能技术发展与应用的实际情况,让风险与安全这样的话题变成口水式的空谈。

最近在英国布莱切利花园结束的首届人工智能安全大会,发布的宣言有包括中国在内的28个国家签字。一些国家和8家领先的人工智能企业,还签署了一份自愿检测人工智能大模型安全性的文件。

欧盟、中国、美国推出的人工智能监管与立法,基本上秉持了风险控制的原则。这样,就需要衡量通用人工智能所带来的风险。

但通用人工智能是一项新兴的技术,发展很快,它所带来的风险,只是在实际应用中才会出现,也是在一些前沿的研究中逐步发现的,有些潜在的巨大风险,甚至根本就会阻止技术的全面部署。

从技术上来说,人工智能越先进,自主性就会越强,人类与智能系统交互的关系变化越快,从而不断释放出潜在的风险。身处这样一个快速的技术创新的实践过程中,对风险的发现与识别,可能风险管理中必需的一个视角。

AI专家们对风险的认识,从可操作、可衡量的工程思维出发。Google DeepMind的8位研究人员,梳理出来了一个框架,类似于自动驾驶的分级,能用共同的语言进行模型比较和风险评估。他们发表了一篇论文:《分级AGI:通往AGI之路上可操作的进步》。

研究人员从图灵测试开始,梳理了通用人工智能概念的形成与演变,包括1997年美国军方首次提出通用人工智能(Artificial General Intelligence)这个概念,直到生成式人工智能和大语言模型时代,最领先的人工智能企业如OpenAI、Anthropic等对AGI的定义和主张。AGI究竟能完成“哪些人”的“什么任务”,并不那么容易说清楚。他们总结出了AGI的六个原则。

定义AGI:六个原则

1. 侧重于能力,而不是过程。大多数定义侧重于AGI可以完成什么任务,而不是它完成任务的机制。这对于识别不一定是实现AGI的前提条件(但可能仍然是有趣的研究课题)很重要。这种侧重于能力使我们能够从AGI的要求中排除以下内容:

实现AGI不意味着系统以人类方式思考或理解(因为这侧重于过程,而不是能力)

实现AGI不意味着系统具有诸如意识或情感(因为这些品质不仅侧重于过程,而且不容易通过公认的科学方法来测量)

2. 侧重于通用性和性能。上述所有定义都在不同程度上强调通用性,但有些排除了性能标准。通用性和性能都是AGI的关键组成部分。

3. 侧重于认知和元认知任务。是否将机器人化(anthropomorphoization)作为AGI的标准是一个有争议的问题。大多数定义侧重于认知任务,这里的研究人员指是非物理任务。尽管最近在机器人技术方面取得了进展,但与非物理能力相比,AI系统的物理能力似乎滞后。

在某些认知任务上取得成功,可能需要在物理世界中具身化,建立世界知识以完成某些认知任务,或者至少可能是某些认知任务的成功路径之一;如果这被证明是真的,那么具身化可能对通向AGI的路径至关重要。另一方面,元认知能力(例如学习新任务的能力或知道何时向人类请求澄清或协助的能力)是系统实现通用性的关键前提条件。

4. 侧重于潜力,而不是部署。展示一个系统可以在特定性能水平上执行必要的任务应足以宣布该系统是AGI;将系统的部署在开放世界中不应成为AGI定义的内在要求。例如,以替代劳动力为目标来定义AGI将需要实际部署,而以具备替代劳动力能力来定义AGI将侧重于潜力。将实际部署作为衡量AGI的条件,会引入非技术性障碍,例如法律和社会考虑,以及潜在的伦理和安全问题。

5. 侧重于生态有效度(ecological validity)。有些任务可用于对AGI进展进行基准测试,应该选择与真实世界(即生态有效)任务相一致的重要性(广义地解释“价值”,不仅仅是经济价值,还包括社会价值、艺术价值等)。这可能意味着放弃那些容易自动化或量化的传统AI度量标准,因为这些度量标准可能无法捕捉人们在AGI中所看重的技能。

6. 侧重于通往AGI的路径,而不是单一的终点。自动驾驶分级,推动和规范了别相关的政策讨论和进展,“AGI分级”同样是有价值的。每个AGI级别都有一组明确定义的度量标准/基准,在每个级别引入已确定风险,对应人机互动范式的变化。

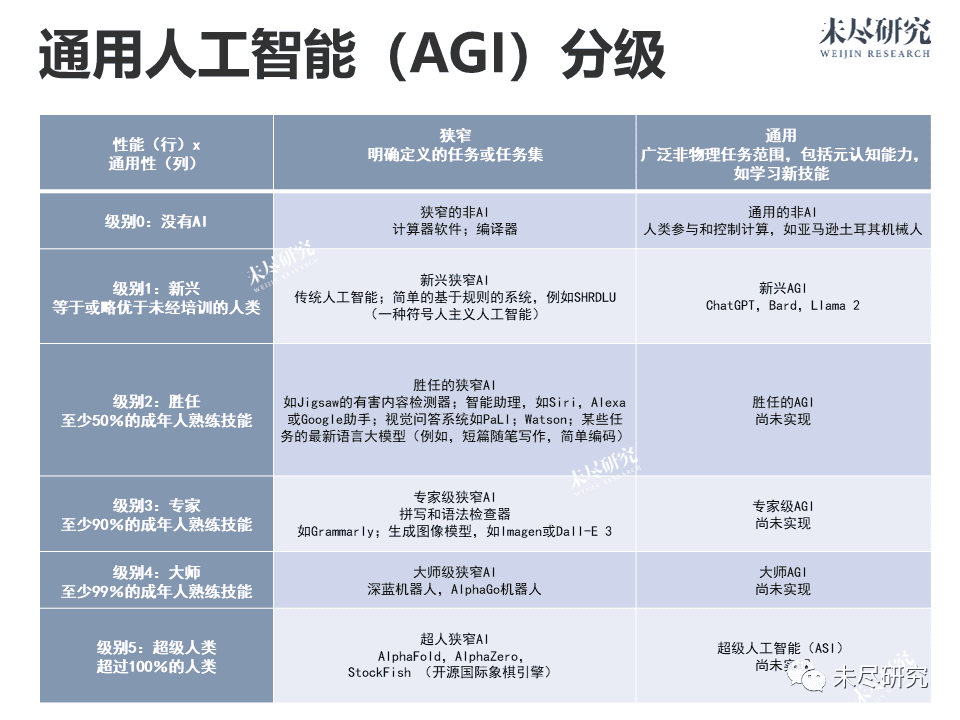

研究人员基于性能深度(performance)和广度(generality),用于对通往AGI的系统进行分类。其中的示例,都是类似于文献中的当前描述或与已部署系统的人机互动经验。

可以看到,人类已经在窄人工智能领域达到了人类大师级的水平(level 4),如深蓝和AlphaGo等,甚至达到了超人的水平(level 5),如预测蛋白质结构等;但在通用人工智能领域,人类只达到了入门级水平(level 1)。

AGI的发展,并不意味着更高级的人工智能完全替代更低级的人工智能,不意味着通用的人工智能取代垂直人工智能,更不意味着人工智能完全替代人工。从风险的角度考虑,有时候窄人工智能更加安全,也完全有必要保留人类智能。

未来的人类与人工智能的互动,将会是混合式的,即通用人工智能、垂直人工智能和非人工智能的混合。

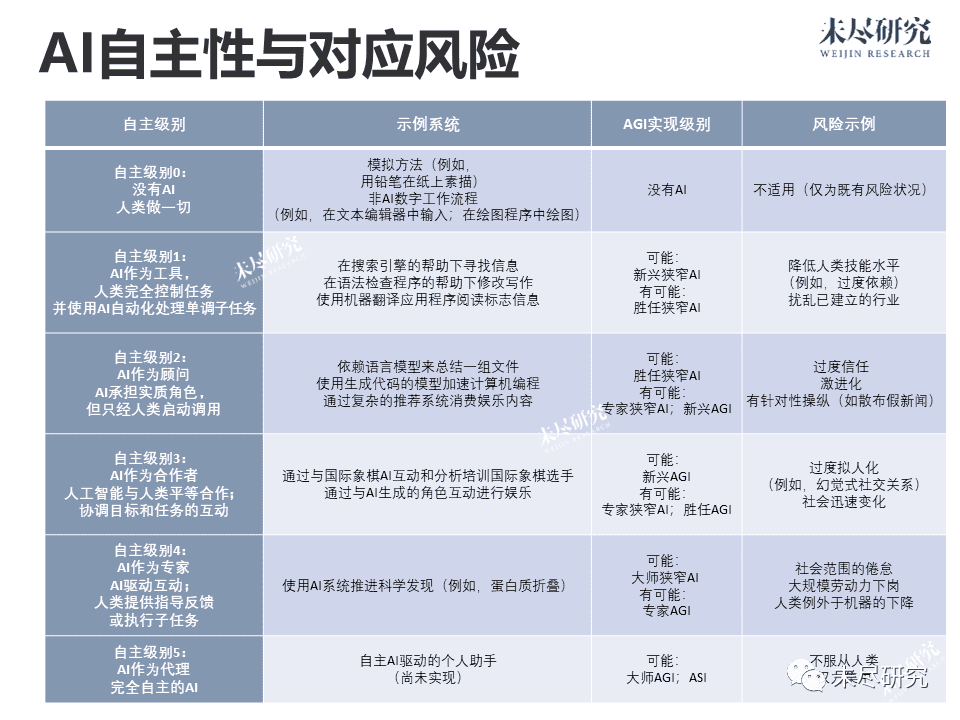

下表中的示例说明了仔细考虑人工智能与人类互动设计决策的重要性。

按研究人员的逻辑,是更强的人工智能系统会产生更强的自主性,进而实现人工智能与人类的交互的变化,直至范式的转移,包括完全自主的人工智能。总体方向是AGI会让机器人具有更大的自主性,更不确定的人机交互方式,又对应着新的潜在风险。

研究人员认为,需要区分是人类使用过程中产生的风险,还是人工智能带来的风险。在“专家AGI”以下的水平,例如“新兴AGI”“胜任 AGI”和所有“狭窄” AI类别,风险可能更多地源于人类行为,例如AI误用的风险,无论是意外的、偶然的还是恶意的。AGI分类法成为关键的步骤,有助于对每个级别相关的风险具体情况进行更全面分析,也有助于安全/伦理研究和政策制定。

但这里面似乎也有一处值得商榷。自主级别2中,举例了内容推荐也属于“经人类启动调用”,但实际情况似乎并非如此。社交网络上的内容推荐通常是基于算法的自动化过程,无需用户明确调用或触发。在这种情况下,系统主动分析用户的行为、兴趣和偏好,并自动推荐相关的内容。这恰与需要人类调用的情况形成了对比。

对AGI的分类也给我们一个启示,也许在深度(性能)和广度(通用)上集于一身、全面超越人类的智能,可能真的如马斯克所说的那样,是人类自以为能造出的一个上帝。但最终人工智能,可能是垂直与通用的结合,也是人类与人工智能的结合,可能才是真正的最好的智能状态(SOTA),也可能是最符合自然的一种智能状态。

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究