假座布莱切利公园,英国举办了第一届全球人工智能安全峰会。这里是人工智能之父图灵(Alan Turing)显灵的地方。

二战期间,盟国最聪明的大脑,数学家、密码学家们汇聚于此,破解纳粹德国的号称“不可破解”的密码,图灵发明的用于破解的图灵机,成为现代计算机的前身,也启发了后来标志机器是否具备人类智能的图灵测试。

当时的先进算法,不仅催生了计算机和人工智能,而且号称让二战“提前结束”,捍卫了人类安全。如今图灵测试在ChatGPT面前已如小儿科一般,但乱真已经开始威胁人类安全。一天天聪明起来的人工智能,不仅让人担忧社会是否已经准备好全面接纳它,甚至深度学习之父、图灵奖获得者辛顿(Geoffrey Hinton)也发出警告,“通用人工智能”很快实现,可能对人类造成“生存性威胁”(existential threat)。

政治家、企业家、科学家,还有最广泛地受其影响的消费者,都觉得要先把它管起来再说。尽管在人工智能领域是竞争激烈的对手,中国与美国都签署了《布莱切利宣言》。这意味着全球29个经济体,首次就人工智能风险监管的必要性和迫切性做出正式声明。

安全峰会将以气候变化政府间专门委员会(IPCC)为蓝本,由参加峰会的28个国家的代表组成。英国政府表示将为其提供秘书处支持。

图灵奖获得者本吉奥(Yoshua Bengio)将牵头带领一个专家组,编写有关前沿人工智能风险和能力的“科学状况”报告。该报告不会提出政策建议,但旨在为国际和国家政策制定提供信息。该报告将在明年上半年韩国举行的下一届安全峰会之前发布。

澳大利亚、加拿大、欧盟、法国、德国、意大利、日本、韩国、新加坡、美国和英国签署了一份不具约束性的文件,将测试领先公司的人工智能模型。中国没有签署。

自愿签署这一文件的人工智能公司包括亚马逊(AWS)、Anthropic、谷歌、Google DeepMind、Inflection AI、Meta、微软、Mistral AI 和 OpenAI。除了法国的初创公司Mistral AI之外,全部是美国科技巨头和初创企业。

英国为了主导AI安全国际规则的制定进程,已经成立了一个前沿项目工作组(Frontier Project Taskforce),设在科技创新部。并且还试图以此为基础,建立一个服务于峰会的AI安全研究所,进行安全标准的研究,并且打算采购上千块H100,弥补上算力差距。但美国提出要建立自己的安全研究所,研究最前沿的人工智能安全问题,并且为测试制定风险标准。

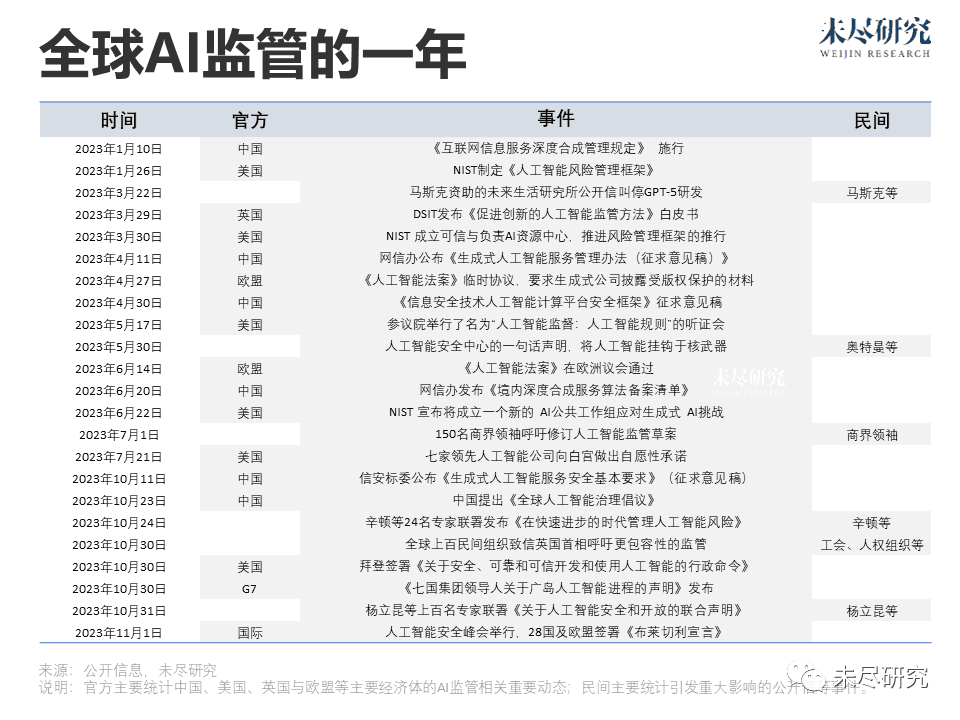

各家都对如何监管有自己的盘算。今年以来,各国陆续出台监管文件,民间也频繁公开致信。这周的布莱切利公园,成为了最激烈的博弈场所。

来自全球的100多个民间社会团体,联名上书英国首相苏纳克,警告那些将被人工智能从根本上改变生活、教育与工作方式的“社区与工人已被峰会边缘化”。它关乎上层的AI精英与底层的“无用之人”之间的公平。

另一位图灵奖获得者杨立昆(Yann LeCun)指责OpenAI 首席行政官奥特曼(Sam Altman)等自私的游说,代表了最先进而又最不透明的大模型公司,散布人类生存恐惧以游说政府,将导致有利于既得利益企业的“监管捕获”,高昂而不必要的合规成本,将阻碍后来者的创新。

美国总统拜登抢在峰会开幕前,签署了长达111页的总统令,然后派副总统哈里斯前往布莱切利公园表达美国立场。正如人工智能终将无处不在一样,这份总统令几乎触及了美国关心的一切:安全、隐私、公平,创新与人才,以及全球领导力。

美国国家标准与技术研究所(NIST)将制定的“红队(red-teaming)”标准,那些正在研发或有意研发军民两用(dual-use)基础模型的开发者,要根据《国防生产法》的要求,来识别缺陷和漏洞,并持续定期提交评估结果与缓解措施。

红队报告有其可取之处,但区别在于监管研发,还是监管应用。人类拥有的核弹头数量超过了核电站,“奥本海默时刻”发生在应用上。监管就意味着大量的财力人力投入,将监管前置到研发的成本会更高,削弱了追赶者的创新与竞争能力,也削弱了在创新中解决问题的机会。人工智能面临的很多对齐问题,正需要在研发中解决。

中国参与首届峰会,成为一大亮点。中国正在一步步探索对生成式人工智能的监管,优先保障“境内公众”接受的生成式人工智能服务都是“正能量”。今年7月施行的“管理暂行办法”,打消了行业对技术研发阶段以及企业应用场景的合规顾虑。10月开始征求意见的“安全基本要求”,进一步明确在“服务上线的备案申请前”完成安全评估并提交材料。英国《促进创新的人工智能监管方法》的方向也在于“使用”而非“技术”。

美国的总统令也体现出卡住算力脖子的惯性思路,要求那些在高于指定算力下训练的大模型,都要纳入红队监管;收购、开发或拥有门槛以上算力的公司、个人或其他组织或实体,需要报告它的位置与总算力。美国还要求算力基础设施厂商穿透披露它们的海外客户信息。

人工智能科学家和创业者吴恩达认为这匪夷所思,眼下的超级计算机,很快就会成为口袋里的手表,随着人工智能迅速发展,更多初创企业将被挡在算力门槛之外。尽管政府可以调整算力门槛,但创新会消弭在繁文缛节之中。

美国想保持人工智能的“领导力”,建立在其垄断技术和算力的基础上。拜登下令,要将人工智能风险管理框架的原则、指导方针和最佳实践,纳入美国境外的社会、技术、经济、治理、人权和安全状况。他还想发布《全球人工智能研究议程》。重担压给了商务部,部长雷蒙多也去了峰会,宣布将成立美国人工智能安全研究所,即她所称的“制定一流标准的中立第三方”。

在缺乏透明性的前提下,无法谈论监管中立。美国的监管框架目前缺乏对透明度的要求,无论是预训练数据、微调数据、注释,还是下游影响,与微软/OpenAI、谷歌/Anthropic 等全球领先的人工智能企业日益封闭的操作如出一辙。它们认为,先进的闭源基础模型远优于开源模型,而闭源正是为了商业竞争和防止 “恶意获取” AI技术。

这与同日发布《七国集团领导人关于广岛人工智能进程的声明》形成对比。七国集团同时发布的“国际指导原则”与“国际行为准则”,在一定程度上强调了透明度。欧盟要求生成式公司披露受版权保护的材料。中国则称宜具备“公开训练语料中涉及知识产权部分的摘要信息”的措施。

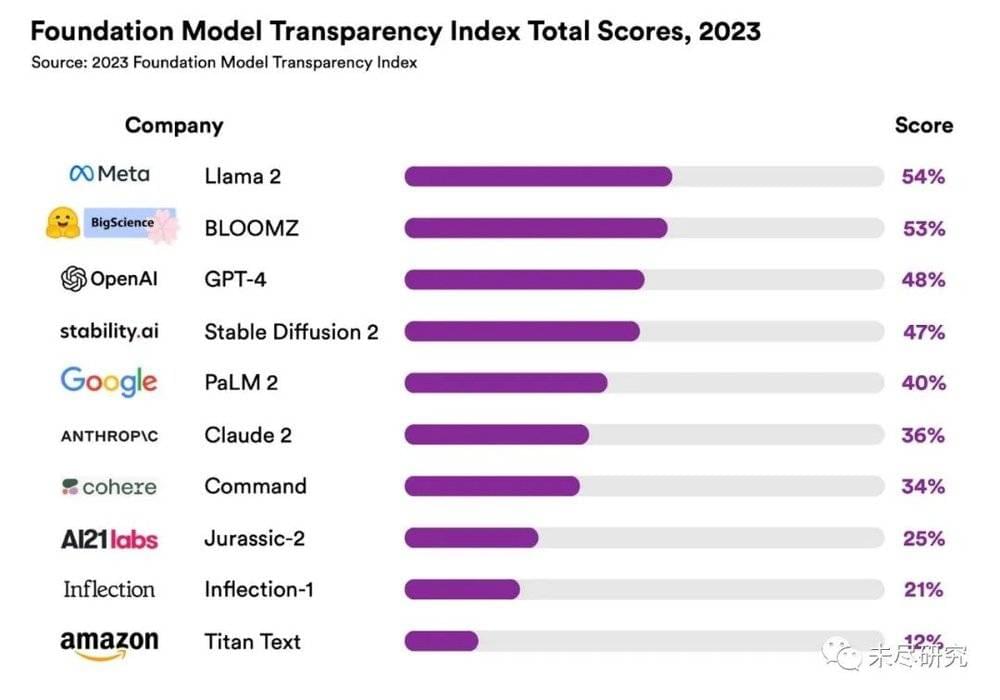

基础模型透明度指数

来源:HAI、CRFM

建立全球监管框架的一个必要前提,是各成员方之间要有基本的透明度。按斯坦福大学的研究,目前主要基础模型开发商及其旗舰模型,在100分中仅取得了37分的平均成绩,开源的Llama2得分最高,也不及格。

人工智能系统的“互操作”也成为国际安全合作中的一个重要议题。但中美两个大国之间在人工智能技术领域的激烈竞争,还彼此严加防范着跨境数据的流动,加上地缘政治竞争,让“互操作”听起来有些超现实。中国官方在“一带一路”国际合作高峰论坛发布了《全球人工智能治理倡议》,批评了技术垄断和单边强制措施,也显示出中国在国际上建立起自己的“互操作生态”的可能性。

与欧盟与中国相比,美国的监管基础,仍然是援引相关法律的行政策命令,以及行政部门和国会出台的一些指引原则,目前还看不到任何全国性的数据隐私保护或人工智能立法的前景。在立法上,欧盟走得最快最远,《人工智能法案》预计在今年底正式通过,将是全球首部综合性人工智能监管法律。基于风险管理的原则,欧盟试图规避因技术短板所暴露的风险。

以马斯克为代表的人工智能业界也在发问:监管方在出台政策之前,是否真的对人工智能有洞察。对人工智能创新的骚动正在平息下来,监管让生成式人工智能变得很现实。未来感十足的技术,背后是国家间的现实政治,企业之间的激烈竞争,以及各利益集团的博弈。

监管与研究、应用一起,共同塑造着生成式人工智能的发展。2024年,在中美两国主导的竞争格局下,人工智能的安全意义将会强化,它的商业应用想象维度也在收敛,但成为国家间竞争的利器,并不会缺乏资源。与此同时,各国政府与人工智能企业仍然会坚持对话,寻找全球监管的最大公约数,探索“无害利用”人工智能,寻求监管与创新的平衡,在应用落地的过程中,定义最佳实践。

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究