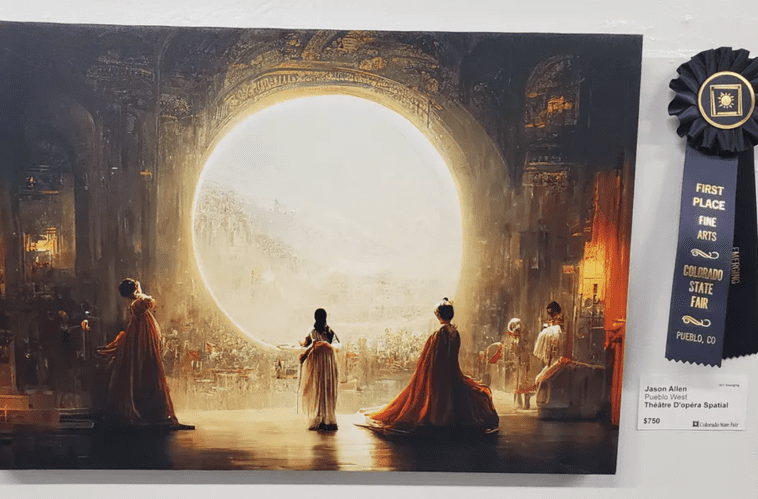

在今年8月的科罗拉多州博览会的艺术创作比赛中,出现了这样一组复古风格的科幻题材作品,穿着礼服的舞者们在宇宙背景下翩翩起舞,仿佛是栩栩如生的太空歌剧。

评委们立刻就被这组惊艳的作品圈粉了,就你没跑了!直接把数字艺术赛道的大奖颁发给了它的创作者杰森·艾伦。

不过此等大佬为啥在业内从来没听过他的名字,难道是什么世外高人?

结果没几天艺术家们就集体绷不住了——这位老哥在Discord论坛自曝了,自己是个游戏公司的老板,根本不是艺术家,参赛作品是他用一个叫做Midjourney的人工智能画的。

有人认为,这种作品根本没资格参加评选,因为杰森本人根本没付出什么努力。但杰森表示:比赛嘛,重要的是结果,你们又没说不让用AI。虽然争议很大,但主办方并没有收回颁奖结果,因为他们确实没禁止AI参赛……

但艺术家们的破防也是货真价实的。

虽然我自己不是美术生,但也多少知道他们为了走上艺术道路,付出了多大的努力。

我国每年大约有60万学子参加美术艺考,他们之中很多人高中甚至初中还没毕业,就要独自来到陌生的城市求学,几年如一日地架着画板,训练技法,培养美感,直到考上心仪的院校,艺术之路才算真正开始。

每一张别出心裁的海报、“纸片人老婆”的精美立绘、美术展上让人不明觉厉的画作,这些背后往往都有着数十年的努力和积累。

但这些都被一个名不见经传的AI,用一分钟都不到的创作给打败了,多少会让人有些怀疑人生。

这感觉就好比你努力一生终于成为一名绝世剑客,渴望一场堂堂正正的比武,结果对面不讲武德,掏出机关枪一顿输出,你作何感想?

再严重一些,如果AI创作功力恐怖如斯,最终会抢走艺术家们的饭碗吗?

01AI作画真的有那么简单吗

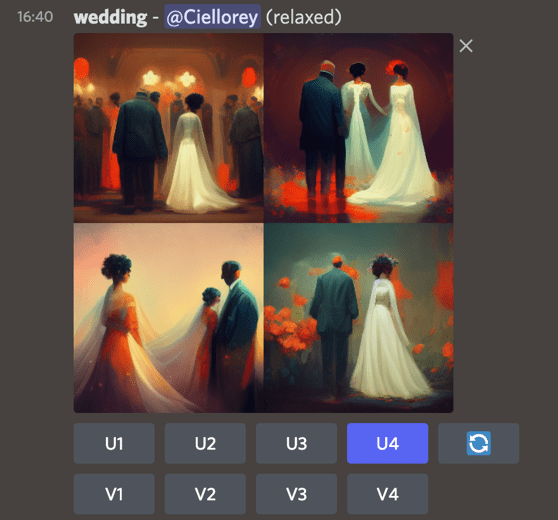

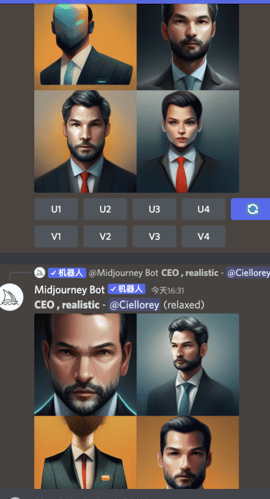

想要知道AI到底会如何影响创作者,最简单的办法就是亲自去试试,比如帮杰森·艾伦拿奖的那个Midjourney。

它的玩法非常简单,在聊天的对话框里敲入特定的命令行,然后再衔接上自己对图像的文字描述,回车后ai就会生成4张符合描述的草图。

下面有两行按钮,“U”是upscale的缩写,功能是把对应序号的图片添加更多细节,输出一张尺寸更大的成品图。

“V”是variety的缩写,功能是按照对应序号的图片再生成四张风格、构图差不多的草图。

细化后的完成图除了输出几种不同精细度和分辨率的衍生图外,还有个“重制(Remaster)”功能,虽然没太搞懂它重制的逻辑是什么,有时候连画风都给你改了,但有时候也能化腐朽为神奇。

Remaster后反而更有二次元的感觉了

Remaster后反而更有二次元的感觉了想要得到一张满意的图像,怎么给AI提需求是非常讲究的,比如除了讲清楚要画的东西,还可以指明想要的美术风格、细节丰富度、打光方式什么的。另外就是要多次尝试了,会有碰运气的成分在。

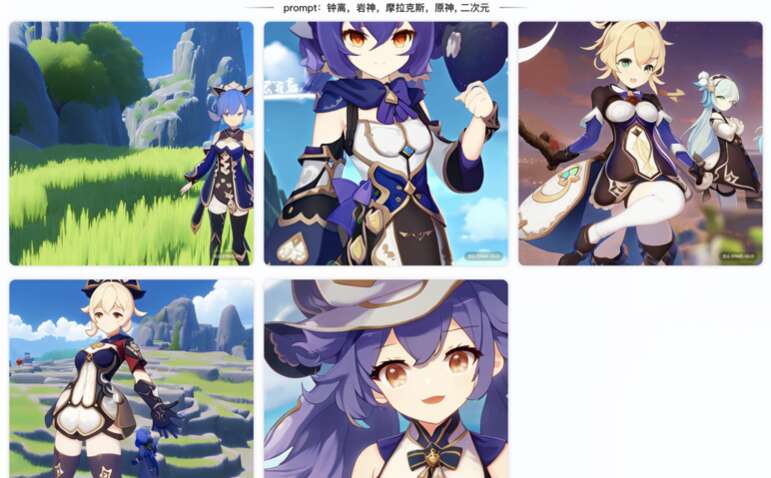

作为一个《原神》玩家,我第一反应就是让AI给我画一个帅气的钟离,输入的关键词包括Zhongli, Morax, Genshin Impact这些,可在经过反复几次迭代后,我得到了个什么鬼!

你要说毫无关系吧,这衣服的色系还有那么一点感觉,你要说有关系吧,这岩王帝君被磨损得渣都不剩了吗?

Zhongli, Morax, Genshin Impact

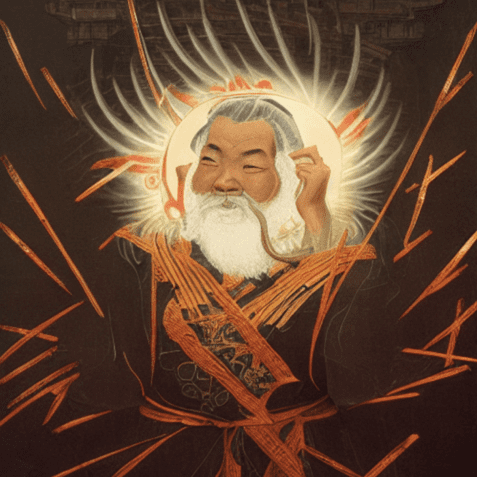

Zhongli, Morax, Genshin Impact不过在出图的过程中,我也得到了一些虽然毫无关系、但惊艳至极的图片,比如这两幅。

Zhongli, Genshin Impact

Zhongli, Genshin Impact嗯……勉强解释为帝君在渡劫?还有这种霸气的肖像,是平行世界的钟离吗?不过也挺帅的:

Morax, Genshin Impact

Morax, Genshin Impact钟离老爷子在国外也挺火的啊,为啥AI就不识别了呢?感觉我的关键词锁得差不多啊……

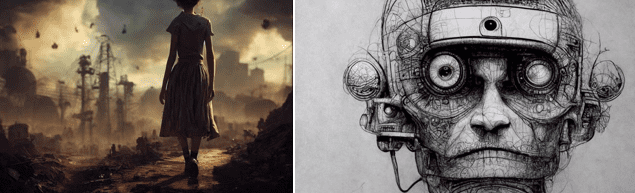

迫害完了钟离,再来迫害一下雷电将军(Raiden Shogun)。于是,得到了下面这些图片。

Beelzebul, Raiden Shogun, female, Genshin Impact

Beelzebul, Raiden Shogun, female, Genshin Impact帅是真的帅,但我想要的是煮饭婆啊!然后我又用派蒙、神里绫华、八重神子、小吉祥草王试了下,不能说是一模一样,只能说是毫无关系。

现在终于可以确认,虽然原神可以说是市面上最火的游戏,但以目前这个AI的学习程度和“阅片量”,它还理解不了“原神”是什么。

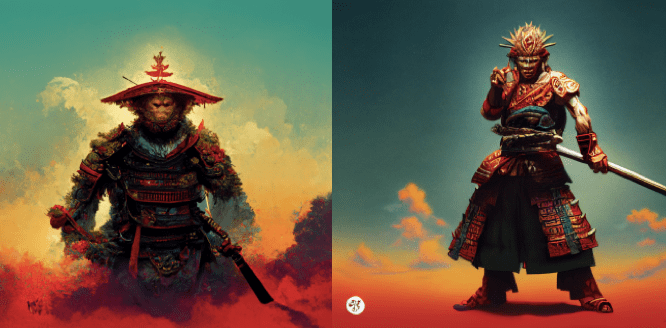

如果是那种在中西方语境下完全家喻户晓的高人气角色,AI能精准狙击吗?比如,咱们的齐天大圣孙悟空……

一通尝试后,效果还是挺不错的!

Sun Wukong,Cyberpunk style

Sun Wukong,Cyberpunk style Sun Wukong, Sumurai

Sun Wukong, Sumurai Ninja Sun Wukong

Ninja Sun Wukong

Sun Wukong wearing a glasses

Sun Wukong made of fire

但创作过程中也有很多问题。最头疼的是AI总是试图把Sun(孙)理解成sun(太阳),经常会出现带有太阳的风景画。

Sun Wukong, shoot in the universe, 4k, hyperrealistic, unreal engine

Sun Wukong, shoot in the universe, 4k, hyperrealistic, unreal engine看来即便是AI,理解中文也是颇有难度的。如果换成国外家喻户晓的IP,比如比卡丘,创作过程就会容易很多,甚至可以绘制出一整套赛博比卡丘军团。

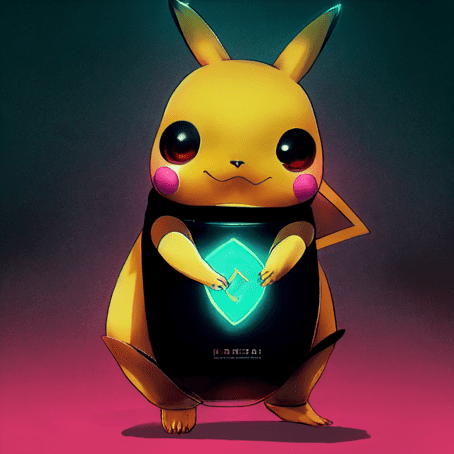

而且通过调整关键词,还能改变作画的风格,比如下面这张赛博比卡丘(Cyber Pikachu)就偏2D风格。

Cyber Pikachu

Cyber Pikachu如果再加上“4k, intricate details(复杂细节), cinematic(电影效果), hyperrealistic(超现实), raytracing reflections(光线追踪反射), 3d matte painting(3D无光绘画)”这么一长串的限定词,就能够做出光影效果特别棒的3D渲染效果图。

pikachu, cyberpunk style, 4k, intricate details, cinematic, hyperrealistic, raytracing reflections, 3d matte painting

pikachu, cyberpunk style, 4k, intricate details, cinematic, hyperrealistic, raytracing reflections, 3d matte painting乍一看这些图渲染精度都挺高的,但也会存在明显的细节错误。

比如不管我怎么画,都没看到比卡丘那个标志性的闪电尾巴,也经常会出现一些低级的作画错误,比如画人类的手对AI就是老大难问题。看得出,抠细节目前还并不是Midjourney的强项。

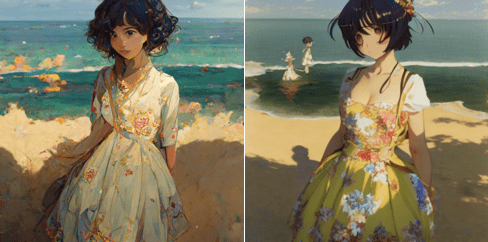

再比如最近很多人尝试让AI画二次元萌妹,拿出了一堆关键词,我也用大佬的关键词试了一下,想要得到好看的妹纸还要多次迭代,挺看运气的。

逐步迭代成形的多细节二次元萌妹

逐步迭代成形的多细节二次元萌妹那它更擅长什么呢?

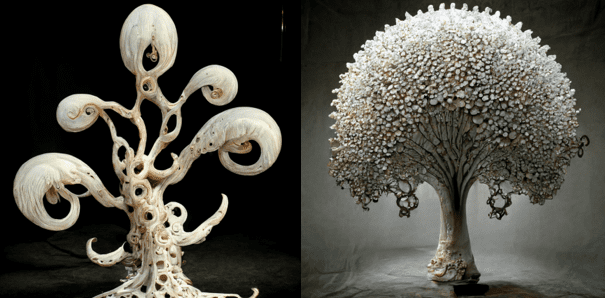

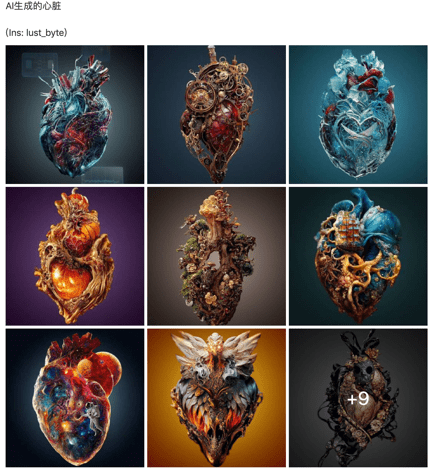

经过两周多的深度体验,我发现Midjourney对于不用太抠细节的大场景绘制非常出色。比如群里的小伙伴说自己梦到“充满科技感的盘根错节的大树”,经过一段时间的尝试,我就得到了一些相当符合她要求的作品。

white mechanical banyan, science fiction style

white mechanical banyan, science fiction style当然,开始也整出了一些相当掉san的玩意儿……而且我发现,这个AI对于克系元素把握相当出色,还真的是万物皆可“克苏鲁”。

a tree made of many white mechanical octopus foot

a tree made of many white mechanical octopus foot还有就是对于一些日常用品和猫猫狗狗什么的,Midjourney的正确率也相当高。而且如果还可以把这些东西融合起来,做出很多有趣的设计,比如下面这组“元素猫(cat made of XXX)”:

cat made of XXX

cat made of XXX其实,只要玩得够久,AI总能阴差阳错地画出几张非常漂亮的图,哪怕它已经和最开始的需求相差万里了……

但这个过程就跟刷短视频上瘾一样,总是能给我带来一波又一波的惊喜:

03AI作画是如何炼成的

经过成百上千张图的尝试,我们可以总结一下目前以Midjourney为代表的AI作画特点:风格、创意、构图、颜色搭配上,对于我这个外行人可以说是无可挑剔,但作画细节还很经不起推敲。

这个就特别AI,总会在你意想不到的地方惊艳,也会在你觉得理所应当的地方差强人意。

可即便如此,AI作画也已经足够惊艳了,两年前的我们恐怕根本想不到AI能进化到这种程度。很早之前,AI就能很好地将图片分类,甚至在围棋和《星际2》上爆打人类,今天的AI和当时相比又有哪些进步呢?

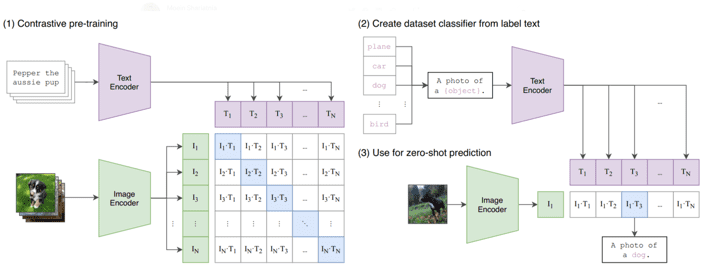

在去年,OpenAI通过4亿张网络图片,训练出一个叫做CLIP的AI模型。和之前那些做图像分类的模型不同,CLIP的作用是把图像和文本做关联,训练的目的也不是为了分类,而是判断文本和图像是否匹配。

因为网络上的图片普遍是带有描述它们的标签的,而且图像的类别更丰富,内容也更复杂。以往的训练集标签可能只是“猫”、“狗”、“卡车”这样单一的标签,但网络图片可能是“一只狗在车上玩球”这样复杂的描述。

CLIP模型

CLIP模型训练后,CLIP模型的任务就是根据输入的文本描述,提炼出这段描述中包含的图像特征。比如说,“红色的深浅”就可以是一个维度,“圆润程度”是另一个维度,“光泽程度”也是一个维度……

根据这三个维度,就可以在一个三维空间内定义特定的物体,比如一个“红色金属圆球”。

但这几个维度显然是不够的,CLIP最终能够提取几百个“特征”,形成一个人类根本无法理解的超维度空间。这里有趣的地方就来了,AI对于特征的理解,可能和人类完全不一样。

比如人类理解的是“高矮胖瘦、红橙黄绿”这些比较视觉化的特征,但AI眼中的特征……很多可能人类根本无法理解。但由于训练数据足够庞大且复杂,AI就可以通过这几百个特征,找到输入的描述在超空间的位置。

几百个特征就可以包罗万象了么?还是那个问题,也许对于人类不可能,但对于理解更抽象特征的AI就不一样了,虽说现在的AI想理解所有的概念还不现实,但对于生活中常见事物的理解其实已经非常到位了,甚至能融合两种根本不沾边的事物。

CLIP模型之所以效果这么好,关键是用了4亿张网络图片来训练,这个工作量可以说是非常恐怖了,也只有OpenAI这种行业一哥能把持得住。这个模型其实早年间就提出过,但因为数据量不够,效果并不理想。现在这一波可以说是力大砖飞了。

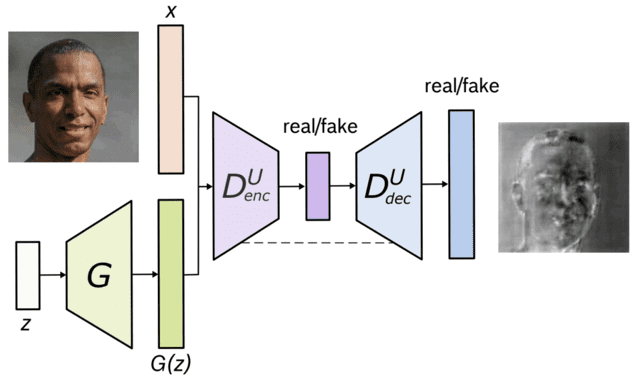

理解了输入文本的含义,得到了抽象的特征后,接下来就要生成图像了。在图像生成算法上,AI也经历了一次重大的升级。之前普遍用到的是“对抗生成网络(GAN)”模型。

对抗生成网络

对抗生成网络简单来说就是一个AI专门负责画画,另一个AI专门负责判断它画的好不好。

这两个AI一开始可能都很菜,但在二者不断“相爱相杀”后,就会像鸣人和佐助一样共同进步,从而让生成的图像越来越符合要求,各种基于对抗生成网络的模型也此起彼伏,比如英伟达用来生成真实人脸的StyleGAN。

StyleGAN

但也就在今年,对抗生成网络被一个叫做扩散模型的算法给打败了,逐渐成为了现在主流的图像生成算法。

扩散模型

扩散模型让AI作画名声大噪的Dall-E 2就是通过“CLIP模型+扩散模型”,来实现“文本生成图像”的飞跃式进步的。虽然OpenAI官方并没有开源Dall-E 2,但他们却把CLIP模型开源了,这才让一大波民间的AI作画应用普及开来。

像是现在效果比较好的Midjourney和Stable Diffusion,它们的兴起也就是两三个月的事儿。

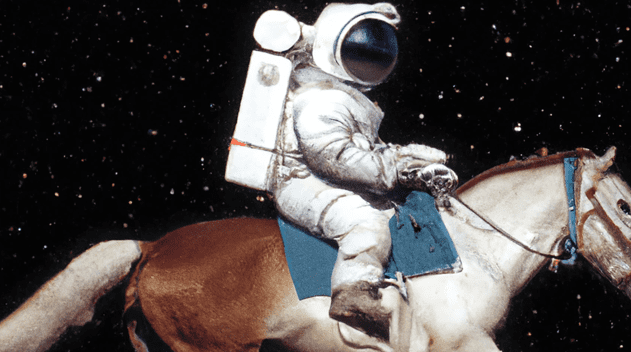

Dall-E 2的成名作

Dall-E 2的成名作更让人意想不到的是,似乎AI界现在已经不满足于单纯生成图像了,视频也开始安排上了,绝望的看来不仅是设计师和艺术家了,难道视频剪辑和后期的岗位也岌岌可危了吗?

04版权与偏见

虽然AI作画初出茅庐就大杀四方,但其实它本身也是存在问题的。

比如让人很头疼的版权问题。

就拿Midjourney为例,理论上付费用户生成的图片不存在版权问题,但在实际使用中还是会产生诸多问题。比如我用它画了个米老鼠,然后商用了,那迪士尼会不会找我麻烦?

理论上AI作画的原则是要避免出现现实中特定的人,毕竟不管是出于政治还是隐私问题都挺麻烦的。

但也不知道是由于疏漏还是单纯乐子人心态,“Trump”一直都没有被列入Midjourney的屏蔽敏感词。输入“川普+克苏鲁”,大部分出图还真就挺地道的,川普的发型,没个几百张图片估计是学不来的。

还有一些人通过AI作画看到了商机,把自己通过AI生成的图片大量地挂到各种付费资源网站来售卖。他们是爽了,但这对平台方可能就不爽了。

这同样涉及到AI训练集的图片来源问题。比如CLIP的4亿张网络图片,保不齐就存在一些侵犯肖像权的问题。

比如有人就在LAION数据集中发现了自己早年间去医院看病的照片,这个数据集就曾经被Stable Diffusion使用过。当时拍摄是出于治疗目的,但她不知道为啥这些照片就流传到网络上了。

那通过这些存在侵权问题的样本生成的图像,是不是也存在这些侵权问题呢?至少现在哪个国家的法律都是模棱两可的,毕竟严格来说,画画的是AI不是人,貌似还没有给AI定罪的法律吧!

最后,训练用的网络图片可能本身存在由于文化和语言带来的偏见。比如在Midjourney上用CEO作关键词,大概率生成的是欧美人形象。

从原理上来说这很正常,毕竟训练的样本可能大部分来源于谷歌,但从结果上来说,这是否也让AI带有某种与生俱来的偏见呢?

再比如训练模型对于中文的支持非常差,但如果全部翻译成英文,就会出现很多奇怪的bug,就比如前面提到的:Midjourney至今还不认识岩王帝君,想要个齐天大圣却总是画一个太阳。

最好的办法当然是我们要有属于自己的中文AI大模型,各个大厂其实已经低调搞了很久了。拿我最爱的双马尾、白发红瞳老婆测试了一下,虽然可拓展延伸的选项没那么多,但出图可以说是深得我心啊!

最关键的是,直接输入中文就行了啊!很多国人的XP你告诉我要怎么翻译成英文啊!

虽然想要让它生成个“钟离”也不太现实,但最起码这个人物画风、穿搭、背景风格,确实有那个意思了,第四张是琴团长和爷的合体吗?用国产AI来做原神二创,是真的未来可期。

尾声

发现了么?几年前AI还只是一帮算法工程师们琢磨的高端玩意儿,不仅效率低,还特别的“人工智障”。如果什么产品说用到了AI技术,大概率是在割韭菜。

但也就这几年,AI的发展速度突飞猛进,虽然依旧缺乏常识,但它不仅不再智障,还一跃成为各行各业的潜力股。到现如今的AI作画,甚至已然成为每个普通人都能触及的工具。

那回到最开始的问题,AI作画会抢走人类的饭碗吗?这个问题得从短期和长期来看。

从短期来说,AI作画虽然整体的画风和氛围非常到位,但具体的细节表现不仅差强人意还毫无常识。比如有做独立游戏的群友想要画个二次元弓箭手,虽然整体观感出来了,但AI始终画不好弓箭的结构。想要AI自己画出完全符合要求的图几乎不可能,还是需要设计师或者艺术家来精雕细琢的。

而且AI并不是一个足够听话的“乙方”,人类设计师可以根据甲方的需求对图像进行像素级的修改,哪怕是“五彩斑斓的黑”也能给你糊弄出来。

AI的脑回路就离了大谱了,虽然不知疲倦任劳任怨,但它好像永远都得贯彻点自己的想法,从而忽略部分具体的需求。往往你提的要求越具体,它就越是唱反调。

所以,现在的AI其实更适合做前期的创意支持工作。比如我是一个经验丰富的设计师,接到一个甲方的需求,但我脑子里暂时没啥想法,那我就可以先跑几张AI画的图找找灵感,毕竟“脑回路”跟人类不太一样,说不定能有一些让我耳目一新的创意,然后自己再动笔就能起到事半功倍的效果。

对于一些没学过画画、又急需美术资源的人,AI作画的作用就更大了。

比如我是个独立游戏开发者,想做一个文字AVG游戏,但我请找不到美术设计,直接用现成的资源还能有版权问题,用AI作画不就行了吗?

比如我就可以用Midjourney来画它最擅长的场景图,再用Crypko生成个二次元半身立绘,组合一下是不是有那味儿了?

所以我认为,无论你是不是美术从业者,短期内AI都不会让人类丢掉饭碗,它还存在不小的短板,需要更多算法的迭代和样本的投喂。

从长期看呢?如果AI通过几个版本的迭代补齐了自身的短板,甚至还能自动把图像分图层、做成工程文件来让人调整细节,哪些人会受到影响呢?

我认为,对于行业大佬和绘画小白来说,AI可能依旧是很好的辅助工具,最尴尬的是那些处于中间段位的选手们。

一个初出茅庐的画师,养家糊口都是问题,本来就少有时间精雕细琢自己的作品,现在还突然蹦出水平不错的AI,最可气的是你还未必画得有它好,十几年的磨练还不如喂几个月的数据,是谁都会受挫的。而且从公司成本考虑,如果AI比绝大部分画师画得好,那老板很难不心动啊,传统的美术岗位可能真的会被AI取代。

但这也许不意味着很多人会失业。在这里我大胆脑补一下,不久后会诞生一个新的职业,叫做“AI吟唱师”。

就像奇幻作品中的大魔法师利用超长的吟唱和复杂的符文构建高位魔法一样,AI吟唱师通过熟练运用各种AI的特性,挑选一长串复杂的关键词,让AI生成符合需求的图片甚至视频。这个岗位仍然需要有经验的画师来完成,到那时,原生的创意和审美和审美可能会更偏重一些。

想要AI听话,需要吟唱的关键词还挺多的

这可不仅仅是美术行业的问题,未来的AI,肯定会涉足写作、编程、视频后期等领域。这个未来何时会到来呢?

还真不好说,毕竟AI的进步速度已经远超人类的想象了,我们与其抵制浪潮的到来,不如先学会游泳。毕竟作为人类,作为AI的创造者,我们总能找到出路。

纵观历史,蒸汽机、摄影、火车、交流电、电视、电脑、手机、互联网,新技术的诞生总会让一些人感到恐惧。但事实证明,只要给予足够的时间,哪怕会产生波澜甚至动荡,人类总能和新技术的产物和谐共处,带来一次又一次颠覆认知的变革。

我们能够驾驭过去的技术,AI又有什么理由不行呢?