本文来自微信公众号:硅星GenAI(ID:gh_e06235300f0d),作者:椒盐玉兔,题图来自:Groq

首先得说一下,区别于 Gemini 或者 GPT,Groq 不是一个模型,而是自研的 TSP 微架构。Groq把开源的 Llama 2 70B 和 Mistral 8x7B 塞到了其特调的芯片上,实现了极其离谱的速度,具体有多离谱呢?这里列一些对比。

首先,上场的基准选手,也就是 驰名中外的GPT-4,速度上的显眼包。回答问题时,是这样的:

GPT-4,哎,不多说了……

接下来,让我们看看由 Groq 加速后的 Llama 2 70B:

右上方计数器 278 T/s,折合差不多200个单词/秒

以及,Groq 代理的 Mistral 8x7B:

又快又好!右上方计数器 408 T/s,折合差不多408个单词/秒

上面的测试里 Groq 的速度已经足以让人吃惊了!

接下里我们从理解能力、生成能力、逻辑推理、翻译能力、情感分析、常识判断等六个维度更直观地看三个模型的效果如何。

测试成员从左到右依次为:

GPT-4、Groq 的 Llama 2 70B、Groq 的 Mistral 8x7B。

请三位选手开始表演:

首先是理解能力:二者回答都很流畅,没有出现明显的事实性错误。

提示词:概述光合作用的过程

生成能力:二者在故事生成上表现均不错,若论生成速度,则 Groq 取胜。

提示词:根据以下提示编写一个短故事:“在一个风雨交加的夜晚,一位老船长发现了一张古老的藏宝图。”

逻辑推理:针对这个简单的勾股定理问题,Groq 回答约 158KM 而正确答案是约112KM。但是它对题目的理解和计算过程都是对的,属于典型的过程对了但答案错了。最后开根号没开对。

提示词:一列火车东行50公里,然后向北行驶100公里。从起点到终点的直线距离是多少?

语言翻译:在这项测试中,GPT-4 表现不错,但 Groq 无法完成测试。

提示词:翻译内容选自论文《Attention Is All You Need》

不过除了中文以外,Groq 在其他语言翻译上的表现还是相当不错的。

目前 Groq 可以理解中文提示词,但无法生成高质量的中文回答。

情感分析:在这一部分,Groq上的两款模型跟 GPT-4差距不大。

提示词:分析以下评论的情感倾向:“我简直不敢相信我花了这么多钱在这个产品上,完全不值!”

最后是常识判断:两者都给出了足够可信的回答。

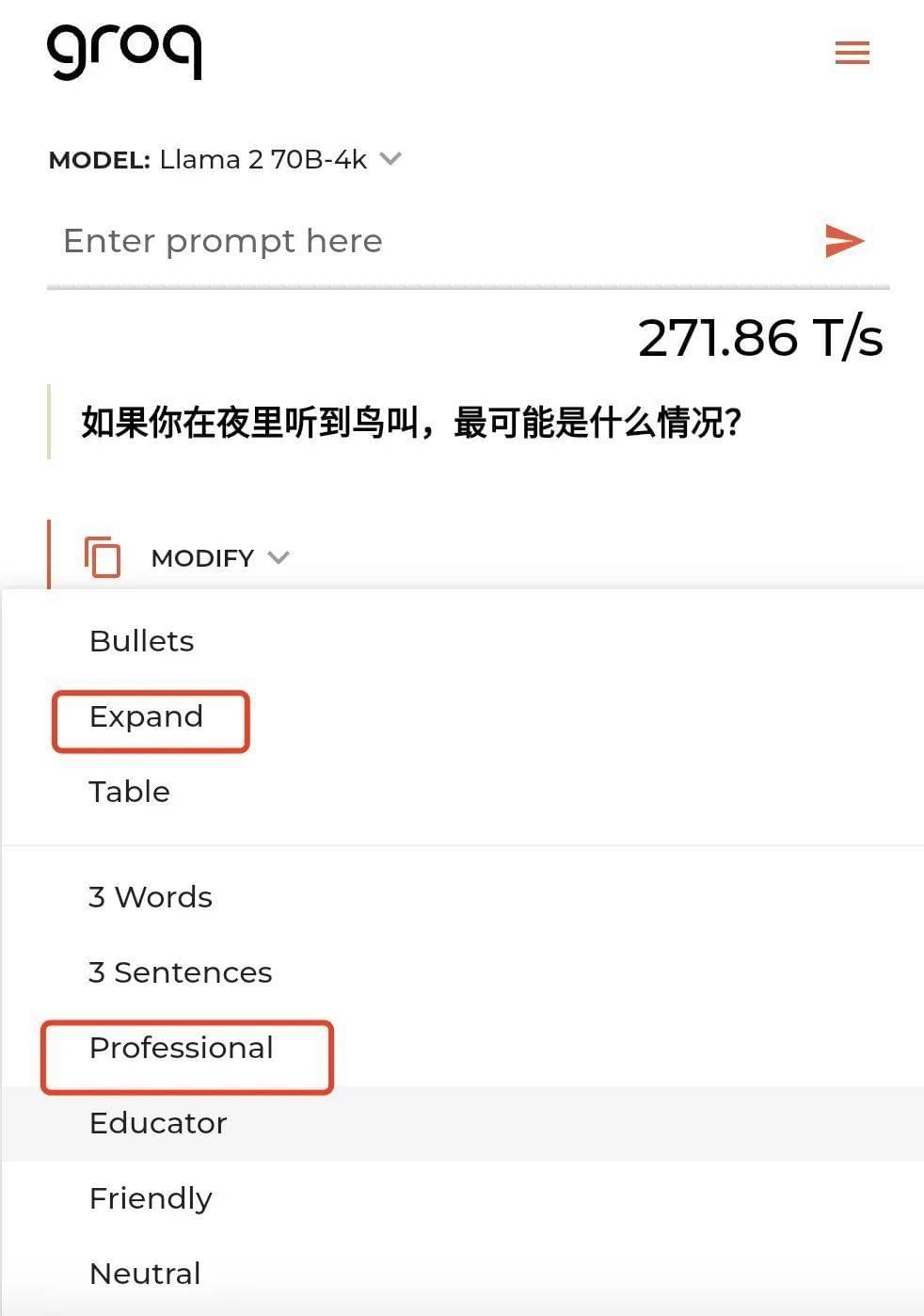

提示词:如果你在夜里听到鸟叫,最可能是什么情况?

测试动图全程无加速,这种速度感第一次体会到是在去年第一次用到 Bard 的时候。在开源模型上这还是第一次。

除此之外还有一个有趣的地方:

在 Groq 的回答完成之后,还可以更改生成的选项,即时生成或者扩展回答内容,选项如图所示:

对于生成类型有不同的设置,选择的类型不同,生成的结果也不大相同。而在 Professional 这个选项下无论是 Llama 2 70B、还是 Mistral 8x7B,不仅生成速度又长又快,还可以选择不同的领域和功能,比如 Table(表格选项)、Professional。具体操作可以在生成之后,根据自己的喜好进行不同的选择。

Table 选项:Llama 70B-4K 直接切换成表格

而 Mistral 8x7B 则在此设置下无响应,直接罢工了!

Professional 选项:二者可见速度和答案都跟之前的大不相同

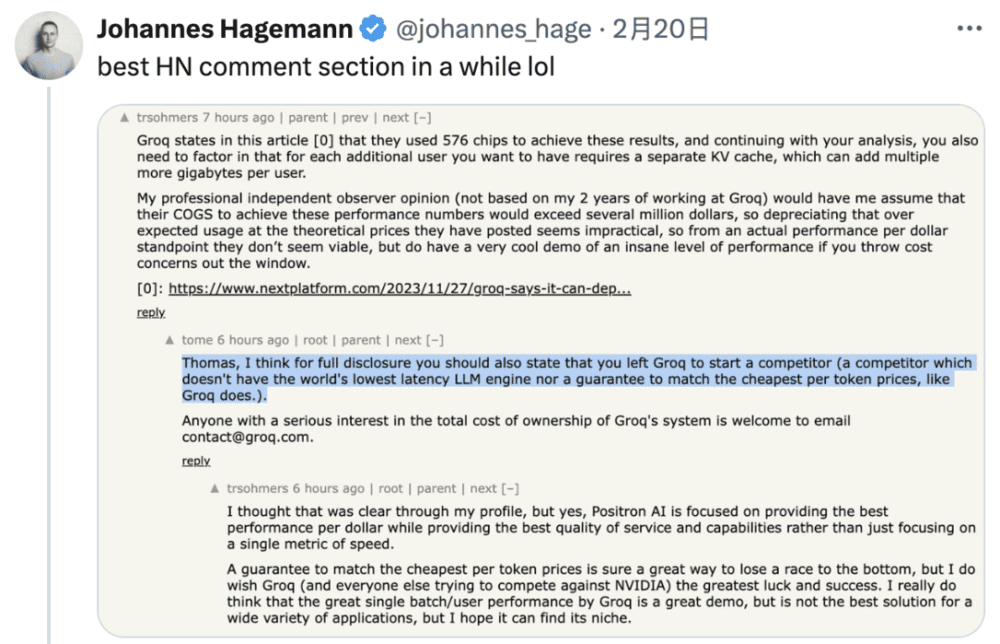

Groq 的员工最近在 Hacker News 上异常活跃,参与着一个又一个讨论。

有时候技术的讨论还会演变成“我家儿子比你家儿子多考了 2 分”这种骂街式争吵。

不管是直接在生成结果的时候还是右上角给 Token 的调用速度标出来,还是通过员工在各个渠道上的活跃,至少 Groq 相比于其他加速卡,被更多人看到。

体验过了 Groq 的生成速度之后,越看 GPT-4 越不顺眼了。

本文来自微信公众号:硅星GenAI(ID:gh_e06235300f0d),作者:椒盐玉兔