近日,知名爆料人古尔曼(Mark Gurman)说苹果iOS 18或迎来公司历史上最大的更新。

咱还蛮激动的,这2024年了,要说什么最令人激动,那肯定是往手机里加了AI功能。

刚过去的CES上各种AI硬件花活,像R1这种的,让我单买一台不现实,但装进iPhone喂到我嘴里用,那必须支持。

来源:推特

再仔细看看,据古尔曼说,iOS 18会在以下几个方面加入AI功能[1]:

Siri:用大语言模型(LLM)让Siri变得更智能

Messages:根据上下文和意图,自动补全问题和句子

Apple Music:根据用户习惯偏好,自动生成播放列表

iWork:在Keynote和Pages中加入AI辅助功能

Xcode:增加AI代码提示功能,提供更高效的应用开发体验

等等,就这?LLM接入手机,华为、小米、荣耀、vivo、OPPO、三星去年都已经交卷了。

至于办公辅助,WPS、腾讯文档、微软的Copilot、谷歌的Duet AI都从公测开始正式收费了。

对咱中国消费者来说,这几个功能就没一个用得上的好吧!

更别说iOS 18预计今年9月上线,开发者测试版最早也要等到6月苹果年度开发者大会(WWDC)才有望露面。

几个月时间过去,市面上的竞争对手不知道又要推出多少绚烂的新功能,苹果iOS 18爆料的这点芝麻谷子瞬间不那么香了。

不过这次爆料好在不只是捕风捉影,苹果资讯网站9to5Mac在iOS 17.4测试版本的代码里找到了证据,起码苹果真的在往手机里塞AI了。

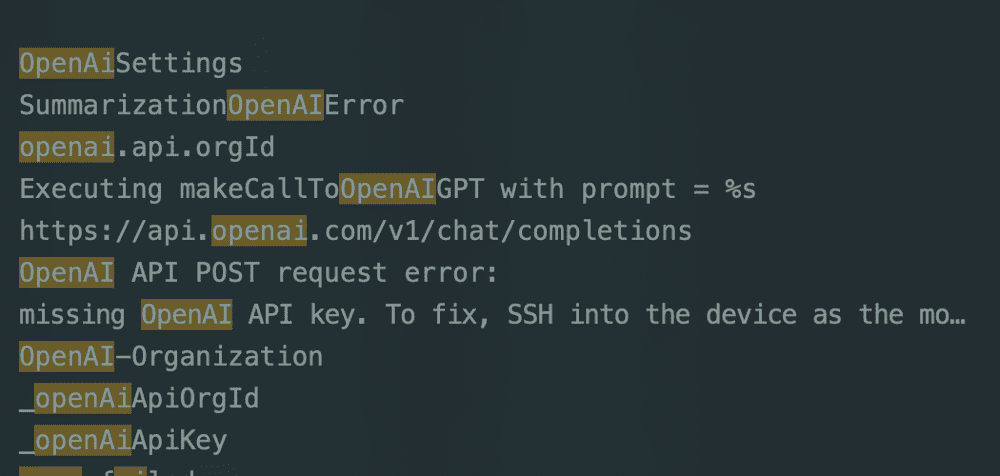

代码里出现了一个新的私有框架,叫做SiriSummarization。这个框架做的事情正如其名,调用OpenAI的ChatGPT API帮Siri做内容总结[2]。

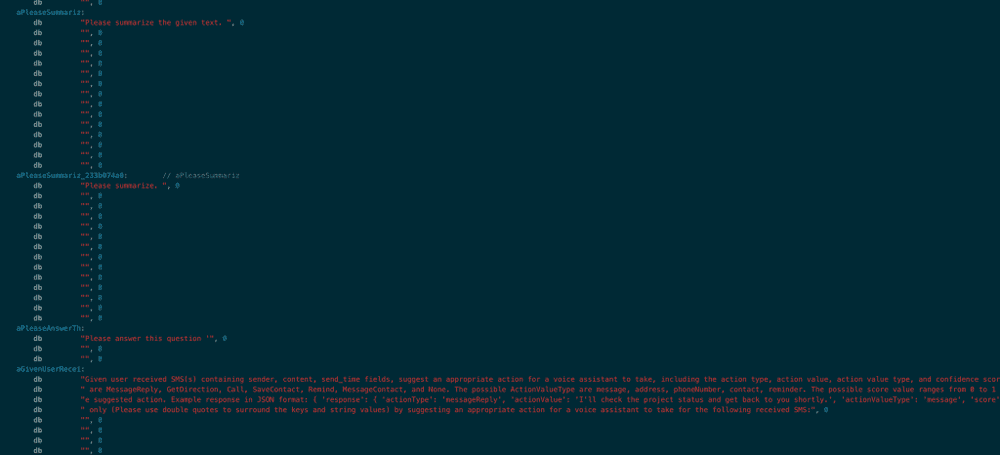

功能包括:“请总结这段文字”“请总结”“请回答这个问题”,以及收到短信后建议的操作方式(回复消息、呼叫、保存联系人等)。

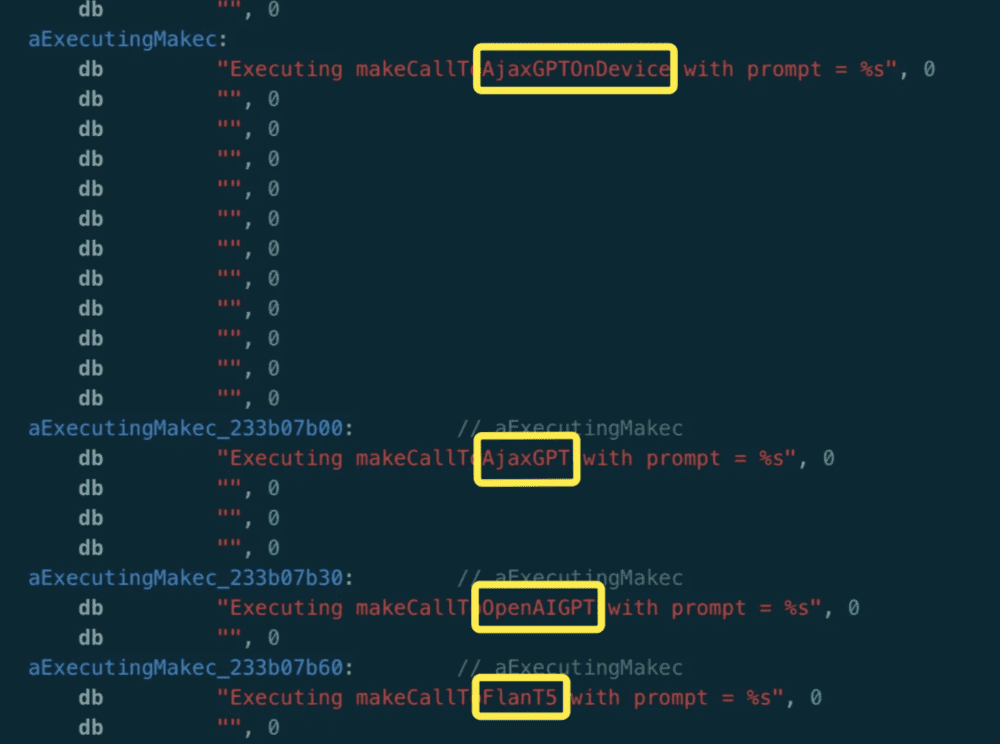

除了调用OpenAI的模型,SiriSummarization框架还调用了谷歌的Flan-T5,以及苹果自研的AjaxGPT和AjaxGPT On Device(大概率是一个参数量更小的端侧模型)。

这么看来,苹果应该是在用别家模型当对照组,跟自家开发的模型进行对比测试,就说苹果再想不开也不至于领着自家20亿用户去OpenAI门口送钱。

但这20亿用户苦等苹果精雕细琢的时候,就不会为其他手机心动吗?

在iOS 18爆料前不久,三星也正式发布了首款AI手机——Galaxy S24,在操作系统里集成了LLM,可在通话、笔记、相册里丝滑调用。

插个题外话,这手机全球版的AI服务由谷歌提供,国内版的AI服务由百度和美图提供。

华为vivo也都在自己的手机里装上了自家研发的大模型。

等来等去,苹果成了那个唯一还没正式发布LLM的手机厂商。

怪不得即使苹果超越三星成了全球“智能手机出货量全球第一”,华尔街分析师仍然觉得苹果的霸主地位会被颠覆,原因很简单:“苹果并未在AI和LLM领域深入布局,随着AI的发展,苹果可能会被微软、谷歌和亚马逊超越。”[3]

人家说得很严谨,不是苹果没有布局AI和LLM,而是没有深入布局。

在过去一年大模型百家争鸣的时候,苹果就已经慢了一步。

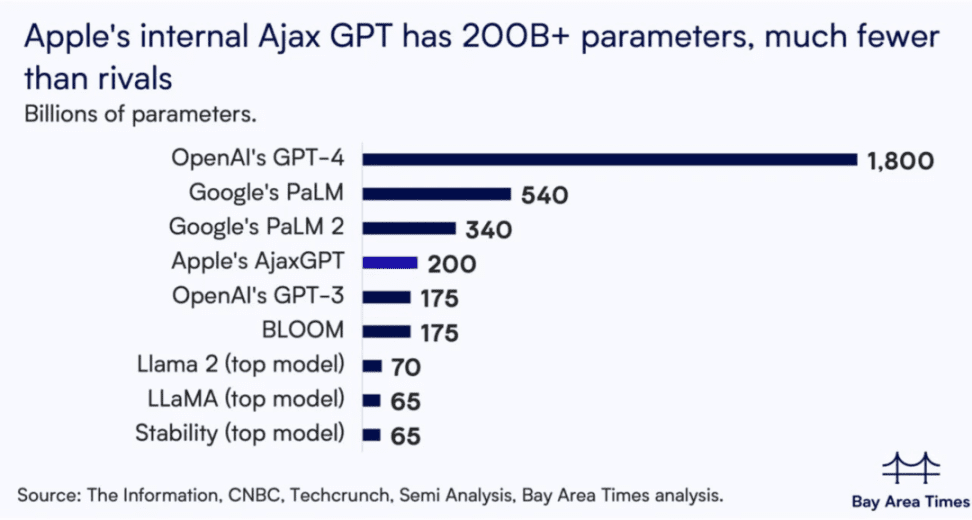

2023年7月份,万众瞩目的苹果自研模型AjaxGPT首次曝光,拉动其市值增长近700亿美元[4]。

当时,苹果内部成员认为AjaxGPT的能力超过了OpenAI的GPT-3.5。

然而此时GPT-3.5都是2022年的明日黄花了,距离GPT-4发布都已经过去4个月。

据知情人士透露,苹果公司管理层出于对隐私和性能的考虑,倾向于在设备上运行LLM[5],但是AjaxGPT作为一个参数量为2000亿的LLM,在定位上十分尴尬。

向上跟GPT-4比,参数量不够大,性能上不去。

向下跟Meta的Llama比,不够轻量级,想要实现端侧部署难度很大。

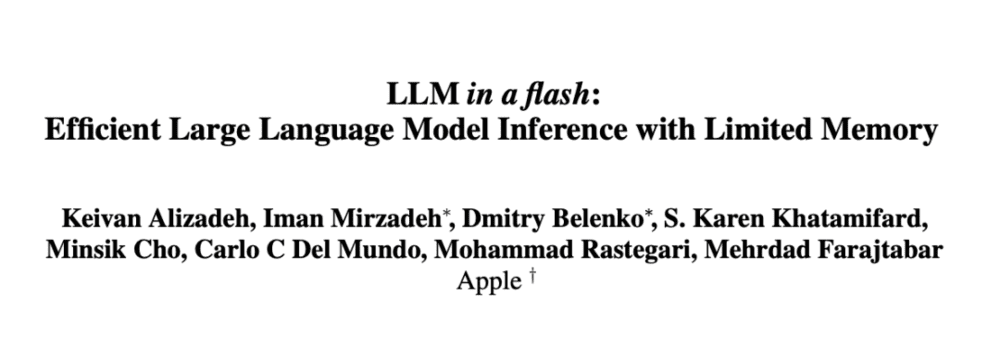

苹果不是没意识到这个短板,去年12月发了一篇论文试图把端侧AI门槛拉低[6] 。

论文中提出了一种让运行内存和闪存(可以理解为储存数据的硬盘)协同运行LLM的办法。

具体解决方案是把模型参数都储存在闪存里,当需要时再加载到运行内存中。

通过这种方式能在设备上跑得动比运行内存容量大两倍的模型,还能把CPU的推理速度提升4-5倍,GPU的推理速度提升20-25倍。

乍一看苹果把LLM端侧部署的难题给解决了,但是这个论文有两个前提:

仅适用于参数量为60-70亿的模型

整套框架是在M1 Max芯片上实现的,而移动端的A系列芯片性能显然跟M系列还有不小的差距

自研模型不过关的同时,苹果自有算力也远不如其它巨头。

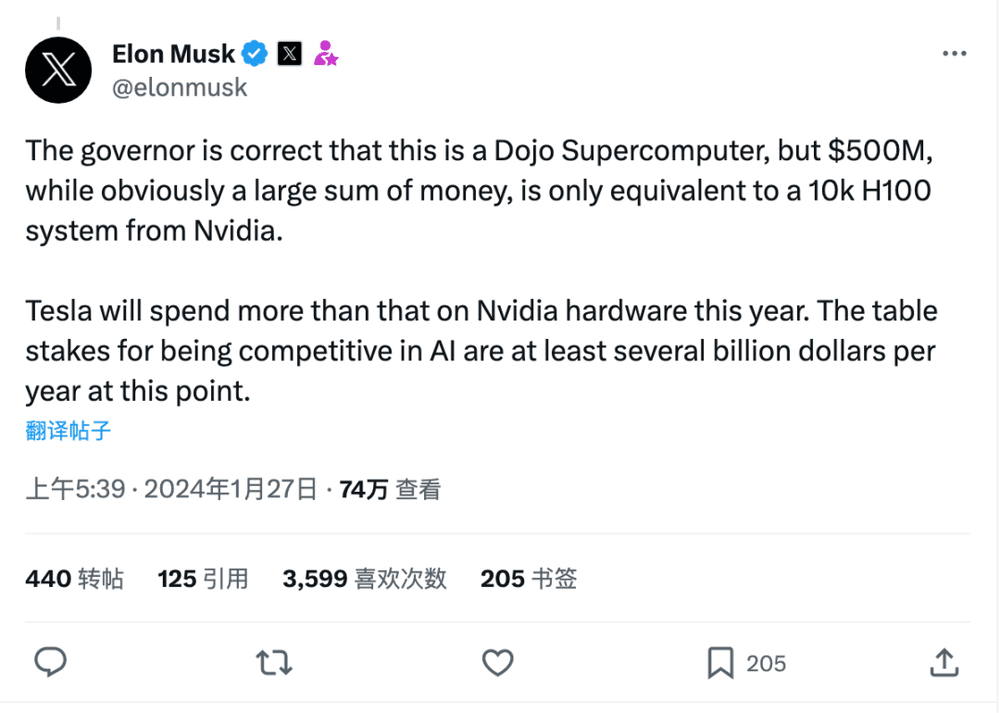

算力是AI军备的基础,前有Meta的扎克伯格说到2024年底要囤够35万张英伟达的H100,后有马斯克发推说5亿美元虽然看起来是一大笔钱,但实际上只能买1万张H100,而特斯拉今年买卡的钱肯定会超过这个数。

来源:推特

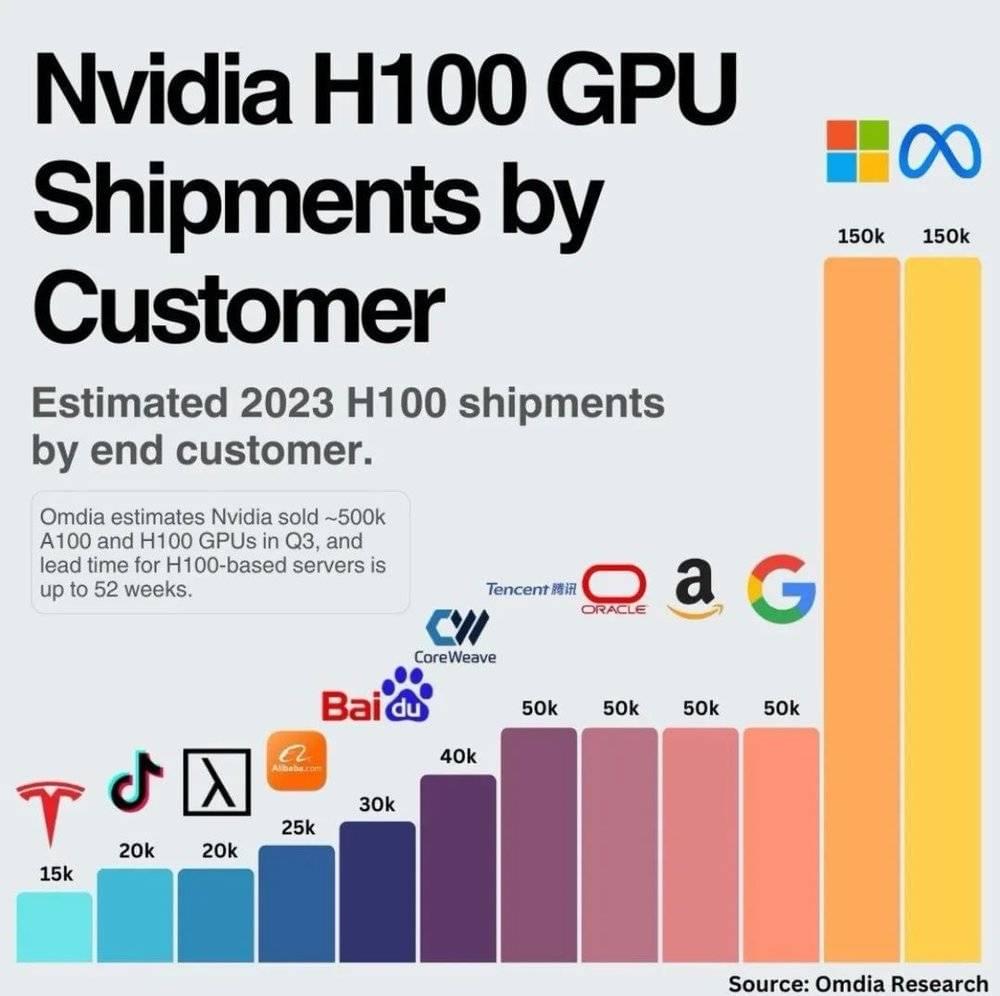

跟竞争对手们以万为单位的购入标准相比,苹果在囤卡的热潮中表现得异常平静,英伟达2023年第三季度H100显卡订单前12位客户中,当时还是全球市值第一的苹果居然没有出现。

来源:Omdia

据The Information的统计,苹果一直是全球最大的云服务租户,长期跟谷歌和亚马逊保持着合作,知情人士透露,为了节省成本,苹果管理层历来鼓励工程师使用谷歌的云计算服务。

大概就是因为苹果和谷歌曾经达成内部协议:苹果Safari浏览器默认搜索引擎使用谷歌,而谷歌云计算服务给苹果打折。

不过苹果也不是不着急,去年开始一直在招生成式AI(GAI)、机器学习(ML)、自然语言处理(NLP)相关的人才,截至本月苹果官网招聘的“机器学习和AI”分类下都能搜出600多条结果。

前不久苹果还花了5000万美元与出版商达成合作,合法获得了使用纽约客、名利场、GQ等杂志的内容来训练AI的许可,以免重蹈OpenAI和纽约时报的覆辙。

至于苹果每年花在AI上的研发费用,据不同来源分析可达10至50亿美元(所以说买卡的钱还是有的)。

The Information的一份独家报告还称,苹果有三个团队在同时训练不同的模型。

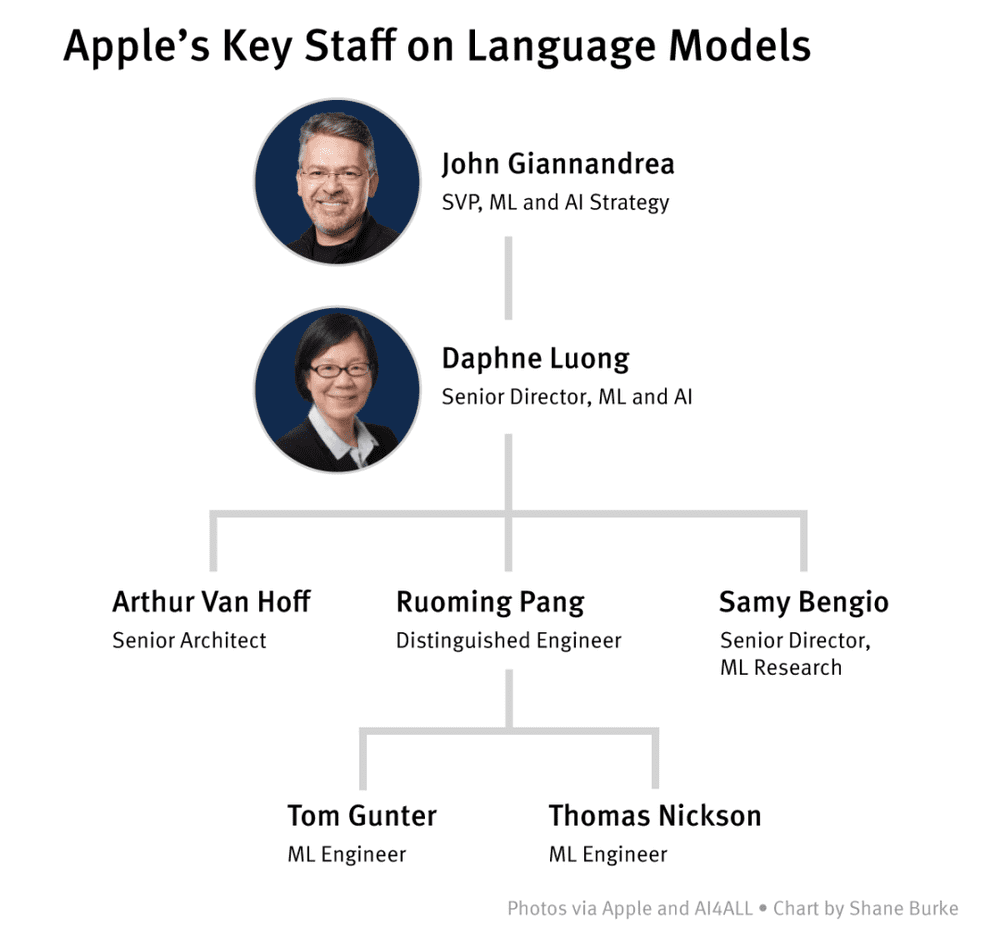

谷歌“出逃”AI总监约翰·吉阿南德拉(John Giannandrea)是整个团队的领导者。

约翰于2018年加入苹果,据说当时软件部门专门负责ML的程序员都没有,他知道自己身上的担子重了[7] 。

基础模型(Foundational Models)团队主要研究领域是LLM,最早由Java元老+VR先驱阿瑟·范霍夫(Arthur Van Hoff)在2019年创立。

2023年范霍夫退休后,团队由上交大毕业的前谷歌员工庞若鸣接手,目前整个团队约有16人,AjaxGPT便出自这个团队之手。

视觉智能(Visual Intelligence)团队的主要研究方向是图像、视频、3D场景生成,目前能查到的成果只有2023年发布的44篇论文。

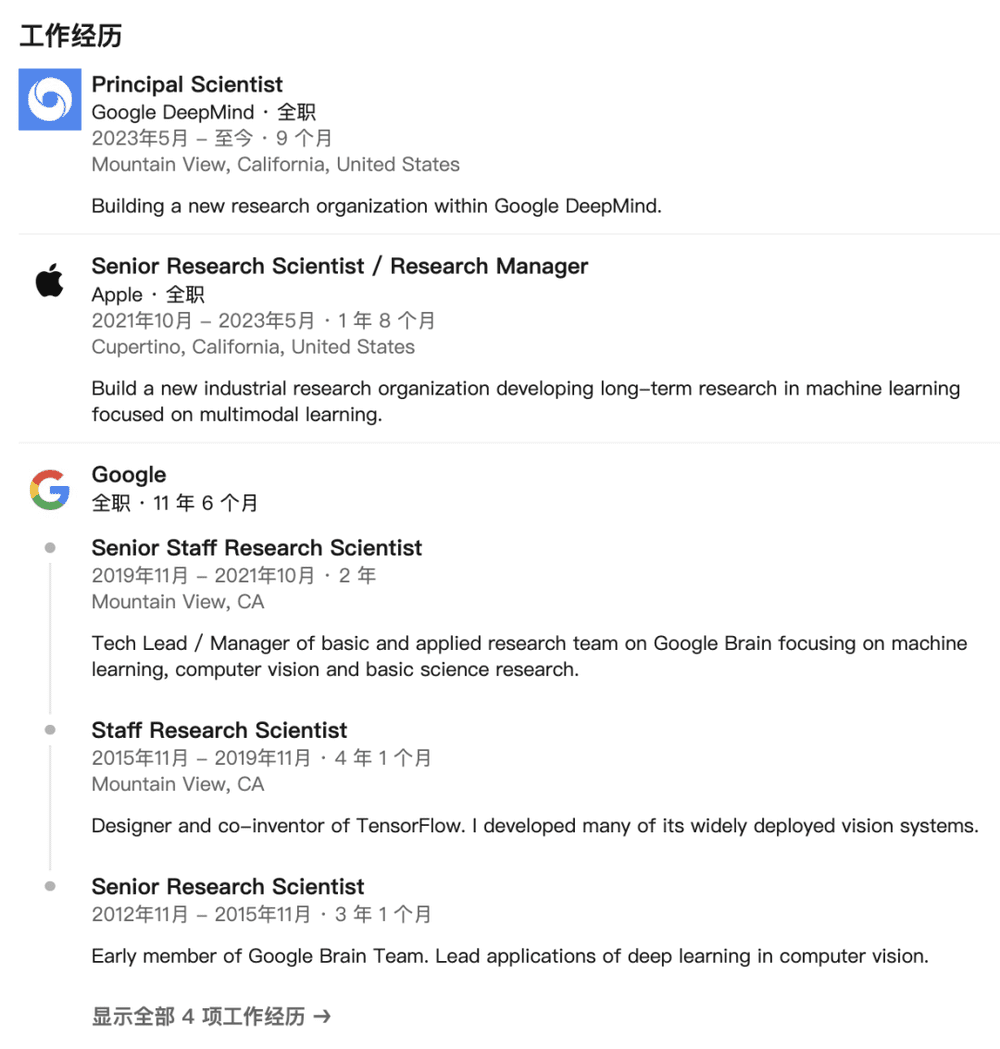

多模态学习(Multimodal Learning)团队的负责人是乔纳森·什伦斯(Jonathon Shlens),他从谷歌跳槽到苹果只待了1年零8个月,就又跳回了谷歌。

至于团队有什么研究成果尚不清楚。

虽然有消息说苹果的AI团队已经开发出了几个先进的模型,正在公司内部测试。

但一位直接参与开发的苹果员工透露,目前在测的只有一个用上了LLM的Apple Care客服机器人。

去年底,人狠话不多的苹果芯片主管约翰尼·史鲁吉(Johny Srouji)罕见地接受了CNBC的采访。

当被问到如何看待“现在大家觉得苹果在AI上落后了”这个观点时,他表现得丝毫不在意[8]:“实际上我们处于领先地位,作为一个团队,我们有芯片、有硬件、有软件、有ML,接下来只要朝一个方向优化就可以了。”

那这个优化究竟做得怎样,只有等4个月后的WWDC揭晓了。

参考资料:

[1] Apple thinks iOS 18 might be the 'biggest' iOS update ever | 9to5Mac

[2] iOS 17.4: Apple continues work on AI-powered Siri and Messages features, with help from ChatGPT | 9to5Mac

[3] AI到底给手机增加了哪些新东西?|36氪

[4] Apple GPT明年上iPhone!苹果被爆秘密研发Ajax框架,Siri大升级,市值几秒暴增千亿 | 新智元

[5] Apple Boosts Spending to Develop Conversational AI | The Information

[6] How Apple's AI advances could make or break the iPhone 16 | ZDNET

[7] 苹果发布会之外:“后来者”苹果,其AI研究观念是如何改变的?| AMiner [8] Apple Executives Johny Srouji And John Ternus Talk About Chips, AI And Innovation | YouTube

本文来自微信公众号:新硅NewGeek(ID:XinguiNewgeek),作者:刘白,编辑:张泽一,视觉设计:疏睿