本文来自微信公众号:晚点LatePost (ID:postlate),作者:贺乾明,编辑:黄俊杰,题图来自:视觉中国

一家公司宣称自己是人工智能硬件与软件的领导者,它将实现五十年来最激进的计算架构变革。

这句话出现在特斯拉今年 9 月 30 日召开的 Tesla AI Day 年度技术大会上,也可以用来形容英伟达在更早一周多召开的 GTC(GPU 技术大会)。

分别主导两家公司的马斯克和黄仁勋都是读书时移居美国并创业,如今各带领一家市值超过阿里巴巴的硬核科技公司。两人各 50 多岁,但依然保持对前沿技术的深层理解,能讲清楚细节。但相似到此为止,马斯克过着巨星般的生活,多任妻子十多个孩子、上节目抽大麻、习惯对一切发表评论、善于游说政策获得利益。黄仁勋私人生活低调,几乎不发表政治立场鲜明的评论,也几乎不游说政府——自 1993 年成立至今年 6 月底,英伟达在美国的游说开支为零。

两家公司一度密切合作,特斯拉造有自动驾驶功能的车,英伟达为它提供处理器。黄仁勋买过多代特斯拉车,马斯克去 GTC 站过台。直到 2019 年,特斯拉宣布新车改用自行研发的自动驾驶芯片。明年,特斯拉也将逐渐在数据中心采用自己的芯片替换英伟达产品。

造车的公司开始造机器人,造游戏显卡的公司几乎不在发布会上谈游戏。两家公司都将人工智能当作自己最核心的技术,对未来该是什么样子也有相同的看法。

这两家公司到目前为止还没有直接的商业竞争,特斯拉的芯片、软件只用在自己的硬件上;英伟达则将芯片卖给其他公司,既不造车、也不造机器人。和平未必能持续,特斯拉明确表达了将自己的芯片以云计算提供给第三方的野心。

PC 和智能手机时代的全球科技巨头,微软与苹果、Google 与苹果都曾有过无间合作,探索个人电脑和移动互联网的终极形态,但未来方向明确后便转为竞争,从商战一路走到诉讼。如果人工智能最终是下一代技术,特斯拉与英伟达走到这一步也没什么奇怪的。

汽车公司、游戏芯片公司……科技公司最终都是 AI 公司

马斯克:很多人认为我们只是一家汽车公司,但多数人不知道,特斯拉称得上现实世界人工智能硬件和软件的领导者。

黄仁勋:计算正以惊人速度发展。推动这枚火箭的引擎是加速计算,燃料是人工智能。

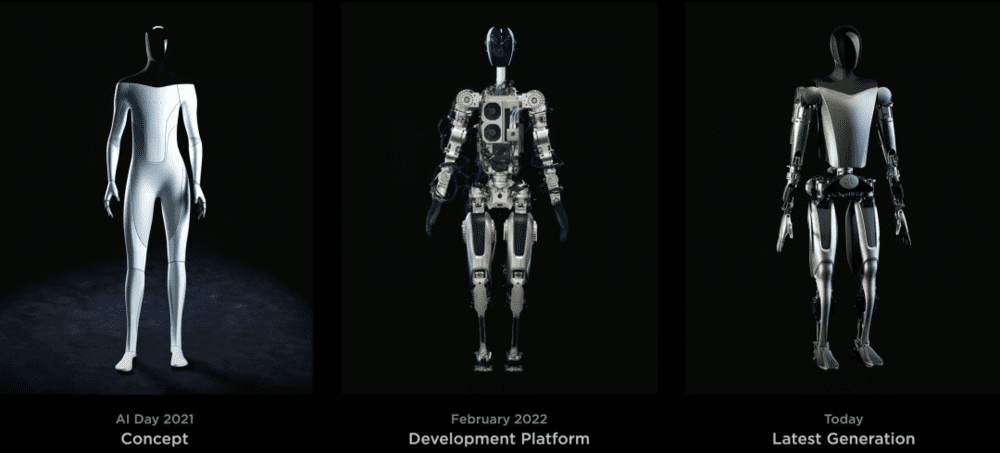

今年 AI Day,特斯拉初次展示了测试中的人形机器人 Tesla Bot。相比去年由真人套上紧身衣装机器人的 PPT“亮相”,真实的 Tesla Bot 没有那么多未来感,线缆裸露、双手动作缓慢、走起路来颤颤巍巍,临近的观众可以听到巨大的风扇响声。

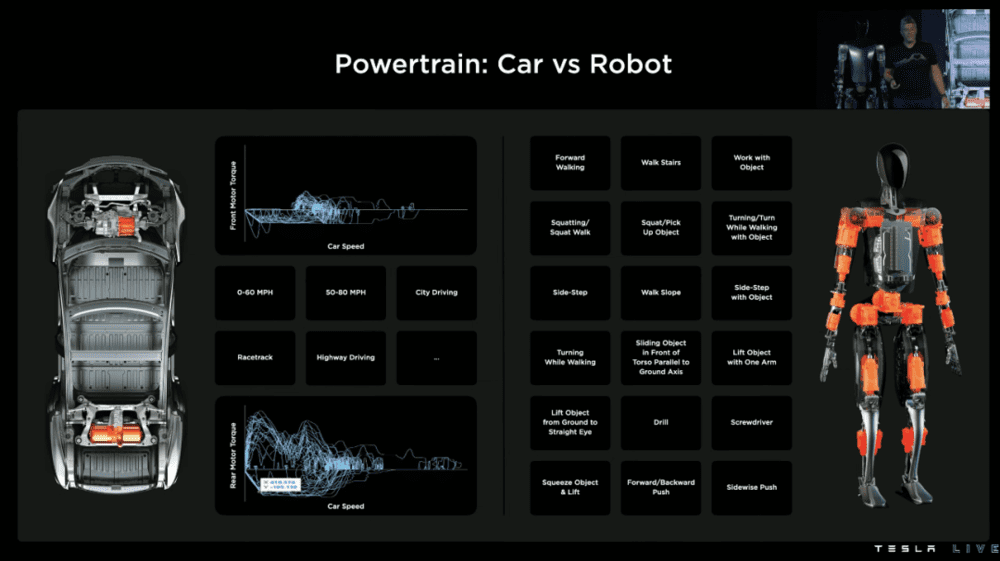

Tesla Bot 不灵活,波士顿动力的人形机器人五年前就能做后空翻。它的独特之处在于,Tesla Bot 就像是一辆行走的微型特斯拉汽车:胸前装载的 FSD(全自动驾驶)芯片——2019 年开始,每辆新生产的特斯拉汽车都有;传感器就是摄像头和麦克风,和特斯拉汽车用的也差不多。诸多软件和零件,都有互通。

Tesla Bot 像人一样,可以做多种工作:浇花、搬零件、送快递,虽然现在任何动作都非常慢。以往工业机器人每个动作都需要工程师编程,机器才会动。Tesla Bot 则是像特斯拉自动驾驶系统那样,用摄像头收集数据、训练系统,自主行动。

特斯拉的工程师在发布会上说,机器人的训练都不用从头开始,“Autopilot(自动辅助驾驶功能)上的计算机视觉神经网络”。不过车辆在一个平面里移动。人走路、搬东西要复杂得多。

Tesla Bot 的存在佐证了马斯克的话。特斯拉造车,但它最根本的是让计算机看懂外界环境、知道如何自动运行的人工智能技术。为了让人工智能算法更有效运作,特斯拉自 2019 年开始将车上的英伟达处理器换成自己研发的 FSD 芯片,训练算法的超级计算机明年会换成自研芯片 D1 搭建的 Dojo。

如计算机科学家艾伦·凯(Alan Kay)所说,“人要是对软件足够认真,就应该自己造硬件。”现在反过来也一样。

今年 GTC,英伟达如期发布新的 RTX40 系列图形处理器耗电巨大、成本也更高。黄仁勋解释说,因为“摩尔定律已经死了,芯片成本会逐渐降低的想法过时,计算是一个软件和芯片的问题”。

芯片的尺寸大致决定着芯片的成本,而芯片里的晶体管数量又决定着性能。根据摩尔定律,随着制造技术更精细,同尺寸芯片里的晶体管数量每 18 个月翻倍。现在芯片的制程已经小到 4 纳米,愈加逼近目前可以想象的极限。

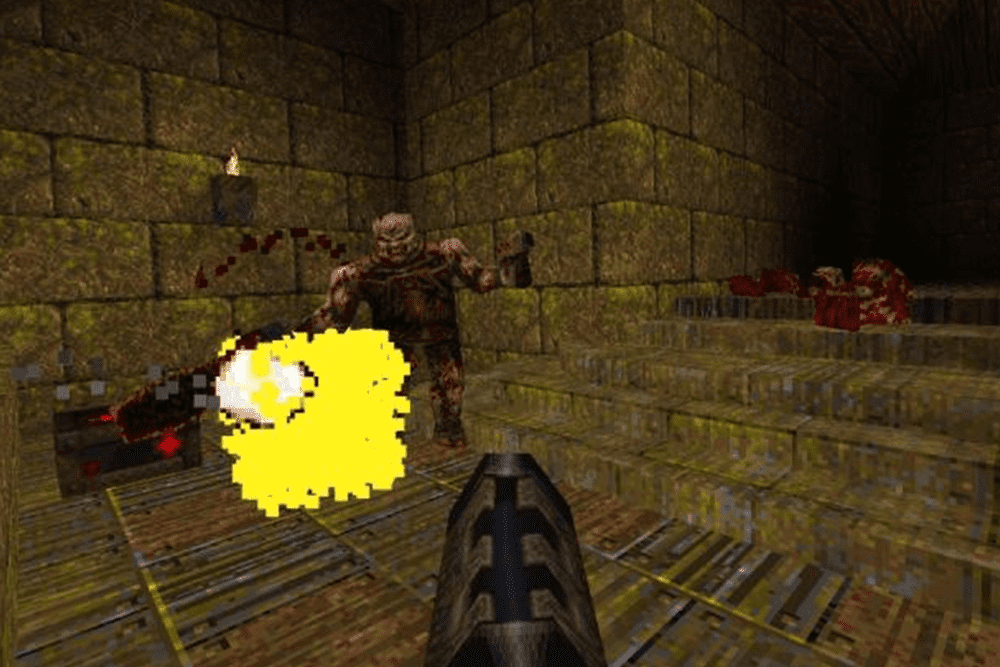

图:射击游戏画质变化,QUAKE(1996)vs COD: MW2(2022)

作为最早提出图形处理器(GPU)概念的公司,英伟达和老伙伴台积电配合,跟着摩尔定律跑了 20 多年,让游戏画面极致逼真。走到尽头之后,人工智能成为帮助提升效率的主要动力。

黄仁勋从 2016 年就开始强调摩尔定律已经难以为继,自己开发人工智能算法提升芯片运行人工智能算法的效率,每年都有大幅提升。他称之为 “超级摩尔定律”。

比如英伟达这次发布的深度学习算法 DLSS 3,能根据游戏不同画面之间的光线、角度变化,自动丰富画面细节,减少芯片的工作量,同时让游戏动画更逼真、流畅。

GTC 发布会后,黄仁勋接受科技分析师本·汤普森(Ben Thompson)采访,描绘了更依赖人工智能的虚拟世界。“未来更有意思的游戏会像 Minecraft 或者 Roblox。玩家自己在里面创造一个虚拟世界、改造这个虚拟世界。”

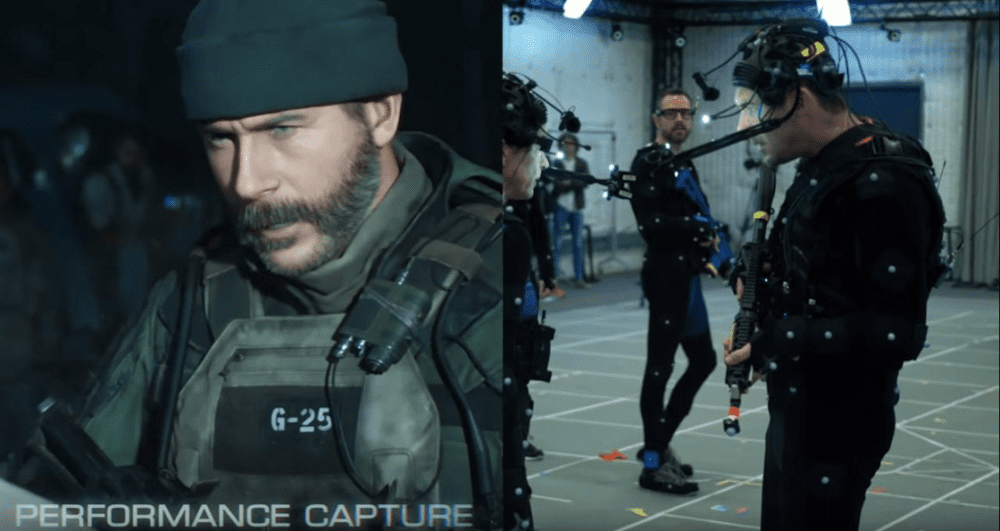

Minecraft、Roblox 都是沙盒游戏,画面简单,但玩家可以改变一切。如果想要以假乱真的画面体验,得看《赛伯朋克 2077》或者《使命召唤》,但这样的游戏和拍电影一样:数百名美工人员、工程师绘制、调整游戏里的每个细节,确保游戏里的光影效果逼真,不违和。每个人走路的动作都得用上好莱坞拍片的动态捕捉,这和拍一部电影没有太大区别,需要海量人力投入,研发成本上亿美元。

黄仁勋希望在虚拟空间里做到这样的画质,不需要每个步骤都有人干预,而是让玩家自己改变一些。这需要:

玩家可以完全创造一个拟真的世界、可以随意调整这个世界。

在世界里实现完全自然的物理效果。比如不同物体掉落在地,会有完全不同的反应。

游戏里有人工智能和玩家互动,比如玩家说 “建一座城堡”,人工智能会搭建一个漂亮的城堡,供玩家改造。

黄仁勋设想的每个条件,今天都有游戏能做到一部分,但没有一个能在三方面都做到极致。今天单个游戏开发成本已经可以超过 1 亿美元,最大的一项是人力。从工作室营造虚拟的游戏世界,到玩家的游戏机在屏幕上渲染逼真的画面,每个环节都将需要人工智能参与。

这届 GTC,黄仁勋主讲的发布会将近 100 分钟。直接与游戏相关的内容只占不到 20 分钟,剩下的时间都在展示英伟达的产品如何推动人工智能进步——比如新发布的自动驾驶芯片 Thor, 算力更强,支持更复杂的模型;新发布的 CV-CUDA 模型开源库,可以更快地处理图像任务, 如渲染、生成 3D 图像、视频推荐。

2010 年,Google 人工智能科学家尝试教神经网络识别猫,动用了 1.6 万个 CPU,而英伟达只用 12 个 GPU 就达到了同样的效果。从那时起,能够并行处理任务的 GPU,成为了人工智能领域最重要的硬件,推着英伟达快速崛起。现在英伟达的一半的业务与人工智能有关。

AI 的希望在大模型,正好是这两家大公司的生意

马斯克:如果你有几千万或几亿辆自动驾驶汽车,数量相当甚至更多的人形机器人,你会有规模最大的数据集。这些视频数据经过处理,汽车很有可能比人类司机更出色,人形机器人和人类难以区分。它们会具备通用人工智能的特征。

黄仁勋:接受过大量人类知识训练的大型语言模型,可能是有史以来最大的软件机会之一。它是当今最重要的人工智能模型。它让我们有可能解决以前从未解决过的问题。

1990 年代开始,经济学家提出“通用目的技术”(General Purpose Technologies)概念,认为通用的技术才能推动经济长期增长。比如轮子、青铜、铁、蒸汽机、内燃机或现代的计算机、互联网等等。

人工智能是一个宽泛、通用的技术,但到实际应用中并非如此。一个人工智能模型,通常只能解决一个任务。比如 2016 年打败围棋世界冠军的 AlphaGo,只会下围棋。

现在训练好一个模型,稍微调整就可以完成翻译、对话、阅读理解、续写内容、补充代码等数十种任务,表现比很多人好。比如 OpenAI 的 GPT-3,自动生成的文本能以假乱真。

它们之间最明显的差距是训练模型使用的数据量。AlphaGo 只输入围棋对弈数据,规模数千万局。而 GPT-3 几乎吞掉了互联网上大多数英文文本,从各种网页、新闻、食谱、图书到程序代码等,整个英文维基百科,只占它训练数据整体的 0.6%。

GPT-3 从这些数据中提炼规律和特征,将它们存到模型中,通常称为 “参数”,等到新的数据输入模型后,它们决定输出什么样的结果。GPT-3 有 1750 亿个参数,几乎能处理大多数文本信息,需要它去解决特定的问题,比如生成文本,只需要简单训练。因此,有巨大参数的模型也被称为基础模型(Foundation Models)。

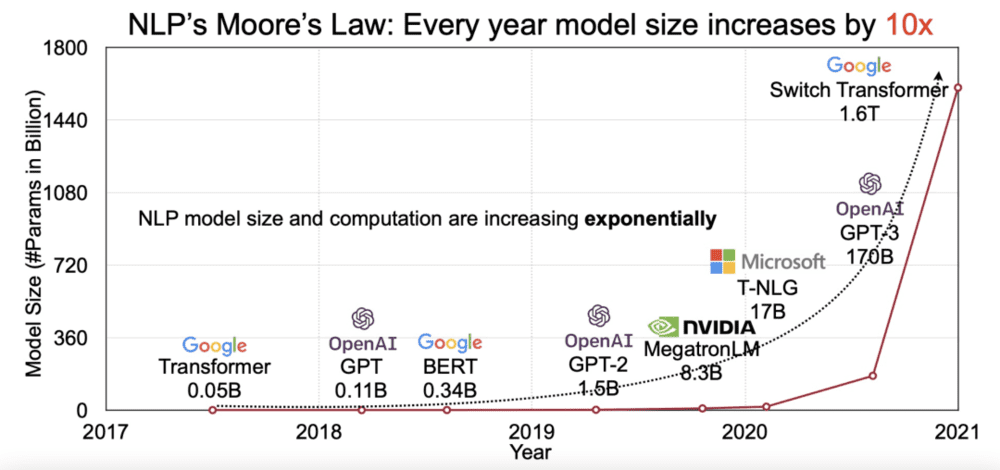

基础模型发挥出来的作用以及它可能的潜力,引发公司和机构争相入场,推着单个模型的参数破万亿。现在没有一个大模型,几乎都不能说自己是个前沿科技公司。

更大的模型要用更多 GPU,黄仁勋从来不吝啬对大模型的赞赏,从最重要的人工智能模型,到推动人工智能跳跃式发展,英伟达还和微软一起训练参数 5300 亿的大模型 “威震天”,和 GPT-3 类似,能当聊天机器人,可以阅读理解,翻译等。

具体到业务上,英伟达去年跟阿斯利康合作,训练了一个研发新药的大模型;今年交付的处理器 H100 专门为训练大模型优化,比上一代快 5 倍。这次 GTC 上,黄仁勋特意提到,新发布的自动驾驶芯片 Thor 会支持视觉 Transformer 架构——这是大模型的基础。

特斯拉也将大模型用到了业务中。去年的 AI Day 上,特斯拉透露使用 Transformer 架构训练大模型,把特斯拉上八个摄像机的信息融合成 3D 环境,提高系统认识周围环境的能力。特斯拉正在研发的超算 Dojo 也专门训练更大的模型做优化。

特斯拉的 Autopilot 软件总监阿肖克·埃卢斯瓦米(Ashok Elluswamy)在今年的 AI Day 上说,“人们认为我们没法用摄像头检测深度,(其他物体)的速度和加速度,用大型数据集和大型模型能让它变得更精准”。

今年 AI Day 后没几天,特斯拉宣布一些地区的 Model 3/Model Y 车型将不再搭载超声波雷达,只靠摄像头实现辅助自动驾驶。

技术将更普世,但需要有公司创造技术设施

马斯克:人形机器人成本可能不到 2 万美元。它的潜力令人难以置信,让人均生产力没有限制,意味着一个没有贫困的未来,一个人们可以拥有任何自己想要的产品和服务的未来。这是文明的根本转变。

黄仁勋:人们认为,人工智能将在更少的公司中聚集技术力量,但事实上,人工智能使计算机科学民主化。它使得任何人都可以编写软件,它使得每个人都成为创造者,它将使得每个人都成为游戏开发者。

这一代人工智能技术推进从 Google 开始不是巧合。这家公司 1998 年开始做的事就是理解全世界的信息,让人无门槛地找到自己想要的信息。从一开始的文字,到图片、地图、视频、自动驾驶、围棋、病例、医学影像……Google 训练人工智能理解一项一项更复杂的事物。

全球超过 20 亿用户提供了无穷无尽的数据,帮 Google 训练。这个过程里 Google 展示了无数广告,成为全球收入和利润都最高的互联网公司,因此有钱继续投入人工智能技术研发。

这因此引起了关于巨头垄断人工智能技术的担忧。大多数公司没有这样可以支持人工智能数据收集和研发的完美商业模式,得找新的路径。

2015 年,马斯克与时任硅谷孵化器 YC 的总裁山姆·阿尔特曼(Sam Altman)等人出资 10 亿美元创办了非营利机构 OpenAI,对标 Google 旗下的 DeepMind,研究友好的、开放的人工智能,称将与世界分享技术。投资方多有自己的公司,特斯拉、YC(在数百家创业公司持股)、LinkedIn、微软等,没有 Google、Facebook 那么多的数据,但也需要人工智能。

2018 年初,马斯克退出 OpenAI 董事会,理由是跟特斯拉正在做的人工智能研究冲突。当时特斯拉已经开始生产 Model 3,当年就成为销量最高的电动车型。

完美的自动驾驶商业模式成型:到现在,特斯拉一共卖出 300 多万辆车,大部分是 Model 3,其中 16 万辆车启用了 FSD(完全自动驾驶能力)、更多车辆启用了 Autopilot(自动驾驶辅助系统)。这些车主给特斯拉付钱都在帮助特斯拉积累数据训练算法、免费当测试安全员,财力雄厚的 Google 也只有大约 1000 台无人驾驶测试车。

积累数据、训练算法的同时,特斯拉也成为了一家年产过百万辆的车企,且车型极少。到 2022 年底,特斯拉的年化产能预计将突破 200 万辆。产能决定成本,而 Tesla Bot 复用了特斯拉汽车的相当一部分零件和技术。

Tesla Bot 的大脑用了为汽车设计的 FSD 计算机和视觉神经网络。电池的管理芯片和系统,也和车用的一样。特斯拉汽车碰撞测试中的模拟分析软件、力学分析模型等都用到了机器人上,尽可能减少重复研发。

马斯克说特斯拉现在的目标是“以最快的速度生产出有用的人形机器人”,有点用、大量用塑料造,尽量便宜——不需要完美,让更多的人愿意付钱购买就行。

这是特斯拉的人工智能研发路径,开发、大规模部署有自动驾驶技术的汽车,降低成本、让更多人购买,于是数据更多、算法更聪明、卖得更多更便宜,于是人工智能技术能被更多人用上。

英伟达则是压低技术的使用门槛。黄仁勋认为,计算机帮助社会的程度,限制不在成本,而是有多少人会编写计算机程序。

英伟达的显卡适合训练人工智能模型,但有门槛——它是为处理图形设计的,想用它训练神经网络,程序员得学习 OpenGL 等图形编程语言。

借助英伟达的软件平台 CUDA,不会图形编程的程序员,也能用自己擅长的编程语言,无障碍调用 GPU 快速训练算法。英伟达卖了更多 GPU,也让更多人有了训练人工智能的能力。这同样改变了英伟达,现在它 80% 的员工从事软件工作。

这次 GTC 上,英伟达更新的虚拟环境创造引擎 Omniverse 是压低门槛的另一个工具。在黄仁勋的设想中,Omniverse 是一个大型的虚拟世界数据库,里面的所有元素,不论是螺丝还是树木,只需要建造一次,然后共享给每一个需要使用的人。

在 GTC 后接受媒体采访时,黄仁勋描绘了它的未来,“说给我一片海洋。给我一条河……你想描述什么就描述什么,人工智能就会在你面前合成出 3D 世界。然后你可以修改它。”

黄仁勋希望 Omniverse 成为新技术的基础设施。特斯拉正在研发的超算 Doji 将会成为它首个基础设施服务。马斯克说,未来神经网络越来越多,让人更省钱地训练模型,是运营 Doji 最有效的方式。

过去十年,人工智能研究从学院主导变成商业公司主导。自动驾驶热、AlphaGo 赢过围棋冠军,一时间,中美的互联网、科技大公司快抢光了大学里研究人工智能的博士生——这在当时,是一家公司做人工智能的门槛。

现在没那么难。简化编程难度的开源软件包、更适合运算的处理器。写 AI 程序、调参数的不再需要博士,能用到相关技术的也不只是大公司。人工智能科学家、Google AI 负责人杰夫·迪恩(Jeffrey Dean)因此将过去十年称为这个行业的黄金时代。

就像计算机、互联网等技术经历过的那样。大大小小的研究机构、商业公司一层一层搭建基础设施,当他们垒起的基石足够高,影响更大的改变就可能发生。

本文来自微信公众号:晚点LatePost (ID:postlate),作者:贺乾明,编辑:黄俊杰