本文来自微信公众号:深途(ID:shentucar),作者:黎明,编辑:艾小佳,题图来自:视觉中国

8月10日的一起交通事故,让自动驾驶又成了争议的焦点。

一辆小鹏P7在高架路上,追尾撞上了一辆停靠在路上的故障车,站在前车车尾的人被撞飞身亡。

网传小鹏车主的聊天记录称,他当时开启了驾驶辅助系统,但车辆在撞击前没有发出任何警告,也没有做出刹车动作——车辆没有识别出前方路况。

小鹏方面回应媒体称,交警部门已经立案处理,小鹏将全力配合相关部门进行事故调查,并协助客户处理后续相关事宜。小鹏没有回应车祸时车主是否开启了辅助驾驶功能。

又一次血的教训,引发了人们对自动驾驶安全性的担忧。

在半年前,小鹏汽车刚发生过一起类似事故。一位湖南岳阳的小鹏P7车主,在开启辅助驾驶功能的状态下,撞上一辆前方横停的侧翻车辆,幸好没有造成人员伤亡。

再往前推,一年前,蔚来ES8一位车主,在沈海高速涵江段开车撞上一辆公路养护车,不幸逝世。根据当时的报道,知情人士称,他启动了辅助驾驶功能,但车辆未能识别车道内前方的桩桶和养护车。

故障车、侧翻车、养护车,是这三起事故爆发的导火线,它们都是静止物体。

对静止物体的识别,直到今天依然是自动驾驶的一大难题。这个难题在过去已经造成了多起车祸,类似的事故在未来或许还会继续出现。

自动驾驶为什么就是识别不了静止物体?对于这项新技术,还值得车主们继续信任吗?

谁酿成了这场车祸?

小鹏P7的这起事故,目前警方还没有给出定论,但结合公开的路面视频和相关资料,我们尝试大致还原事件经过。

事故中涉及到三方——小鹏P7车主、小鹏的辅助驾驶系统、故障车。事故的发生,是因为前车发生故障,停在了高架桥路段最左侧的快车道上,在车道上正常行驶的小鹏P7,没有刹车或避让,发生了追尾。

问题是,小鹏P7为什么没有发现前面的故障车?

网传小鹏P7车主的说法是,他开了辅助驾驶系统,系统没识别,正巧当时自己还分神了。

在高架桥路段,车道上突然出现一个静止物体,这是自动驾驶中最容易出事故的场景。而本次事故的场景比正常情况还要更复杂一些。

首先,前车是停在高架桥最左侧的快车道上,车道上的车辆车速非常快,后车要避让的话只能向右侧车道变道;其次也是更关键的,前车停下后,车主下车打开了后备箱,后来又关上后备箱站在车尾。

有分析认为,前车车尾站人的状态,可能导致车辆无法识别。因为小鹏P7要识别远方前车,主要靠传感器识别前车尾盖和尾灯特征。

不过在这起事故里,小鹏P7不仅没有识别出前方车辆,也没有识别出车辆后的人。

摄像头和毫米波雷达,是辅助驾驶系统中最重要的两个传感器。2020年初推出的小鹏P7,XPILOT 2.5系统搭载了5个摄像头、3个毫米波雷达,XPILOT 3.0系统升级成14个摄像头、5个毫米波雷达。

摄像头跟人眼一样,看到的是图像,毫米波雷达看到的是波段,利用多普勒现象来感知物体的相对速度和角度。小鹏P7通过安装在前风挡玻璃上的摄像头探测车道线,车辆前向毫米波雷达探测前车距离和障碍物。

按照网传小鹏P7事故车主的说法,他那辆车是XPILOT 2.5系统。一位汽车行业人士对深途分析,XPILOT 2.5的辅助驾驶配置,摄像头可以识别目标类型,但是对于行人的识别一般超过60公里/时的车速就都很难了;毫米波雷达会过滤掉静止目标,一般只有毫米波雷达和摄像头同时认为在同一点有静止目标,才会具备较高的置信度用于规控。

如果按网传聊天记录,车主当时设定的车速是80km/h,则已经超过了车辆感知系统对行人的识别范围。

软件工程师“数据里奥斯”对深途说:“小鹏P7前车的状态,对于辅助驾驶系统而言肯定是更大的干扰。而且跟车速也有关系,车速越快计算反应越慢。”

自动驾驶业内人士刘菲鸿对深途分析,“从事故视频来看,那个场景对于辅助驾驶的感知任务来说是一个corner case,也就是目前落地的感知技术难以解决的场景。”

静态物体,为何成了高速路“天坑”?

为什么高速路上的一个静止物体,会成为感知系统的corner case?识别出静止物,究竟难在哪?

数据里奥斯认为,车辆行驶时,系统并不是不能识别静止的物体,而是不能准确地将对本车行驶有影响和干扰的静止物体筛选出来。“其实都可以识别出来,但是没办法判断到底要不要避让,因为道路上的这些静止物体不好标记,标记出来又很容易被误判。”

这可以理解为:宁可不识别,也不能经常误刹车。“比起经常幽灵刹车,识别不出来更容易宽容。”他说。

这里涉及到的感知设备,就是我们在上文提到的摄像头和毫米波雷达。摄像头需要用机器学习来训练识别物体,毫米波雷达靠电磁波的反射情况来识别测距。

但这两个传感器都有自己的局限。对于摄像头而言,静态物体类别多,形态千差万别,需要大量的样本训练,而侧翻的卡车、打开后备箱的车尾、停在路边的养护车,都不是常见的样本,在训练不够的情况下就容易识别不了。

比如著名的“白色卡车”,特斯拉曾多次与白色卡车相撞,因为特斯拉的辅助驾驶系统没有识别出卡车车身,而是错将其识别为天空,最终导致误判。

毫米波雷达的局限性也很明显。车道上停放的汽车、金属标牌,以及一些非标的静止障碍物,都会因为雷达的分辨率、回波等问题导致识别失误。

汽车的感知系统扮演的是人眼的角色,人眼有一个特点,就是对运动物体很敏感,毫米波雷达跟人眼一样具备这个特点,但对静止物体比较容易“忽视”。

“这是毫米波雷达的核心技术弱点。”和高资本高级投资经理陈子颖对深途说,在她看来,毫米波雷达的角分辨率低,是行业一直想要突破的技术难点,雷达信号的分辨率会直接影响成像精度,看得清楚和看不清楚有很大的差别。

“一般来说天线越多,波束角越窄,雷达性能越强,而增加天线的方式通常是MIMO(大规模阵列)方案和多芯片级联的方案,但前者存在信号干扰的问题,后者存在级联数量有限的问题,所以角分辨率始终难以突破到1°以下。”她说。

在技术没有突破的情况下,对静态物体的识别,会一直是辅助驾驶的一大痛点。

理想汽车CEO李想曾说:“目前摄像头+毫米波雷达的组合像青蛙的眼睛,对于动态物体判断还好,对于非标准的静态物体几乎无能。视觉在这个层面的进展几乎停滞,哪怕是动态,车辆以外的识别率也低于80%。”

李想说这段话的时间是2019年,当时特斯拉Model 3直接撞上一辆正在作业的道路清扫车,车主不幸身亡。如今三年时间过去了,情况似乎也并没有太大改观。

技术上该如何解决?

高速路上的静止物体,就像是自动驾驶路上的一只拦路虎,时不时跳出来吓人。这个问题该如何解决?

刘菲鸿对深途说,问题可能不在静止上,而是在这些较为罕见的、低频出现的场景,比如高速路上有侧翻卡车,这种场景的出现的频率太低了。在目前的技术框架下,瓶颈还是在罕见场景的数据量上,而不在于传感器。

他认为,目前的感知是基于数据驱动的,比如让系统识别猫和狗,猫的图片有20个,狗的图片有2000个,那么系统对狗的识别就会好于猫的识别。所以一个场景“稀缺”,那么就是一个corner case。

不过目前的技术瓶颈在于,“虽然单个稀缺的场景数据量是少的,但稀缺的场景类别数却并不少。尴尬的地方之一就在这里。”

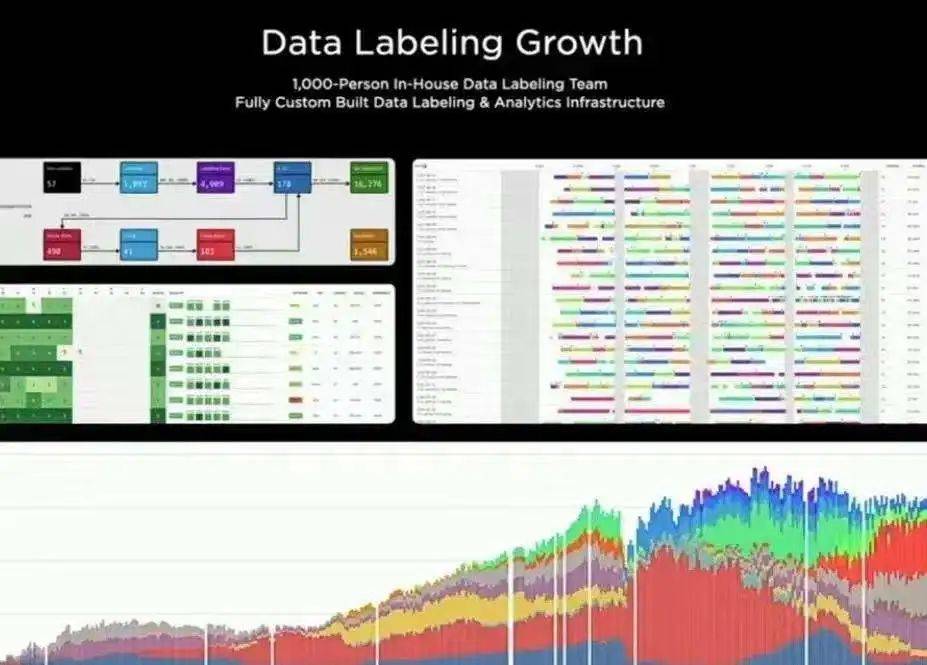

按照这个逻辑,要让自动驾驶系统持续进化,就需要源源不断“投喂”大量的数据,覆盖尽可能多的稀缺场景,让系统在学习中增强识别能力。

这其实是特斯拉当前的方案。特斯拉一直坚持神经网络和机器学习,在算法上发力,而不是像国内的造车新势力那样堆料,增加传感器数量。特斯拉Model 3和Model Y的传感器配置,在相同价位车型中,属于偏低水平,但算法弥补了传感器的不足。

马斯克认为,靠纯视觉方案,在数据足够的情况下,特斯拉也可以变得跟人一样驾驶车辆,包括识别静止物体。

“这里面的策略是关键,因此特斯拉通过每一辆车做视觉数据采集,不断优化算法模型,会覆盖大部分场景,但还是存在无可预估的风险。” 国内一家计算机视觉上市公司的内部人士对深途说。

风险的确是存在的,直到现在,特斯拉在静态物体的识别上也没有太大改进。

陈子颖认为,多传感器融合是更安全的方案,因为物理层的局限很难完全突破,一旦遇到新的corner case冒出来,就又是人命关天的大事。特斯拉现在采取这样的方案,还是更多基于传感器的成熟度和成本角度考虑。“他们永远只用最成熟的方案,未来随着技术成熟和成本降低,我相信特斯拉也不会非要坚守视觉这条路径。”

“先解决物理上的局限再谈数据的局限比较可行,就像要求盲人都能靠顺风耳来识路,这个难度岂不是更大。”她说。

国内车企更多走了另一条路——提升传感器数量和性能,比如研发4D毫米波雷达,推动激光雷达量产上车。

当年的特斯拉白色货车事故,车上用的就是传统缺乏高度信息的毫米波雷达,所以置信度低,远距离只能依赖图像传感器,最终难以摆脱物理层的局限性造成车祸。

随着4D毫米波分辨率提高,置信度上升,识别前方有高度2米的车厢后,这个信息会立刻反馈到决策系统提前做出刹车预判,整个安全性会高很多。

激光雷达则提供了另一种可能。国内的造车新势力在今年推出的新车型中,大部分都加入了激光雷达,比如蔚来ES7、理想L9、小鹏G9等。

“未来传统毫米波雷达的缺陷会慢慢被4D毫米波补上,但是论精度,4D毫米波雷达始终不及激光雷达,所以毫米波雷达和激光雷达最终还是会以互相冗余补充的方式并存。”陈子颖对深途分析。

总体而言,要绕过静态物体这个“致命杀手”,辅助驾驶还有很长的路要走。

辅助驾驶还值得信任吗?

每一次辅助驾驶事故,都给行业敲响了警钟。但造成严重后果,不完全是系统的原因,车主也难逃其咎。

在网传聊天记录中,小鹏P7事故中的车主说自己当时“分神了”,这是很致命的一个错误。

辅助驾驶不是自动驾驶,再怎么强调都不为过。这项功能现在还不能解放司机的双手,起到的只是“辅助”作用。车还得司机自己来开,遇到紧急情况要接管,出了事故司机要担责。

去年的蔚来车祸之后,新造车行业冷静了许多,过去那些浮夸、不负责任的宣传变少了,风险提示加强了。

比如新用户要开启小鹏的辅助驾驶系统,必须经过考试,在考题中就有提到,如果遇到低速或静止的清扫车、横停的事故车,系统有可能无法识别,应立即接管车辆。特斯拉、蔚来等车企也在用户手册中提醒,车辆前方的静止车辆或障碍物,系统可能无法识别和刹停。

但这些考试或提示,究竟对车主起到了多大的警示作用,很难评估。

在网上,经常会有一些车辆开着辅助驾驶高速飞驰的视频,车主拿着手机在发消息或玩游戏,还有人甚至坐在后排,完全让车自己开。这些人或许是出于炫耀,亦或是出于猎奇,但暴露的是侥幸心理。

这种侥幸心理的形成,建立在日常使用中建立的信任之上。或许车主在平时开启辅助驾驶功能时,系统都有优异表现,甚至超出车主预期,但这并不代表系统就具备了应对所有极端场景的能力。而那些罕见的corner case,往往是在不经意间出现的,而且致命。

“人工智能可以识别80%、90%,哪怕是99.999%,但达不到100%。但往往出事就是那0.00X%的不能识别造成的。这是AI的局限性。”一家自动驾驶公司内部人士对深途说。

深途接触过多位Robotaxi安全员,他们坐在号称具备L4级无人驾驶能力的Robotaxi上,让车辆在测试运营路段自动驾驶,但随时做好接管准备。多位安全员表示,这个过程比自己开车还要累,因为需要注意力高度集中。“方向盘不在你手里,你不知道什么时候就突然要接管,丝毫大意不得。”

罗马不是一天建成的,自动驾驶要真正大规模应用,无论是在技术还是法规上,都还有很多要突破的障碍。对于车主而言,这需要时间、耐心,更需要风险意识。

无论车企再怎么宣传,车主都需要时刻牢记,现在的自动驾驶都是L2向L3无限逼近的阶段,还不能完全依赖传感器去做决策。

陈子颖认为,人作为主要驾驶责任人这个前提一定要明确,“否则就是拿自己或他人的生命当自动驾驶发展中的垫脚石,代价真的太大了。”

应受访者要求,刘菲鸿为化名。

本文来自微信公众号:深途(ID:shentucar),作者:黎明,编辑:艾小佳