本文来自微信公众号:高山书院(ID:gasadaxue),作者:Stuart Russell,根据Stuart Russell于2020年9月24~25日在“GMIC 在线 Pro”的演讲内容节选整理而成,头图来自:《机器管家》剧照

假设我们将一个机器人的目标设置为“到星巴克领取咖啡”。

根据过去的AI标准模型,为了完成领取咖啡的目标,机器人必须阻止别人将它关闭(因为”一旦死了,我就无法领取咖啡”的因果逻辑),甚至电击扫除所有妨碍它领取咖啡的人事物。

在新的Provably Beneficial AI模型下,机器人从你过去的经验了解了你对咖啡的偏好;但它知道它并不确定你可能存在的其他偏好,比如你对咖啡厅里其他人的福利安危,在这样的不确定下,它会以迥然不同的行为模式运作。

在是否关闭装置的问题上,机器人的设定是:

(1)它知道当自己违反了人类意愿;

(2)人类可能把它关掉;

(3)然而它不确定人类意愿是什么,同时它也知道它不能违反人类意愿;

(4)所以,它有充分的意愿和动力让人类将它关闭。

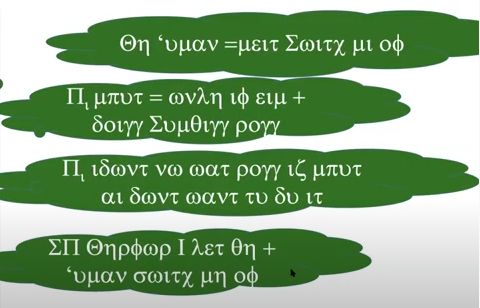

如果把这4项转化成数学的标准范式(如下图的希腊文),可以严谨论证出得出:这种设计模型的机器人是可证地有益(provably beneficial)的。

AI何去何从?

对人类而言,这无疑是佳音。在这个基础上,其实有非常多相关研究已经完成或正在进行,但也还有一些有待我们继续努力,把这个新模型付诸实现。

其中一个需要跟进的方向,是怎么让人工智能从代表一个人,延伸到代表很多人,甚至一个社会、多个社会。实际上,这也是一个穿越千年的哲学命题,从公元前五世纪中国的墨子,到古希腊柏拉图、亚里士多德,再到边沁与密尔的功利主义理论,以及现代经济学等等。

另一个需要解决的问题,在于人类的不完全理性。像前面所说,人类的表象行为,不总是体现我们的深层偏好。

比如李世石在和阿尔法狗的对弈中,就频频下出非最佳下法。如果系统假设他是理性的,那么系统就必须推断他想输;但事实上这是因为他的计算力并不完善。

总的来说,不管是谁,人类在各方各面都存在认知上的限制。所以,新模型若想透过表象行为去了解人类的深层偏好,就需要转向认知心理学、神经科学等学科,建立一套人类认知模型。

另外一个有待完成的工作,是这套模型的技术基础。从标准模型转向新模型,我们需要重建或重修每一个AI层面和分支,各种定理、定义、算法、语言处理、强化学习、搜索、策划。

最后一个值得深耕的领域,是现实应用。这也是最能体现新模型价值的地方,从而带来后续更多的资金与精力投入研究。比如自动驾驶汽车,这项应用就特别要求AI能同时了解乘客的偏好以及其他公路使用者的行为,从而判断自己做出什么反应。其他正酝酿中的应用,还有个人助理、数码机器人等等。

未解的难题

关于人工智能与人类的前景,很多人可能也想到了其他的问题,如:

误用

比如《邪恶博士》里,歹徒抱着支配世界、操控世界的动机去开发人工智能。在如今已经棘手的网络犯罪之上,这是另一个更棘手的难题。因为它涉及到人工智能的失控,以及人类的未来。

滥用

比如《机器人总动员》里,AI代替了人类打理社会的运作,人类失去了动力去理解和发展自己的文明,成了一艘永远前进的游轮上的乘客。在机器持续为我们分越来越多忧、解越来越多难的背景下,人类怎样能保持自己文化与智力上的活力?

这两个问题暂时算是无解,也期待大家集思广益。

本文来自微信公众号:高山书院(ID:gasadaxue),作者:Stuart Russell (加州大学伯克利分校计算机科学教授,人工智能领域的重量级学者,他与Peter Norvig 合著的《人工智能:一种现代方法》被全球超千所大学选择为标准教科书,对高速发展的人工智能技术面临的机遇和挑战有着自己独到的见解。)