本文来自微信公众号:Hi放晴公园(ID:hisunshinepark),作者:方可成,题图来自:视觉中国

过去三周里,大家从《放晴早安》中听到了很多传递善意的故事。这些故事让我们觉得世间依然有很多美好的事情,有很多善良的人。但是,有的人可能会说,也许这些故事只是例外,人性也许本质上并不是善良的。

那么,人性究竟是善还是恶呢?这的确是我们需要回答的一个核心问题。

今天,我想尝试给出一个答案,那就是:其实人性里面,既有善的部分,也有恶的部分。我们既不能说人在本质上是善的,也不能说人本质上是恶的。关键是,我们的社会应该设计怎样的机制,让善的部分更多被激发出来,让恶的部分受到更多的抑制。

在这里,我想用社交媒体作为一个案例,来说明:好的机制设计,对于塑造一个更善意、更美好的环境,有多么重要。

相信很多人都有这样的感受,就是,如今社交媒体上的环境越来越“有毒”了。在英文世界里,很多人真的是用“有毒”,也就是toxic这个词来形容如今的社交媒体的。

这里的“有毒”指的就是,社交媒体上充斥着粗鲁的、不尊重人的、不讲道理的内容,到处都是所谓的喷子、杠精,看到这些内容之后,我们就会想要逃离讨论,因为实在无法忍受这样的毒性。

也有人说,在社交媒体上,好像人人都很愤怒。在任何事情下面,人们好像都能吵起来,随之而来的,可能就是各种人身攻击和网络暴力。这届网友好像脾气特别大。慢慢地,很多人也就不愿意在社交媒体上说话了,因为搞不好就会被人喷。

那么,我们是不是可以说:社交媒体反映了人终究是一种“有毒”的生物?

我觉得,并不能这么说。因为,社交媒体上的环境之所以有毒,其实更重要的原因是,社交媒体的产品设计本身就在鼓励有毒的内容。可以说,社交媒体上的恶,很大程度上是被它们的产品设计激发出来的。

我在这里给你三个具体的原因。

首先,在社交媒体上,我们其实很难感受到他人的存在。当然,我们能看到一个个ID和头像,但它们只是一个个像素,并不能让我们感觉到他们是真实的、有血有肉的人。而这就让我们发表不尊重的、攻击性的言论的时候,心理压力少了很多。你有没有发现,在社交媒体上骂人的时候,我们很难感受到他人的痛苦?有很多我们当面根本说不出来的难听的话,在网上发表的时候,可能很容易就打出来了,这时候,如果我们用的还是别人认不出来的网名,那我们就更大胆了。

第二,社交媒体的核心机制是转发,一条内容被转发越多,也就传播越广。就算你只有100个粉丝,但如果你的一条内容获得了很多人的转发,那它也可以成为所谓的爆款。也就是说,在社交媒体上,让人有转发的欲望就是王道。你的粉丝再多,写的内容质量再高,如果不能让人想点转发按钮,那就不会有很大的影响力。那么,这种产品设计鼓励的是什么内容呢?

答案是:情绪化的内容,尤其是那些激发人愤怒情绪的,挥舞道德大棒去打击别人的内容。纽约大学的研究者William Brady就发现,在推特上,如果一条推文里面用了情绪化的、道德评价的语言,那么每一个情绪化的、道德评价的词都会让这条推文获得的转发数增长20%。这当然和我们人类的天性有关,因为我们就是很容易被愤怒的内容激发转发的欲望;但同时,这也和产品设计有关:因为如果这些社交媒体产品不将“转发”作为信息传播的核心机制,那么情绪化的、愤怒的内容也不会那么容易传播了。

我们可以打个比方:就比如,你在路上走着,忽然听到有人在吵架,而且要打起来了,你很可能会去围观一下,看发生了什么。你过去一看,发现其中一个人你认识,这下你可能马上会选边站,甚至也加入一起去吵。而社交媒体每天在做的,就是天天让我们看到有人在吵架,天天引诱我们去加入。

第三个原因是,社交媒体的算法也在鼓励有毒内容的传播。现在,几乎所有社交媒体的商业模式都是,依靠流量带来广告收入,所以它们的算法都会特别青睐那些能带来流量的内容。可能你已经发现,微博上的内容排序早就不是按照时间顺序来了,而是由算法来决定,什么排在前面,什么排在后面。那么这种排序算法里面一个很重要的规则就是,如果一条内容被转发得特别多,它就会被放在很显着的位置,让更多人看到。我们刚才说到了,情绪化的、愤怒的内容本来就被转发得更多,现在有了算法的加持之后,就会有更多人看到。而那些不能刺激人情绪反应的内容,算法也就不会喜欢,看到的人就更少了。

所以说,社交媒体的产品设计本身,就在刺激我们发表更多愤怒的、有毒的内容,然后又在帮助这种内容的传播。夸张点说,它就是一台制造和传播愤怒的机器。

听到这里,可能你也会觉得,这真的是很令人遗憾的事情。不过,了解了这些之后,我们有没有可能尝试去改变它呢?答案是:有。现在已经有不少学界和科技界的人士在做一些实验了,接下来,我就给你介绍其中的一部分做法。

首先,我们能不能让人更加感觉到,社交媒体上的用户也是活生生的人呢?

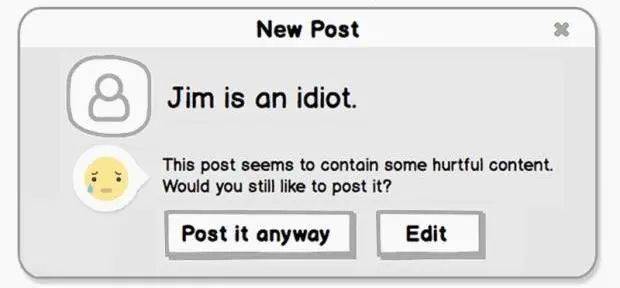

有人就做了个实验,每当有用户发表人身攻击的言论时,就让社交媒体跳出提示:“你这条内容可能含有伤害到他人的内容,你真的要发布吗?”看到这条提示之后,很多人就选择了不再发布。

还有一位学者在推特上创建了几个机器人账号。它们会自动搜索带有“黑鬼(nigger)”这个词的推文,并且通过一些标准来判断:这条推文是不是由白人发布的、是不是辱骂黑人的。如果是的话,机器人就会发布一条回复,说:“嘿,请记住:当你用这种语言骚扰别人的时候,你伤害了真实存在的人。”他发现,这种提示还真的有些作用,一些人被提醒之后,就不再发表这种种族歧视的仇恨性内容了。

前段时间,有一款叫做Clubhouse的音频社交软件很火,有人发现,在这个软件上面,不同意见、不同背景的人居然可以有心平气和的交流。其实,很大一个原因就是:通过声音,我们能更真切地感受到对方是有血有肉的人,我们也知道自己的声音会被别人听见,所以这就让我们变得更加尊重彼此。

另外,也有人提出,我们能不能在社交媒体上增加一些按钮呢?比如增加一个“我犯了个错误”的按钮,让人在意识到自己说错了话之后,可以马上把这条内容打上标记,并且限制它的传播。这可能也会让人更乐于、也更方便地承认,自己刚才的言论是不妥的,就不必死扛下去啦。

还有一种思路是,能不能让每个用户都对呈现在眼前的内容有更多的控制权。比如,麻省理工学院的媒体实验室就有一个叫做Gobo的项目在做这方面的尝试。在他们开发的系统里面,用户可以自己选择,是否要过滤掉不礼貌的、不尊重人的内容,是否要看和自己不同观点的内容,是否要看严肃性质的、不情绪化的内容。

这就给了用户更多的选择,不必被平台的算法左右。当平台的算法在使劲推那些情绪化的、激发愤怒的内容时,我还是有办法只看那些认真的、严肃的、不能刺激人转发的内容。

这些尝试大多还停留在实验室里,但也有一些逐渐被社交媒体平台采用了,比如推特今年就计划推出“安全模式”,这个模式可以自动屏蔽不友好的评论内容,自动拉黑不友好的账号,让用户有更多的选择和控制权。

好了,以上就是我今天想和你分享的内容。它算是好消息吗?我觉得是,因为它让我们知道:我们在社交媒体上看到的并不尽如人意的气氛,它背后是有具体原因的;既然有具体原因,我们就能设计办法去改变它。

虽然把设想变成现实的道路还很长,但它是一条可行的道路。同时,我们也应该向社交媒体平台施加更大的压力,让他们更自觉地改善自己的产品,不要把利润建立在制造愤怒与仇恨上面。

本文来自微信公众号:Hi放晴公园(ID:hisunshinepark),作者:方可成