本文来自微信公众号:APPSO (ID:appsolution),作者:黄智健,原文标题:《苹果秘密项目曝光!明年 iPhone 可能要迎来“ChatGPT”时刻》,题图来自:视觉中国

苹果、微软、Alphabet(Google)、Meta 和亚马逊是公认的科技圈“Big Five”五巨头。

在 OpenAI 和微软带起的 AI 风潮,Google、Meta、亚马逊都纷纷拿出了压箱底的 AI 技术,唯独苹果一直没有动作,置身于事外。

不过,据彭博社记者 Mark Gurman 爆料,苹果的冷静只是表象,在苹果的内部早已组建起了一支 AI 研究队伍,准备要投入这场漩涡之中。

“Apple GPT”首次曝光

有知情人士向彭博社透露,苹果内部已经创建起了一个类似 ChatGPT、Bard 的聊天机器人服务,一些内部工程师称之为“Apple GPT”。

据悉,“Apple GPT”是基于苹果自主构建的 Ajax 架构开发而来。

Ajax 是苹果去年为了统一机器学习而创建的系统框架(底层是 Google Jax),目前苹果的搜索、Siri、地图等服务已经基于 Ajax 做出了一些与人工智能相关的改进。

苹果的下一步,就是用 Ajax 开发大语言模型。

今年 5 月,库克曾在电话会议中提到了他对生成式 AI 的看法,库克表示他不会对苹果的产品路线图发表评论,但他承认生成式 AI 的潜力巨大。

库克认为 AI 目前还有不少问题有待解决,苹果会继续投资相关的技术,并尽量考虑周全。

表面看起来苹果似乎不急不慢,但据彭博社报道,去年年底苹果内部就已经有一个小型团队在开发聊天机器人服务,随着时间推移,该团队拓展得越来越大。

内部人员透露称,“Apple GPT”在苹果内部一度因为 AI 安全隐患问题被叫停,但后来还是允许项目继续开展下去。

想要使用“Apple GPT”,员工需要先经过特殊的审批流程,在使用时苹果还给出了一条严肃的警告:该程序不能用于开发任何面向用户的功能。

据了解,“Apple GPT”可以根据训练过的总结文本回答问题,苹果的工程师会用它来协助开发产品原型。

“Apple GPT”在功能上和 ChatGPT、Bard 没有太大的区别,类似于网页应用,苹果并没有为其开发一些独特的功能和技术。

我们什么时候才能见到“Apple GPT”呢?很遗憾,苹果目前还没有向消费者公布该产品的计划。

不过有内部人士透露称,苹果可能在 2024 年发布一个与 AI 相关的重要说明。

除了自研模型,苹果还计划与 OpenAI 合作,签一份大合同,但目前并不清楚具体合作内容。不得不说,先后赢得微软和苹果垂青的 OpenAI 才是这场 AI 浪潮最大的赢家。

这么看来,2024 年对于苹果是个非常重要的年份,苹果既要发布 Vision Pro,又要参与 AI 大战,属实是踩在了科技最前沿的两道浪花上。

苹果眼中的 AI

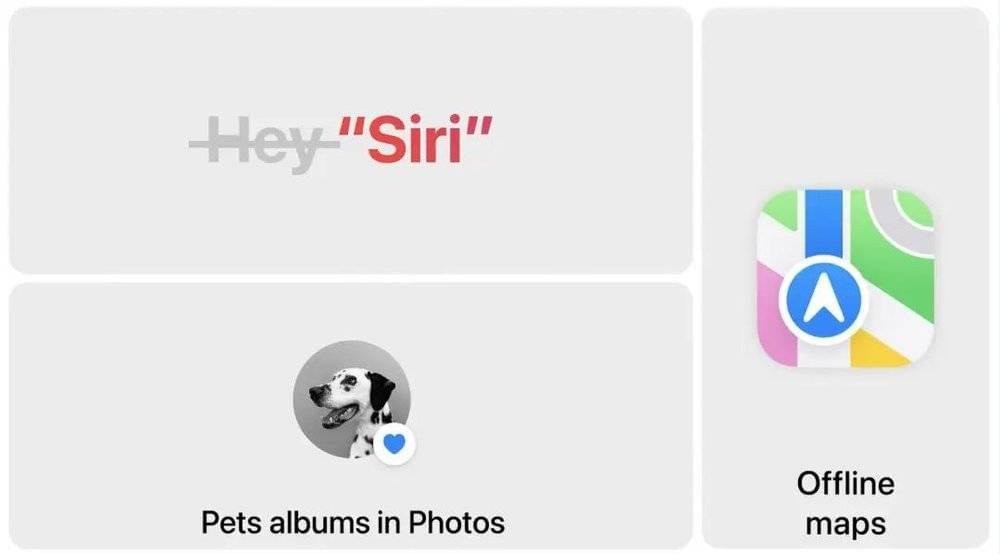

苹果几乎不会提及 AI 这个概念,但 AI 早已融入苹果生态每个角落,这一点在 WWDC 2023 后的苹果产品各个新版系统中尤其明显。

许多人使用的苹果输入法在 iOS 17 里得到了 AI 加持,有了自动纠正功能,它可以预测用户想要打出的文字,还会不断学习用户的输入习惯,帮助用户高效输入。

苹果软件工程高级副总裁 Craig Federighi 表示:“(甚至)当你想输入一个 Ducking word(避讳词)的时候,键盘也会自己学习(你的输入习惯并预测你想输入的内容)。”

输入体验的提升得益于苹果对设备端 Transformer 模型的优化,而很多人不知道的是, Transformer 是支持 ChatGPT 的重要技术之一。

新款 AirPods Pro 通过机器学习实现的自适应音频模式,可以识别到外部特定声音时会自动在降噪模式和通透模式间切换,极大降低了用户手动切换的频率。

还有 iPad OS 17 利用机器学习模型识别 PDF 中的字段,用户可以快速用通讯录中的姓名、地址和电子邮件来填写相关信息。

不少人期待的日记 app Journal 可以利用机器学习技术,根据用户近期活动智能记录生活瞬间,包括照片、人物、地点、体能训练等等。它还可以自动给照片、音乐、录音等条目添加详细信息,方便日后回溯。

万众瞩目的 Vision Pro 为用户打造数字化身这项功能也用到了机器学习技术 —— 先进的“编码器-解码器”神经网络。

watchOS 10 的智能叠放,到底当下应该选择哪个更重要的信息进行展示,也是 AI 来决定的。

就连 iOS 17 和 iPadOS 17 的动画都用到了 AI 技术,机器学习模型能够合成额外的动画帧,让设备展示出华丽流畅的慢动作效果,这也是不少尝鲜 beta 版系统的人觉得动画变得更流畅优雅的原因。

还有 Hey Siri 变成 Siri,也是 AI 的功劳

在上周发布的 iOS 17 Public Beta 还带来了一个“声音克隆”功能。

在设置 - 辅助功能里面,你可以看到新增了一项“个人声音”的设置,你可以像给 Siri 录入声音那样,跟着屏幕提示录入 150 句短语。

然后 iPhone 就会学习你的声音,生成一个与你的音色相近的 AI 声音。可惜的是,目前该功能只支持英语,期待苹果可以新增更多的语言。

可以这么说,大众以为的 AI “差生”苹果可能是一个AI“狂魔”。

苹果押注的 AI 未来

一直以来,苹果对机器学习的宣传重点都是“基于本地运行”和“保护隐私”。

如今苹果押注了 AI 大语言模型后,苹果会像微软和 Google 那样激进地部署 AI 功能吗?

关于这一点,苹果内部也还没达成一致的共识。

在苹果内部,与机器学习相关的项目由苹果机器学习和人工智能部门负责人 John Giannandrea 和苹果软件工程高管 Craig Federighi 共同领导,John Giannandrea 表示希望先观望一下 AI 的演变,用更为保守的方式去发展,但团队并没有完全统一战线。

John Giannandrea 曾在 Google 领导过人工智能和搜索团队,于 2018 年加入苹果,负责传闻中的 Apple Watch AI 健康助理和更加神秘的自动驾驶项目。

如果苹果要把大语言模型整合入苹果的服务的话,那么长期以来饱受批评的 Siri 应该是最合适的落脚点。

和能说会道的 ChatGPT 相比,只会回答简单问题的 Siri 就像是隔了两个世代的产物。ChatGPT 一经发布,就有网友研究出用快捷指令等方式,让 Siri 调用 ChatGPT 来回答,提升它的智能水平。

目前,ChatGPT iOS 端 app 在美区 App Store 效率榜依然排名第一,足以说明用户们对移动端大语言模型聊天机器人的热爱。

另一方面,Bard 最近更新了朗读内容的功能,现在 Bard 既支持语音输入,又支持语音朗读回答内容,几乎相当于超智能版 Google Assistant,距离在 Android 手机上部署只剩一步之遥。

如果 Google 完善了大语言模型的 AI 安全限制措施,把 Bard 率先应用在 Google Assistant 上,让智能手机变成智能助手,这将会对 Siri 形成降维打击。

从这个角度来看,苹果部署大语言模型不仅十分必要,而且刻不容缓。

以当前生成式 AI 发展速度继续下去,或许我们很快就能看到一些在手机上部署大语言模型的应用。一向秉持“软硬件协同工作”理念的苹果,不会只甘心当一个硬件供应商。

苹果此刻的冷静、保守,也许只是在为一年后的爆发蓄力。

本文来自微信公众号:APPSO (ID:appsolution),作者:黄智健