本文来自微信公众号:Nature Portfolio (ID:nature-portfolio),作者:Davide Castelvecchi,题图来自:视觉中国

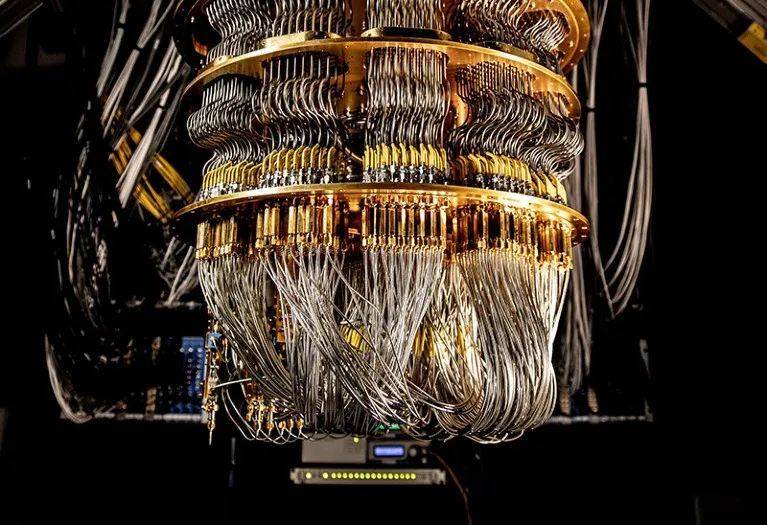

谷歌(Google)表示,其物理学家在通往实用量子计算机的道路上实现了第二个里程碑。这个来自加州圣巴巴拉实验室的谷歌团队证明,增加量子代码能降低计算错误率。

这项成就2月22日发表在《自然》[1],延续了谷歌2019年在“量子优越性”(quantum advantage)上的成功。在2019年的著名实验中,谷歌让量子计算机完成了传统计算机需要好几千年才能完成的计算任务。

要让量子计算机解决经典计算机力所不及的问题——比如将很大的整数分解成素数,或是揭示化学催化剂的具体行为——纠错便是其中绕不开的一环。

荷兰代尔夫特理工大学研究量子纠错的理论物理学家Barbara Terhal说:“谷歌这次的突破很了不起,因为一般情况下,代码容量越大,计算机的表现也会越差。”谷歌的研究团队承认,这次的进步还很小,错误率还要进一步降低。谷歌山景城总部的量子计算部主管Hartmut Neven说:“错误率下来了一点点,但离我们的目标还很远。”

纠错

所有计算机都会出错。普通的计算机芯片以位(bit,以0或1表示)为单位储存信息,并会将一些信息拷贝成冗余的“纠错”位。如果出现错误——比如因为杂散电子穿过了不完全绝缘层,或是某个宇宙射线粒子干扰了电路——芯片都能自动发现并修正问题。

“但这对量子信息是行不通的。”谷歌量子硬件主管Julian Kelly在新闻发布会上解释道。量子计算机基于名为量子比特(qubit,也称量子位)的量子态,而量子态能以0和1的叠加态存在。如果你读取了一个量子比特的信息,其全量子态就会不可挽回地丢失,也就是说,其信息无法简单地拷贝到冗余的量子比特中。

但理论学家设计出了非常精密的“量子纠错”机制来解决这个问题。这些机制通常需要用一堆物理量子比特而不是单个量子比特编码一个量子比特信息——称为一个逻辑量子比特。然后,计算机就能利用其中一些物理量子比特检查这个逻辑量子比特的健康状况,并纠正错误。物理量子比特越多,他们抑制出错的能力就越强。Terhal说:“利用多个量子比特进行量子纠错的优势在于其具有拓展性。”

不过,更多的物理量子比特也会增加其中两个同时受到错误影响的概率。为解决这一问题,谷歌团队运行了两版量子纠错程序。一版利用17个量子比特,可以每次从一个错误中恢复。另一个更大的版本利用49个量子比特,可以从两个同时发生的错误中恢复,比小版本的表现稍微好一些。Terhal说:“现在的纠错率提升还太小,不能保证使用更大的代码就能得到更好的结果。”

新加坡Horizon Quantum的物理学家Joe Fitzsimons表示,很多实验室已经在实际纠错上取得了重大进展,而且谷歌的最新成果也表现出很多他们需要的特点。但是,量子比特储存信息的时间也要足够长,这样才能让计算机执行计算任务,而谷歌团队还没有取得这方面的成功。Fitzsimons说:如果想要很好地演示可扩展纠错,随着这个系统的扩展,我们希望能看到生命周期的提升。

谷歌为它自己规划的量子计算路线图一共分六步。量子优越性是第一步,最新成果是第二步。第六步是一台由100万个物理量子比特组成的计算机,能编码1000个逻辑量子比特。Neven说:“到了那时,我们能很有信心地保证计算机的商用价值。”

构建量子计算机的方法有很多,超导量子比特只是其中一种,但谷歌坚信它成功的可能性最大,Neven说,“如果事实证明另一种方法能更快实现实用量子计算机,我们肯定会立即掉头。”

参考文献:1. Google Quantum AI Nature614, 676–680 (2023).

原文以Google’s quantum computer hits key milestone by reducing errors标题发表在2023年2月23日《自然》的新闻版块上,© nature,doi: 10.1038/d41586-023-00536-w

本文来自微信公众号:Nature Portfolio (ID:nature-portfolio),作者:Davide Castelvecchi