本文来自微信公众号:经济观察报观察家 (ID:eeoobserver),作者:韩明睿,原文标题:《为亿万后人:直面生存性风险与灾难》,头图来自:《不要抬头》

2021年末,网飞推出的《不要抬头》绝对是圣诞档期的最热电影,讲述了一个彗星撞地球的故事。当然这只是一部喜剧片而已,不过如果有观众看完之后真的担忧起地球会有如此不祥的天外来客造访,从更科学的角度来说,有一个好消息和一个坏消息。

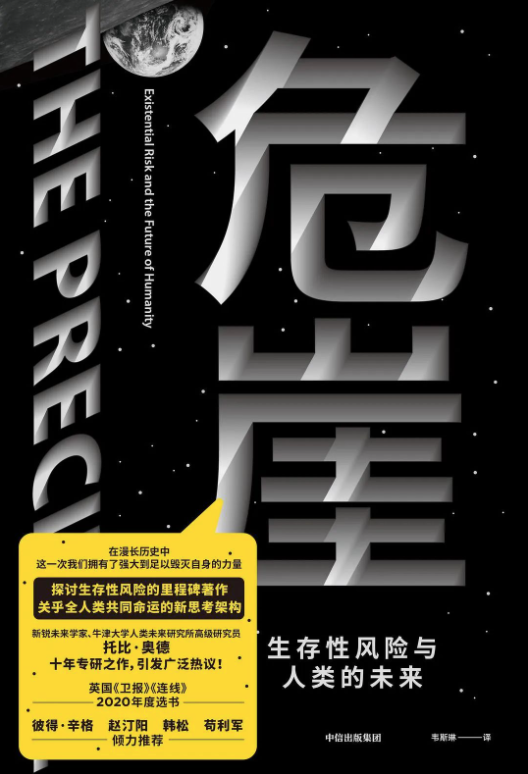

好消息是,地球被彗星或小行星撞击导致人类灭绝的可能性小到可以忽略不计。坏消息是,其他各种危机引发文明灭顶之灾的概率加起来比一般人想象得要高得多。根据牛津大学人类未来研究所(Future of Humanity Institute)学者托比·奥德(Toby Ord)于2020年出版,2021年被翻译引进中国的《危崖:生存性风险与人类的未来》一书估算,人类在接下来一个世纪中遭遇生存性灾难的概率约有1/6。也就是说,与骰子掷出某个特定数字差不多。

(澳)托比·奥德/著 韦斯琳/译

中信出版社·新思文化 2021年10月

这个概率有点吓人,所以首先需要澄清一下定义。生存性灾难(existential catastrophe)包括但并不限于人类灭绝。书中将其定义为“摧毁人类长期发展潜力的事件”。如果一场全球性灾难抹去了大部分但不是全部人口,同时让人类丧失了可资利用以重建文明的技术、文化、制度和自然资源,则也属于生存性灾难的范畴。事实上,由于人类走出非洲之后至今已经遍布地球上包括南极洲在内的各个角落,一两场灾难就让人类全体覆灭而不留下任何活口,几乎不可能。但一些自然或人为的重大恶性事件完全可能剧烈地改变地球环境,使得灾后存活下来的人们像一些反乌托邦文艺作品里描绘的那样,只能一直以低水平的生活质量和落后停滞的技术能力苟且偷生。“发展”,这个自工业革命以来为世人所熟悉乃至觉得理所当然的概念,会永久地成为过去式。

生存性风险威胁的不只是我们当代人,也不只是可以被称作我们子孙的下几代人,而是人类作为宇宙中目前所知唯一的智慧生命的长远未来。如果只考虑物理学定律在宇宙时间、运输速度、可用能源等方面对人的限制,人类的未来不只是数百年甚至数万年,而是以亿年计——自然,前提是人类及其发展潜力不会毁于自然或自己之手。以如此宏大的时间尺度来衡量,人类尚处于幼年。而就像每个人在懵懂的童年时光里都会跌跌撞撞地犯下很多用成年人的眼光来看笨拙可笑的错误一样,身处这个时代的我们的所作所为,或对一些风险的忽视,可能在更为成熟理性的后人看来会是极度危险、不负责任的。

我们现在经过深思熟虑的主流道德观点与区区两个世纪前已大为不同,不再认为种族和性别歧视、奴隶制、宗教不宽容可以被接受,甚至难以理解祖先们为何会对此毫不羞惭。依此推断,多年后的人们也完全可能认为我们在某些道德和现实问题上愚昧而狂妄,将彼此以及子孙后代置于不可原谅的危险之中。卡尔·萨根有句话讲得很好:“我们面临的很多危险实际上源于科学与技术——但更根本的问题是,我们变得更强大,却没有相应地变得更有智慧。”

也许有人会反驳说,我们并没有把生存性风险完全置于脑后:看看最近几十年的科幻影视剧,几乎全在高举“反思科技”的大旗,悲观地展现一派反乌托邦或末世图景。本书作者奥德也注意到了这一点,但他并不认为这是什么好事。

科幻影视剧中设置全球性灾难的背景或桥段,主要是为戏剧性提供服务。大家可能都向往生活在既有昌达的科技又能避免各种危机的未来社会,但也都不会想花几个小时在虚构作品中从头到尾看到的都是天下太平的景象。灾难或废土题材的文艺作品滥用生存性风险概念,非但没有唤起严肃的讨论,反而让人们变得麻木起来。《不要抬头》也无非是又一部娱乐电影。如果它在娱乐之外还贡献了什么,基本上可能也就是好莱坞自由派对特朗普及其拥趸又一次党同伐异的讽刺。

一、三类风险

现在让我们来看看,人类究竟会面临哪些生存性风险,各种风险又有多大可能性爆发。本书基于截至成稿前人类未来研究所的团队多年的研究积累,将生存性风险划分为自然风险、现有人为风险和未来风险三大类。其中前两者已对我们构成威胁,而未来风险尚未威胁到人类整体命运,但未来全面爆发的可能性不容忽略。

需要注意的是,由于这些根据定义不可能有先例的灾难特性极为复杂,因此也有高度不确定性,书中给出的概率并不是精确的估算结果,而是代表了根据现有信息对风险数量级的最佳估计,大几倍或小几倍都在可以容忍的误差内。

自然风险包括开篇提到的小行星和彗星撞击,以及超级火山喷发、恒星爆炸等。直径超过10公里的小行星可能导致大规模生物灭绝。6600万年前撞击地球的小行星,直径就是10公里。被它害死的不只是恐龙,涵盖了所有体重在5公斤以上的陆地脊椎动物。如前所述,这等规模的小行星未来一个世纪内撞上地球的概率极低,约为1.5亿分之一。在直径在1至10公里之间的小行星破坏力较小,但也可能引发生存性灾难,而且其数量比前者多出两个数量级,好在撞击概率也不是很高,约为12万分之一。至于彗星,其数量比小行星少得多,根据当前的认识,潜在风险可能与小行星相差不大。得益于充足的关注以及随之而来的研究经费,来自小行星、彗星的风险可以说是各种生存性风险中被研究得最透彻的。并且由于发生概率很小,奥德直言:“如果人类会在未来的100年内灭绝,那么几乎可以肯定原因不是小行星或彗星撞击。”

超新星爆发和伽马射线暴这两种恒星爆炸事件则可能会严重破坏大气层,但概率至多是小行星和彗星撞击的1/20。所以,与其担忧这些飞来横祸,还不如了解一下地下涌动的暗流。超大规模火山喷发释放出的火山灰等颗粒,会长时间漂浮在大气中,阻碍阳光照射,导致全球变冷,农作物大面积歉收,引发全面饥荒。据估计,超级火山喷发构成的生存性风险达到了小行星和彗星撞击风险的10倍,是威胁最大的自然风险。但自然风险再大,也完全无法与人为风险相提并论。根据书中的估测,自然风险的总概率约是万分之一,而主要的几项人为风险是这个数字的上千倍。

现有的人为风险主要有核武器、气候变化和环境破坏。毋庸多言,从广岛爆炸到古巴危机,核武器让人类首次意识到全世界可能毁于自己之手。本书认为,我们所处的是前所未有,可能也后无来者的高风险时代,就像走在峭壁腰上的一条羊肠小道,这就是书名《危崖》的涵义。

危崖时期的起点被定在了史上第一次核试验的日子,即1945年7月16日。理论上,相互确保摧毁战略和冷战双方都具备的二次核打击能力,能够避免任何一方发动核战争。然而冷战期间美苏预警系统多次发生故障或出现人为失误,发出了对方已启动先发核打击的误报。依靠发射程序设计,或许还凭借了一点运气,每一次误报接收方都没有按原定程序动用己方核力量“报复”对方,让人类躲过了最恐怖的结局。误报甚至在冷战结束后也时有发生。1995年俄国收到的一次雷达误报被层层上报到了克里姆林宫,叶利钦甚至打开了核密码箱,考虑是否授权动用核武器。当然核战争并未爆发,所以就如我们都能猜到的那样,警报后来得以解除,叶利钦最后还是关闭了密码箱。误报来自于挪威发射的一枚科研火箭。挪方按照安全协议事先通知了俄方。俄方本应依此排除本次警报,但通知并未传达至雷达操作员。

更鲜为人知但又细思恐极的一点是,根据美国研发原子弹时一些科学家提出的模型,核聚变有可能在大气层中引发热核反应,点燃空气中成分占比最大的氮气,短时间内就让全球陷入火海。更多的科学家认为这一模型有严重问题,于是就如众所周知的那样,研发进程继续了下去。但由于模型复杂,计算繁难,直到首次实弹试验前,科学家群体都未能完全排除这一可能性。参与曼哈顿计划的诺贝尔物理学奖得主费米直到试验当天还在和同事一起反复验算。万幸的是,研究团队的多数意见被试验证实是正确的。

核战争一旦爆发,最可怕的甚至还不是数以百万人可能死于核弹及持续的辐射。更具灾难性的后果直到20世纪80年代初才为科学界所知:与超级火山爆发对大气的影响类似,核爆产生的黑色烟尘会飘进平流层,无法被雨水带回地面,导致俗称“核冬天”的气候剧变。有科学家估计,全面核战争会让地表温度平均下降7℃,北美和亚洲大部分地区的夏季气温会比现在降低20℃。农作物的生长期需要恰当的气温,这等程度的全球变冷会让绝大多数作物根本无法成熟,令几十亿人陷入饥荒。

气候变化是近十年来最受瞩目的所谓“危机”。其实,就主流气候科学界的均值预测而言,本世纪末的全球平均气温较工业革命之前增加两三摄氏度,并不关涉全人类的生死存亡。就算未来几个世纪里海平面上升数百米,陆地的绝大部分也不会被淹没,迁移、兴修城市等适应措施完全可以应对。农作物也是怕冷不怕热,农业不会受到太大影响。形成生存性风险的是,一些正反馈机制使得以摄氏度衡量的气温上升两位数,让人在没有空调的环境中难以生存下去,不过这些是小概率事件。

总的来说,书中给核战争、气候变化和环境破坏在一个世纪内各赋予了千分之一的生存性风险概率。它们已经比自然风险高出了几个数量级,但又比不上接下来讨论的未来风险比起来。

首当其冲的未来风险是大流行病。书中并未提到新冠肺炎疫情,因为本书2020年3月就已出版,成稿时新冠肺炎疫情尚不为人所知。这也可以体现作者和团队同事们的预见力。可能有人会觉得大流行病应该归入自然风险。但有充分理由认为,哪怕自然产生的流行病,若能形成大流行,也必然有人为因素。现在全世界的人口远多于古代,更容易孕育出新的病原体。人类通过农业改变了自然,由此也大大增多了与动物的接触,使疾病更容易从动物传播到人类身上。人们在城市中扎堆,又乘坐各种交通工具远行,使得疾病人传人的速度更快,范围更广。

生物技术的发展让纯粹人为制造的流行病也愈发可能出现。英美法苏等大国都曾有过生物武器计划。其中苏联规模最大,一度有十几个秘密实验室和九千名科学家投入其中,开展将鼠疫、天花、炭疽和脊髓灰质炎转化为武器的研究,增强它们的传播能力、致死率和对疫苗、医药的抵抗力,并建立了大量储备。

1972年多国签署《禁止生物武器公约》,1975年生效。但苏联签署后仍将其生物武器项目维持了近二十年。南非、伊拉克也曾违反《公约》发展生物武器。《公约》的问题在于执行能力,联合国直到2007年才成立《公约》执行协助机构,其年度预算仅相当于平均一家麦当劳连锁餐厅开支的一半,工作人员仅四人,人力物力都远远不如《不扩散核武器条约》或《禁止化学武器公约》的执行机构。

《公约》对非国家主体更无从防范。近年来基因技术像信息技术一样迅速大众化。几十年前只有极少数生物学家才能做到的事情,现在研究生已可掌握。在不远的将来,数以百万计的生物学本科水平者都有能力成为基因玩家。指望其中每一个人都有负责的学术伦理和严谨的操作规范,无疑是异想天开。20世纪八九十年代日本奥姆真理教吸纳的几千个信徒中就有人学习过生化技术。他们不但成功地使用沙林毒气造成多人伤亡,甚至已开始研究炭疽武器。2020年拿到诺贝尔奖的CRISPR基因编辑技术日益普及。未来的反社会分子尝试借此制造出危险的新病毒,可能只是时间问题。现在DNA合成仍需依靠生物技术公司完成,很多公司自发建立了筛查机制以排除含有危险序列的订单,但据估计每五份订单就有一份未被此类机制覆盖。

更惊悚的是,理论上被严格管理的实验室也可能成为大流行病的源头。2001年英国为了扑灭口蹄疫,宰杀了六百万头牲畜。然而六年后疫情卷土重来,调查发现此次病毒源于一个最高安全级别(BSL-4)的实验室不慎泄漏。苏联在违反《公约》继续研发生物武器期间,一个实验室于1979年泄漏了大量炭疽杆菌,确认造成66人死亡。

“自然”产生并传播的大流行病在未来一百年造成生存性灾难的概率被估计为万分之一,而利用基因工程人为制造的大流行病对应的概率是1/30。后面这个数字已经让人有些不得安宁。但这还不是本书册封的风险之王。书中认为与人类价值观不一致的通用人工智能构成的生存性风险概率高达十分之一,也就是说占到了总体风险的六成。

此前所述的风险,要么来自于没有能动性,大体上已被人类所征服,或人类至少已有深入了解的自然现象,要么会是由人类自己亲手制造。而通用AI造成的问题与前两者完全不在一个层次上。它会具备能动性,有自己的追求,而且智力可以远超人类。这样的AI现在还不存在,也看不到三五年内就会问世的迹象。但如果等到它问世再来操心与其有关的安全问题,显然为时已晚。我们必须确保通用AI甫一诞生,就在人类的掌控之下,或享有一定的自由但其目标或价值观不偏离人类的想法。AI与人类价值观不一致,学界现行的术语称为“价值未对齐”(unaligned),可能会驱使AI牺牲人类所在意的价值来追求自己的目标。这个目标未必是要恶意地消灭人类以独霸世界。生存性风险研究的先驱尼克·博斯特洛姆(Nick Bostrom)在《超级智能》一书中举过一个已成经典的例子:假如一个智力足够发达的AI被拥有它的一家回形针制造商设定了“高效生产回形针”的唯一目标,它可能会采用各种手段控制全世界所有可以服务于这个目标的财力、物力甚至人力资源,不停地生产回形针,毁掉人类的生存环境,并且人挡杀人,佛挡杀佛。

意识到“价值未对齐”问题后一个自然的提议是,在算法层面上对AI设置奖励函数,将其所追求的价值与人类的价值观绑定在一起。但这并不容易,因为一般人的价值观并不能化约为几条简单的规则写下来,更不用说古今中外人们对一些具体的道德问题甚至根本的道德原则都未达成共识。读者很可能听说过电车难题,无人驾驶研究者们已经在争论这一难题未来若干年就将变成现实的一个版本:当紧急路况迫使无人驾驶汽车不得不在车外行人和车内乘客的生命安全中做出选择时,应如何决策。这个比设置通用AI的价值观要简单得多的问题,直到现在都还没有很好的答案。

奥德承认,对于价值未对齐的AI构成的生存性风险,研究尚在早期,难以看清问题全貌,所以是本书推测性最强的一种风险。毕竟,我们很容易想象核战争爆发是怎样的情形,也大体上知道流行病如何传播,但没有人能确定未来AI的危险会以什么形式出现。(是通过互联网控制大批个人电脑、服务器甚至嵌入式系统扰乱信息秩序?是开发利用新的破坏性技术?还是影响、操纵政治领导人等关键人物,让人们彼此为敌?)不过,考虑到比人类更具智能的主体会带来的极大威胁,哪怕它出现的可能性很小,也绝不容轻视。

书中接下来讨论了反乌托邦社会、纳米技术制造的微型武器、地外探索带回的微生物污染等其他未来风险。在核战争、气候变化、环境破坏、大流行病和价值未对齐的人工智能之外的所有其他可预见人为风险,书中给出了1/50的概率;不可预见的人为风险则是1/30,与基因工程造成的大流行病相当。为什么要给不可预见的未来风险赋予这么高的概率?我们需要想象一下,1930年的研究者如果要像本书所做的一样编制一份生存性风险列表会怎样。显而易见的是,他们无法预想到20世纪40年代以降才出现的最重要的几大风险。有时科学家们也不能确定,或未能意识到,自己是否低估了所研究对象的风险。前文写到过的原子弹爆炸引燃大气层的可能性就是一例。

二、怎么办

显然,1/6这个风险概率高得可怕。即使像一开始说的,这只代表数量级而不是一个精确估计,位于同一个数量级的1/10甚或1/20之类的数字也完全不可接受,亟须压降。一个很自然的想法是,对于不同的生存性风险,应该分而治之,各个击破。事实上,奥德确实给各种风险提供了政策和研究建议。比如,针对核武器,建议重启或续签一些关键的裁减军备条约;针对基因工程大流行病,建议让《禁止生物武器公约》具备与《禁止化学武器公约》同等的执行效力,配备相应的财力、人力、权力,同时让危险病原体筛查机制所有的DNA合成业务,等等。

但这不是应对风险的唯一路径。另有一些问题,本身不构成生存性灾难,却会间接促发一种或多种生存性风险。例如,一战或二战规模的大国战争一旦爆发,几乎肯定会增加核武器、生物武器带来的风险,气候变化和人工智能方面的国际合作也会随之停滞。奥德把此类增加生存性风险的问题称为“生存性风险因素”。他估计大国战争这一因素所起的作用占到了整体生存性风险中的十分之一,也就是说,对整体风险的影响盖过了全部自然风险的总和。避免大国战争因而是减少生存性风险的必要工作之一。而核武器和气候变化不但本身构成生存性风险,也是可能促成其他灾难性事件的风险因素,甚至作为风险因素的角色还更重要。

另外需要注意的是,对于诸种生存性风险和风险因素,并不是在整体风险中占比越大就越该被优先处理。假如投入同样多的资源可以把人工智能的风险从10%降至9%,或者能将基因工程大流行病的风险从1/30的水平降至与自然产生的大流行病相当的万分之一的水平,那么把资源用于原本概率较小的后者,反而能更多地减少整体风险,因此是更有效的选择。

在问题解决难易程度(可处理性)之外,还应该考虑问题被忽视的程度。有些生存性风险或风险因素已经获得了大量关注和随之而来的资源,所以可能恰恰是另一些重要性与可处理性不那么高的风险应该被赋予更高的优先级。举例来说,价值未对齐的人工智能一俟出现,对人类社会极有可能“一击致命”。大流行病等风险则遵循幂律分布,发生多次较小规模的事件(如死亡数百万人),才会出现一次更大规模的爆发(死亡数亿人)。而较小规模的事件已经足够糟糕,必然会引起人们的警觉和行动(不妨将其称为“预警信号”),从而不太可能被忽视。由此一个反直觉的推论是,如果其他条件大致相同,反而是那些“预警信号”阙如,而不是经常有机会在媒体上“唤醒人类行动意识”的风险,更应得到重视。

当然,目前生存性风险干预工作面临的首要问题是整体投入不足。奥德抱怨说,每年全球有大约4万亿美元流向教育领域,可用于减少各类生存性风险的资金总计只有1亿美元左右。考虑到我们不能承受哪怕一次生存性灾难,1亿这个数字简直小得荒谬。他提议将这项预算提升至全球生产总值的百分之一。

三、长远主义和有效利他理念

本书主张,接下来的几百年很可能是人类历史上最危险的阶段。我们要么能尽快把整体生存性风险降低若干数量级,从而进入较为安全的未来,要么继续维持当前甚至更高的风险水平。而在后一种情况下,由简单的概率知识可知,人类持续安全生存下去的概率会随着时间减少。作为简单示意,假定接下来每个世纪的整体生存性风险概率都是1/6且互不相关,那么用不了一千年,人类不遭遇任何生存性灾难的可能性就会降到20%以下。相信没有人会不想让人类处在前一种情况,小心行过危崖之后迈入一望无际的平原。

这一关键论断多少有些令人生疑。人类如能安然度过接下来几个世纪,并把生存性风险降至可接受的微乎其微的水平,也并不必然意味着威胁已被一劳永逸地解决。不要忘记,书中给接下来一个世纪出现不可预见的人为生存性风险给出了1/30的概率。消除一些普遍性的风险因素肯定会减小这个数值。然而不能排除的一种情景是,由于科技总在推陈出新,人类在一个或几个世纪后又将面临新的、更易爆发的生存性风险,再度踏上危崖。

不过,乐观地看,如果届时我们的后代也能逢凶化吉,也许就有望实现星际旅行并定居外星。书中最后一章基于物理的终极可能性,展开了一番眼花缭乱的计算后告诉读者,人类一代代接力,最远可以触及的范围是160亿光年,在1500亿年适合宇宙航行的机遇窗口内抵达其间200亿个星系。人类也会在如此漫长的时间中打造出远远超乎当代的文艺作品、生活体验、道德品质和物质成就。一万年前甚至一百年前的人们想象不到我们现在的丰富生活,我们就更不可能想象出在如此久远的将来,极有可能肉身已经技术改造过的亿万后人,过的是什么样的日子了。

关心这等巨幅尺度上的未来,是“长远主义”(longtermism,译本中作“长期主义”,但由于这一思想所考察的时间段甚为久远,迥异于日常或经济、金融意义上的“长期”,很多中文世界的研究者和爱好者更倾向于译为“长远主义”)伦理观的特色。在长远主义思想背景下,当今世界的多数纷争根本无关紧要。我们最重要的使命,是在这个危机时代保全和发展人类社会,不至于毁掉后人的长远前程。

作者奥德还是另一思想运动“有效利他主义”(effective altruism,又译“有效利他理念”或“实效利他主义”)的共同发起者。这种理念最早出自慈善公益领域,是对该领域中“花钱主要换来捐赠者自我感觉良好,不计量对受捐者帮助效果”的常见做法的全面反思,主张慈善组织应该量化评估捐助实效,把资金用在最能改善受捐者处境的项目上。后来,有效利他理念的影响溢出了狭义的慈善界,越来越多认同者将成本收益原则应用到各种善举上,如动物权利、精神健康、成瘾品控制事业等。

长远主义和有效利他理念看起来没什么必然关系,至少在早期也是各自平行发展。但秉持两种理念的人群有不少重叠,甚至现在大多数长远主义者同时也接受有效利他理念。这一现状的成因有一定偶然性。包括奥德本人在内的几位学者在两种理念的演进过程中都起了关键作用,围绕他们形成的两大社群自然也就有很多交集。

不过二者的亲缘关系也可从潜伏的思想脉络来诠释。有效利他理念主张“行最大的善”——著名哲学家彼得·辛格以此作为他倡导这一理念的著作书名。长远主义可以理解为,一些已经内化了有效利他理念的人,认为潜在的最大善其实就是人类可长达数亿年的未来中能够创造的价值,进而思考自己为此能做些什么。这样来看,长远主义就是有效利他理念自然扩展的逻辑结果。可能也正因为此,长远主义现已在很大程度上成为有效利他理念的最重要分支。

四、并非最后和最好的希望

今年伊始,这边厢《不要抬头》还在热映,那边厢担任联合国安理会常任理事国同时也是核大国的五个国家联合发表《关于防止核战争与避免军备竞赛的联合声明》,申明“核战争打不赢也打不得”,要“防止核武器未经授权或意外使用”,并重申“不将核武器瞄准彼此或其他任何国家”。

当初正是核武器开启了危崖时代,而核战争可以说也是当下各种生存性风险中能在最短时间内爆发的一种,并且冷战结束后在公众视野中消失了多年,有被忽视之嫌。五个核大国重新意识到这一问题的严重性并做此表态,或许能让我们对全身而过危崖多一点信心。

当然,还有更多棘手的威胁需要应对。今天一纸声明也好,明天战胜新冠肺炎疫情也罢,又或者知晓小行星和彗星不会摧毁地球生物圈,都不该是人类最后和最好的希望。我们理当期待和要求自己做得更多。但愿我们的作为,能让人类社会在数亿年后依然生机勃勃,并让那时回望此刻的历史学家们,庆幸我们做出了正确的决定。

本文来自微信公众号:经济观察报观察家 (ID:eeoobserver),作者:韩明睿