本文来自微信公众号:APPSO(ID:appsolution),作者:周宇,题图来自:IC photo

iOS 15 系统上的惊喜功能无疑就是实况文本了,但身边不少朋友升级之后告诉我用不了,打开图片根本没有相应的“文本识别”按钮。

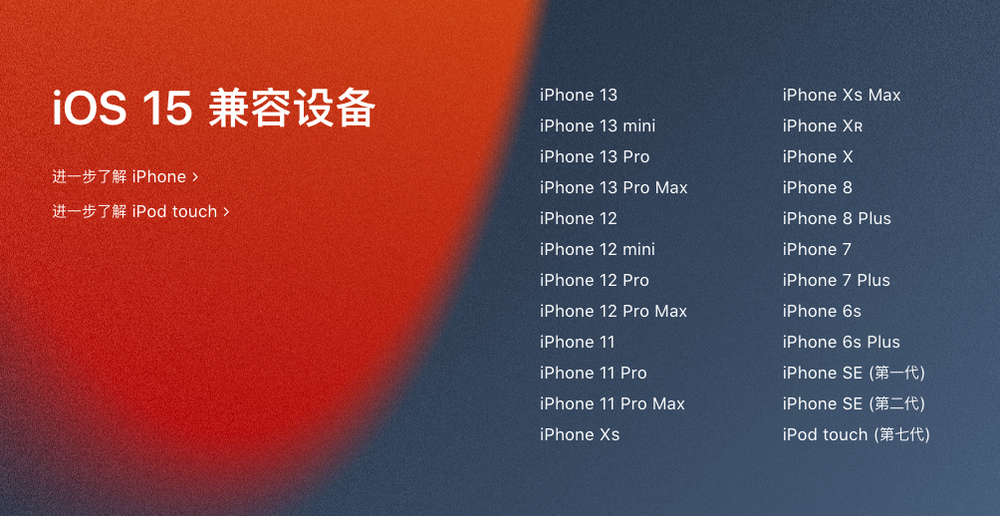

细究之下,发现原因竟然是 A12 芯片,苹果在官网的 iOS 15 功能页用小字指出了实况文本功能的要求:

在配备 A12 仿生或后续芯片的 iPhone 上提供。

最早搭载 A12 芯片的机型是 2018 年发布的 iPhone XS、iPhone XS Max 以及 iPhone XR,也就是说它们以及之后更新的机型,都能用实况文本。

我仔细看了看 iOS 15 的功能详情页,发现 A12 芯片不仅仅是实况文本功能的基础要求,还是 FaceTime 中的人像模式、宽谱模式、语音突显模式、键盘连续听写等等一系列新功能的门槛。

数个 iOS 15 新功能“淘汰”了旧设备,是因为苹果想让你换新机?

A12,iPhone 体验的新门槛

我们不妨先来看看实况文本等功能的原理。

实况文本功能指的是 iPhone 可以识别图片中的文本内容,包括电话、地址等,甚至还可以在相机界面实时识别输出文本结果。

常见的 OCR 图片识别应用基本上是通过上传数据到云端,然后再识别输出结果,但苹果对于隐私极为看重,这些行为都是在 iPhone 设备本地运行的。

iPhone 此时就像人一样,摄像头是眼睛,芯片是大脑,实时识别画面中的文字信息以及类别。

要在本地完成实时扫描与识别乃至输出结果,甚至还支持 7 种语言,可见对于 iPhone 的算力要求有多高。

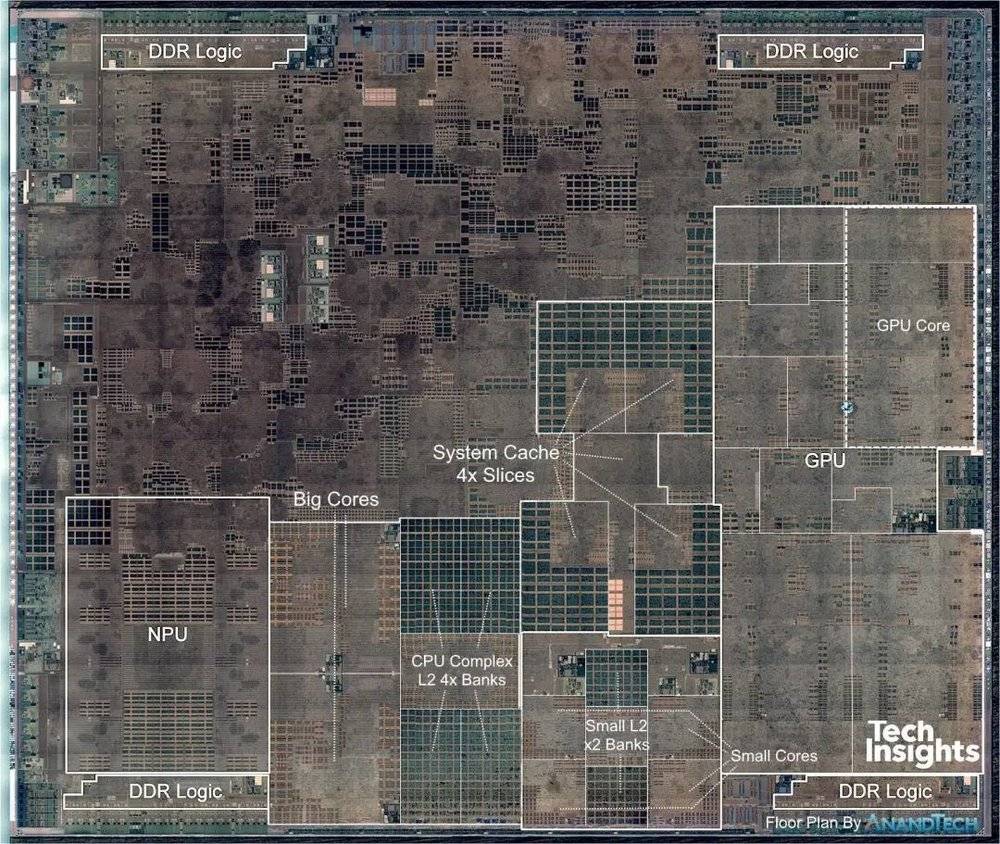

说到这里大家可能都猜到了,这里的算力指的并不是我们常见的 CPU 和 GPU,具备强大算力和智能识别效果的应该是苹果 A 系列芯片中的 AI 神经引擎模块。

相比常见的 CPU 和 GPU,AI 芯片模块往往有着更多计算单元,更少功能逻辑单元,这让它能更好地配合智能算法,完成低精度高计算量的运算。

在刚刚过去的苹果秋季新品发布会上,苹果也强调了 A15 芯片强大的 AI 算力对于 iPhone 13 系列、iPad mini 的助益。

包括 FaceTime 中的人像模式,自动虚化背景,让视频中的你成为核心,以及宽频音频等功能背后,都少不了 AI 神经引擎的支持。

早在 iPhone 11 发布时,苹果前营销高管菲尔・席勒(Phil Schiller)就表示,目前 iOS 系统功能中,基本上已经没有不使用机器学习(AI)的领域了,可见其影响力。

至于为什么是 A12 ,看看 A 系列芯片的发展史就知道了,A11 是苹果首次加入神经引擎模块,算力为每秒 6000 亿次运算,这还是一次尝试。

到了 A12 苹果在 AI 神经引擎方面才真正走向了成熟,不仅芯片工艺上从 10nm 走向了 7nm ,神经引擎也迎来了跨越式的提升,从 A11 的 6000 亿次运算直接增长到了每秒 5 万亿次运算。

现在答案就呼之欲出了,芯片 AI 算力大小限制了功能,能升级 iOS 15 并不意味着能使用完整版,A12 芯片就是 iPhone 体验的一道新门槛。

A 系列性能增长正在变缓,Ben Bajarin 整理图片的显示从 A8 到 A11 芯片,四年间单核性能增长了 192%,而 A12 到最新的 A15 芯片,四年间性能增长仅 91%。

3-4 年刚刚好是常见的 iPhone 用户更新换代周期,之前你换一次手机能获得近 2 倍的性能提升,而现在只有 1 倍左右,这差距可不小。

当然,即便如此苹果 A 系列芯片仍然在智能手机芯片领域一骑绝尘,最新发布的 A15 芯片虽然被吐槽 CPU 性能增长较小,但按苹果的话就是:超越竞争对手 50%。

如今的智能手机体验已经不仅仅看绝对性能表现,经过十多年的发展各家在基础体验方面都做的不错,流畅度差距并不是那么大,拉开差距的反而是各种独特功能,至少在充电功率这件事上 iPhone 走在了主流 Android 旗舰后面。

再回到市场表现上看,三星和苹果把控高端手机市,拿走大部分利润的情况并没能一直维持,之前华为突破过,现在 OPPO、小米、vivo 等手机厂商也在不断突破。

即使常年领先的苹果,面对激烈竞争也得做出改变,A 系列芯片性能增长变缓的同时,和 iPhone 功能的联系也愈发紧密,AI 神经引擎就是一个成功案例。

A11 的转向、A12 的成熟为苹果打好了基础,今年 iPhone 13 系列独占的“电影模式”功能背后,同样有 AI 神经引擎的身影。

在 iPhone 13 系列发布后,苹果人机界面设计师约翰(Johnnie Manzari)接受了外媒 TechCrunch 的采访,其中提到了电影模式的由来,以及苹果内部如何完成这一功能。

通过观看电影以及与世界级摄像头的探访,苹果内部团队发现了一个洞察——电影通过焦点变换引导观众的注意力,电影模式的焦点变换功能也因此而来。

团队将探索电影模式过程中得出的艺术需求和技术需求变成了一个又一个机器学习问题,进而与公司内部的机器学习研究团队、芯片团队合作,最终完成了我们现在看到的电影模式功能。

A15 芯片相比 A14,在 AI 神经引擎算力方面从每秒 11 万亿次运算增加到了每秒 15.8 万亿次运算,整整增加了 40% 多,正是为了向电影模式这样的功能提供动力。

对于苹果 A 系列而言,性能仍然很重要,但功能的优先级也在不断提升,从 iPhone 11 的 Deep Fusion 影像功能到现在的实况识别、电影模式,A 系列芯片与 iPhone 功能的绑定越来越多,也越来越深。

一颗苹果芯,“淘汰”旧 iPhone

功能与芯片深度绑定,是苹果软硬一体产品策略的一部分,这也是一直以来 iPhone 的优势之一,对于芯片拥有自主权的苹果,可以根据体验反推到芯片、技术,最终凭借强大的开发实力实现,与其他竞争对手拉开体验距离。

在这个过程中,苹果也完成了产品线的梳理,今年 iPhone 13 Pro 系列才有ProRes 功能,能保留更多视频原始信息,让视频看起来更真实,它同样也离不来满血版的 A15 芯片,5 核心 GPU 能让 iPhone 更好更快的处理视频内容。

同时芯片也是 iPhone 数字基本款和 Pro 系列重要的差别之一,定位更好的 Pro 系列享受更好的芯片,连带着更好的功能,最终形成体验上的升级,而数字基本款则面向大众,提供标准线上以上的体验。

和旧款 iPhone 相比,13 系列的新功能也是区分两者的重要因素,外形、功能、性能等,都在影响着人们的消费购买决策。

软硬一体化的产品策略,芯片和功能深度绑定,让 iPhone 每年都能获得升级,体验越来越好。

A 系列芯片性能、制造工艺等的不断升级也在促进 iPhone 的系统更新周期,从早期的两三年一直到现在的 6 年甚至更多,iOS 15 还支持 2015 年发布的 iPhone 6s。

但这并不意味着旧 iPhone 能无限用下去,性能、硬件损耗之外,软件也是影响手机使用的重要原因,甚至是一部分人更新换代 iPhone 的原因。

iOS 系统能更新到最新版,和芯片深度绑定的功能却无法再体验到了,像实况文本这样的功能无意间就“淘汰”了旧 iPhone 。

在手机硬件都正常的情况下,有多少人会为了新功能换机呢,你会吗?

本文来自微信公众号:APPSO(ID:appsolution),作者:周宇