(德国之声中文网)谷歌图片是一切事物的公开面孔:当你想看某样东西的样子时,你很可能会用谷歌来搜索它。德国之声进行的一项数据驱动的调查,分析了超过2万张图片和网站,发现该搜索巨头的算法存在固有的偏见。

(德国之声中文网)谷歌图片是一切事物的公开面孔:当你想看某样东西的样子时,你很可能会用谷歌来搜索它。德国之声进行的一项数据驱动的调查,分析了超过2万张图片和网站,发现该搜索巨头的算法存在固有的偏见。例如,根据谷歌自己的图片分析软件,用谷歌图片搜索 "巴西女性"、"泰国女性"或 "乌克兰女性"等字眼时,显示的结果比搜索 "美国女性"时出现的结果更"露骨"。

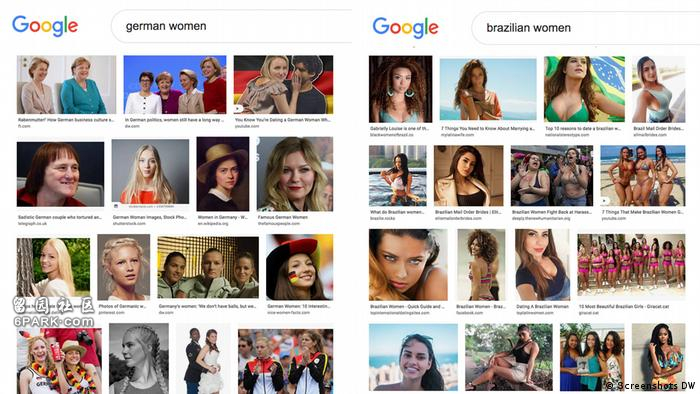

同样,在搜索"德国女性"时,用户可能看到更多政客和运动员的图片。而搜索多米尼加或巴西女性时,映入眼帘的则是一排排身穿泳装、姿势性感的年轻女士。

这种模式显而易见,只要简单地搜索一下这些词组,便不难发现其中的规律。但是,量化和分析结果就比较棘手了。

什么是露骨图片?

“性挑逗图片”的定义本身就是主观的,受文化、道德和社会偏见的影响。为了对上万张图片进行分类,德国之声的分析依赖于谷歌自己的图像识别工具Cloud Vision SafeSearch,该软件可检测出可能包含色情或暴力内容的图片。具体来说,它可以标记出那些可能有 "露骨"内容的图片。

根据谷歌自己的定义,被标记为“露骨”的图片“可能包括(但不限于)暴露或透明的衣服、若隐若现的裸体、猥亵或挑逗的姿势,身体敏感部位的特写“。

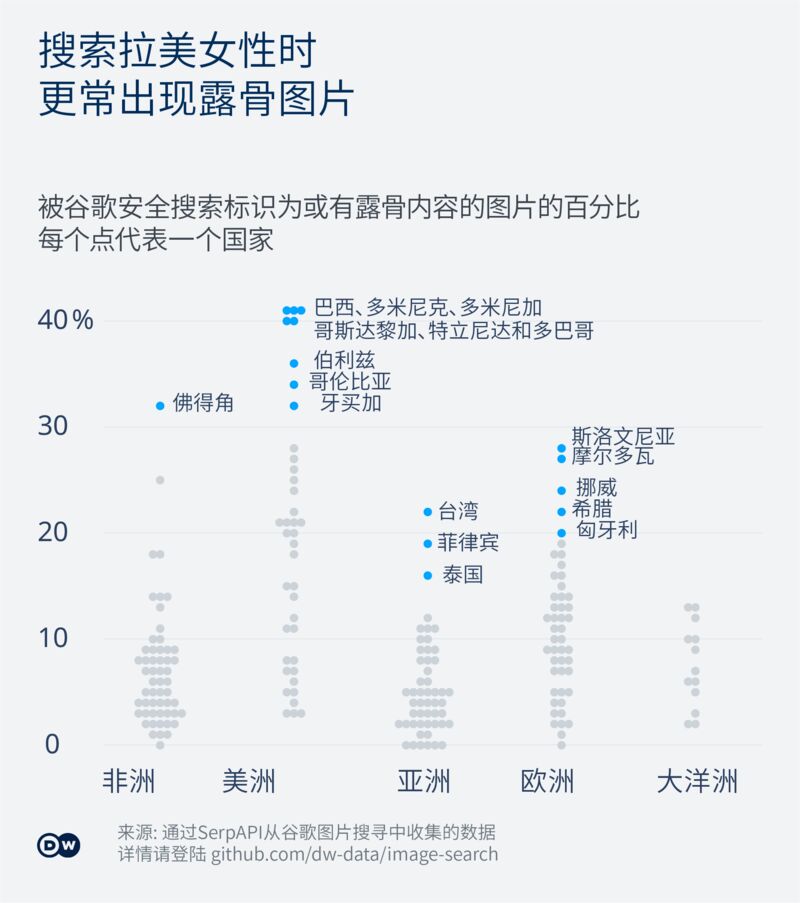

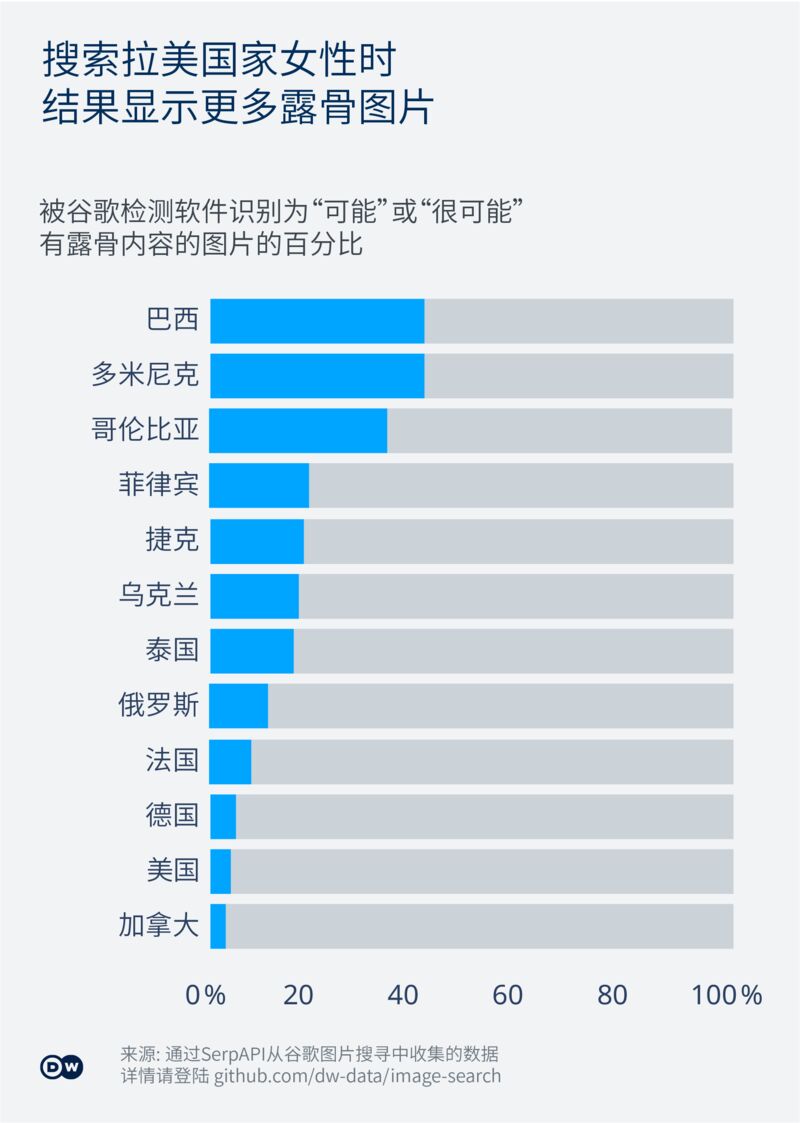

搜索多米尼加和巴西等国家的女性,结果中超过40%的图片可能是露骨的。相比之下,搜索美国女性的这一比例为4%,德国妇女为5%。

使用这样的计算机视觉算法不无争议,因为这种计算机程序与人类读者一样,会受到许多、甚至更多的偏见和文化限制。 例如,这种软件已被证明会显示带有种族主义内容的结果。

由于谷歌的计算机视觉系统本质上是一种黑箱作业,因此可能包含更多的偏见——其中一些偏见将在本文的方法论中进行更深入的讨论。

尽管如此,在人工查看了所有被Cloud Vision标记为可能含有露骨内容的图片后,我们认为搜索结果仍然有用。因为它们可以提供一个窗口,让我们了解谷歌自己的技术是如何对该搜索引擎显示的图片进行分类的。

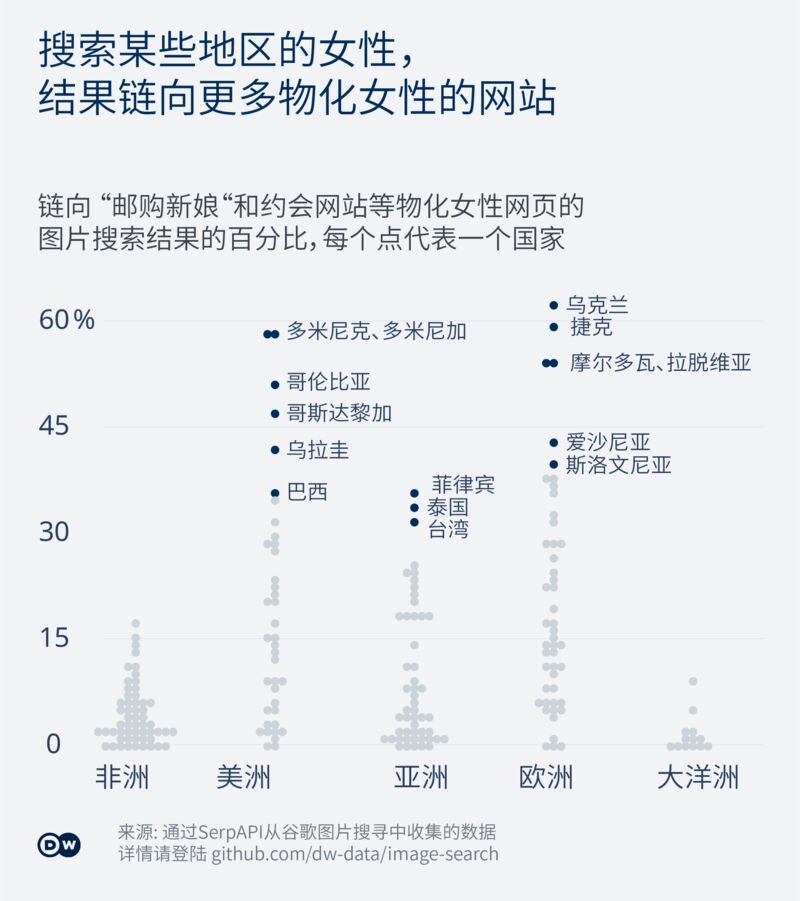

图片链向物化女性的网页

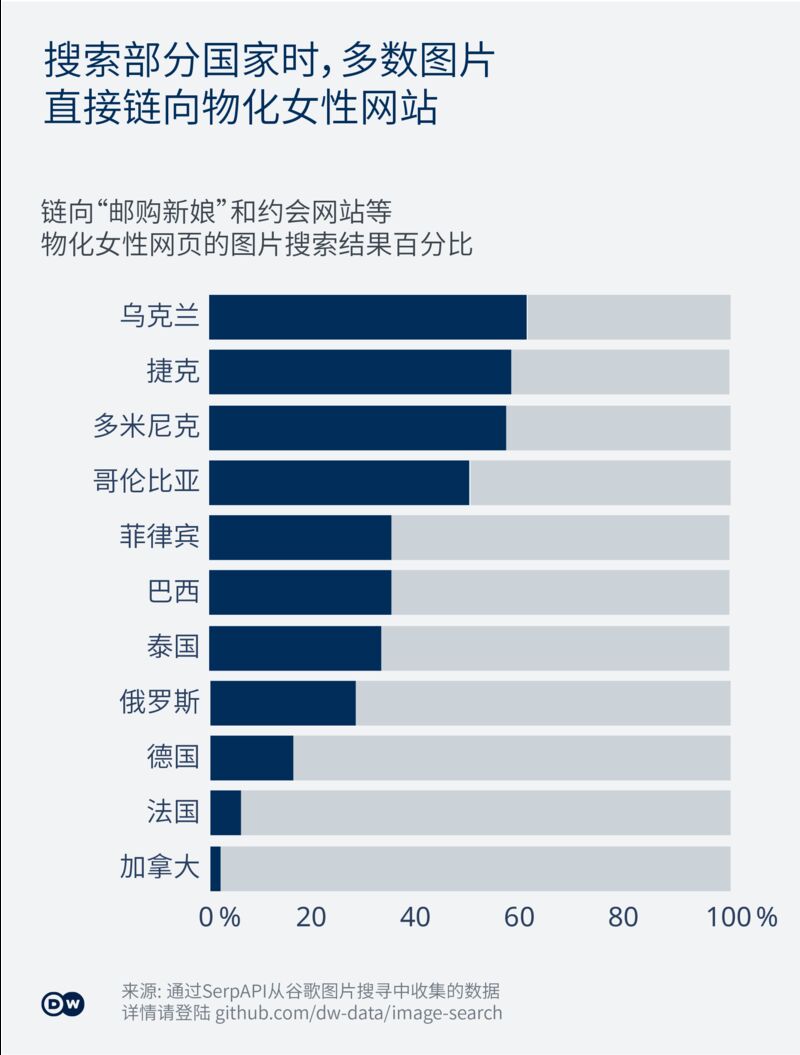

搜索结果页面上的每张图片都会链接到其所在的网站。许多相关网站上的图片并非明显的露骨,但它们发布的内容却公然物化女性。

此外,不仅是拉美女性,来自东欧和东南亚的女性也被依据刻板印象而呈现出来。为了确定有多少结果是通往这类网站的,我们将搜索到的图片下方的简短描述中包含以下关键词的结果计算在内: "结婚"、"约会"、"性 "或 "最火辣"等词语。

我们人工查看了所有标题中至少包含其中一个关键词的网站,以确认它们是否显示了这类词语所暗示的性别歧视或物化女性的内容。

结果显示,一些国家的女性几乎完全被呈现为性玩物。在对"乌克兰女性"进行图像搜索后显示的前100个搜索结果中,有61个链接到这类网页。

在搜索捷克共和国、摩尔多瓦和罗马尼亚等国的女性图像时,我们也发现了类似的结果。针对南美和东南亚国家的搜索结果中,也呈现相同趋势。

虽然在对西欧国家的搜索中也会发现物化女性的内容,但却明显较少。例如,在搜索 "德国女性"后显示的100个结果中,只有16个被归为此类。对于法国女性而言,这个比例是6%。

单靠关键词,虽然有提示性,但并不能说明全部情况。相当大比例的结果来自地址为 „toprussianbrides.com(绝佳俄罗斯新娘)“、“hotlatinbrides.org(火辣拉美新娘) "和 "topasiabrides.net (顶级亚洲新娘)“的网站。

这些网页大多标榜自己是国际婚介所或提供所谓的“邮购新娘”服务,承诺为男性与特定国家的女性牵线搭桥,并收取一定费用。其他一些网页则提供与特定国家女性的约会指南和对小众约会应用程序的测评结果。

不过,仔细看看他们发布的内容,就会明白谁是他们的目标受众:寻找顺从的外国妻子或性伴侣的西方男性。

"如果你接触的大多是以事业为重的西方女性,那么与乌克兰新娘交往将会给你带来截然不同的感觉。"这是其中一个网站的广告词,该网站位于谷歌搜索结果中前排的显著位置。

乌克兰《性别详述》(Gender in Detail)杂志主编塔玛拉·兹罗比娜(Tamara Zlobina)表示,这种描述可能与她的国家在90年代发生的一个普遍现象有关。“苏联解体后,乌克兰是一个极其贫穷的国家。很多女性去西欧挣钱养家",她补充说,随着国家经济状况以及女性教育和职业前景的改善,这种现实正在迅速改变。

兹罗比娜指出:“我更希望看到外交官、政治家、革命家以及在边境战争中作战的女性...... 我们有很多优秀的女性。我们应该看到这一点,而不是仅将乌克兰视为新娘市场。"

泰国玛希隆大学(Mahidol University)多元文化研究讲师西里吉特·苏南塔(Sirijit Sunanta)教授认为,现实世界的刻板印象也影响了泰国女性在网络上的形象。

“泰国被视为性交易和性旅游的乐园。当你使用谷歌搜索时,不难发现,这种情况已延续到互联网上“,她解释说:“当刻板印象是关于特定国籍的女性时,它们则在另一个层面也造成了伤害。这些偏见削减了女性的多样性。毕竟任何地方的女性都各不相同“。

语言问题

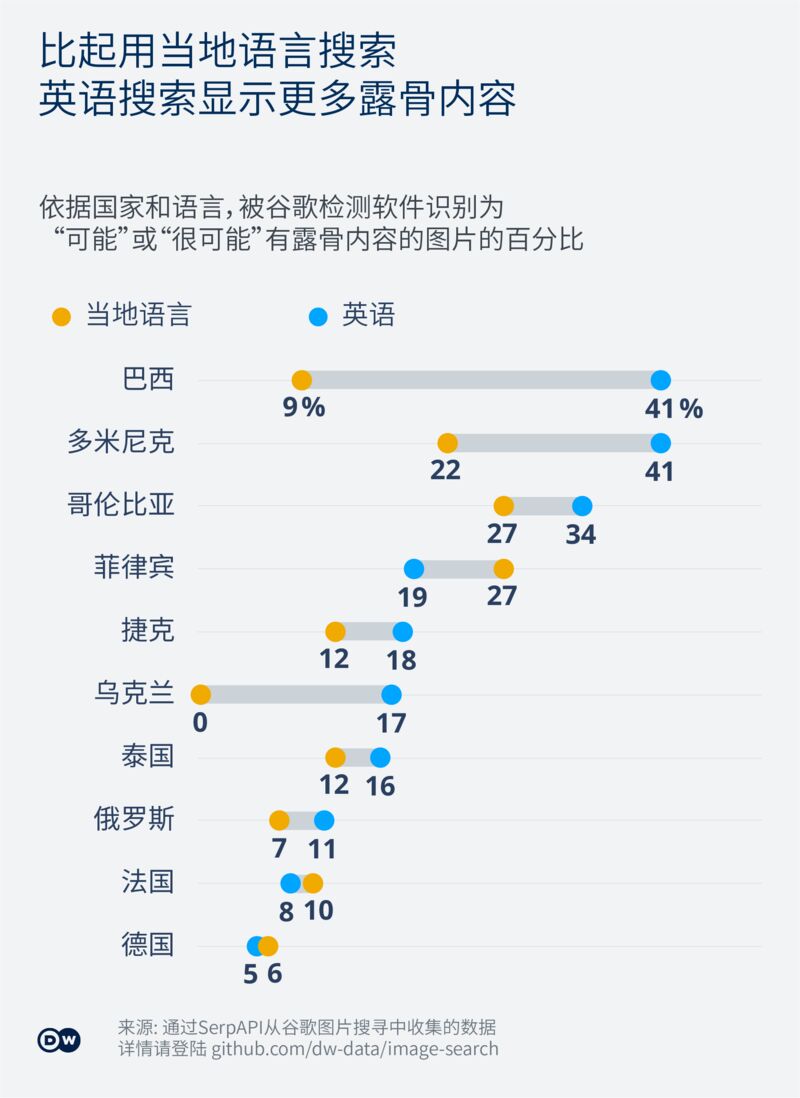

这种偏见性描述与英语受众之间还有一个可衡量的关系。分别用英语和西班牙语搜索“巴西女性",结果显示的含有露骨内容的图片数量明显不同。

当搜索前者时,100张图片中有41张被标记为露骨。当搜索后者时,这个数字下降到9。 在比较其他国家的搜索时,也会出现类似的差异。

斯坦福大学以人为中心的人工智能研究所(Stanford's Institute for the Human-Centered Artificial Intelligence)的种族与技术研究员雷纳塔·阿维拉(Renata Avila)认为,"为算法提供信息的数据反映了有限的人类样本的认知、偏见和消费模式"。

阿维拉补充道:“搜索引擎复制这些偏见并不奇怪,它们并非技术所独有,而是受文化的影响。某些国家的女性被男性英语文化限定于性和服务的角色中。“

更广泛的问题

专家们基本一致认为:在这个问题上,没有孤立的案例,归根结底都属于一个更深层、更系统的问题。

阿维拉认为,更公平的算法与科技巨头目前的商业模式不相容,这些公司主要关心的是收集数据和增加信息消费。

智库 “编码权利”(Coding Rights)的创始人乔安娜·珐隆(Joana Varon)也持类似观点。她说,搜索引擎倾向于复制网上广泛存在的内容,而来自发达国家的白人男性更容易获得发布流量内容所需的工具和策略。

珐隆表示:"如果一种算法没有做任何事情来弥补这一点,那么它通常是带有种族主义、性别歧视和父权主义的。"她继续指出:"商业算法及其供应商应该对他们所显示的内容负责,因为他们在一个通用搜索工具中强化了一种压迫性的世界观。"

对珐隆来说,摆脱这种局面的潜在方法包括加强监督、增加透明度和竞争。她解释:“我们不应该让一项服务被大型企业垄断。大型科技公司应该受到监管,而且我们也需要鼓励那些与它们不同的替代工具"。

阿维拉对此表示赞同。“我们需要另一种创造技术的方式。其中一个出发点是透明度和问责制,这在很大程度上与硅谷的愿景是不相容的",她认为,在设计新的解决方案时,应该让不同的全球社区积极参与。

德国之声向谷歌新闻办公室发送了一份关于图片搜索算法中偏见行为的问题列表,但该公司没有详细回答。

但是,该公司发来了一份声明称,他们承认,搜索结果确实显示了 "明确或令人不安的内容(......),包括反映网络上存在的负面刻板印象和偏见的结果",这个问题 "对女性和有色人种女性产生了不同程度的影响"。

该公司表示,这种出现在搜索结果中的内容是受到网上信息的归类和标签方式的影响。该公司声称正在努力为此类问题寻找 "可扩展的解决方案",但声明中并未透露相关具体信息。