本文来自:财联社,编辑:史正丞,原文标题:《OpenAI删除“禁止用于军事用途”条款 解析:松绑国防订单限制》,题图来源:视觉中国

在刚刚过去的周末,有关OpenAI公司修改“用户政策”一事逐渐发酵,舆论最关心的一点,正是拥有全球最先进AI技术的公司,拿掉了 “禁止将公司AI用于军事、战争用途”的限制。

先解释一下整件事情,OpenAI在上周(1月10日)悄悄更新了用户条款,旨在提供“更具有可读性”、“更加针对具体业务”的指引。由于上周市场的焦点是新上线的GPT Store,所以科技媒体们过了几天才反应过来——OpenAI这次修改条款竟然还“别有用心”!

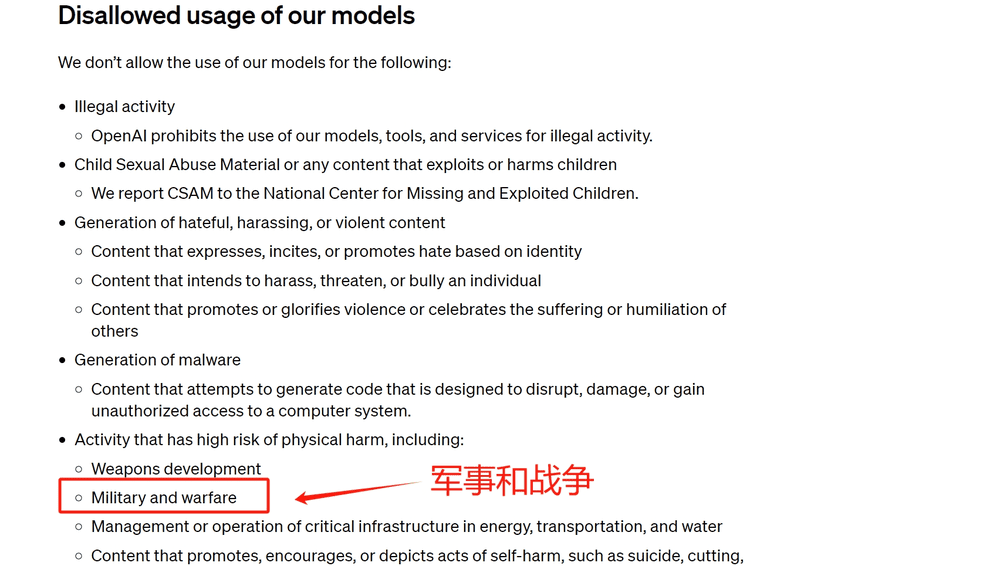

在修改前,OpenAI的条款中明确表示,禁止将公司模型用于“造成物理伤害的高风险活动”,包括武器开发、军事和战争等。“军事”一词,极为明确地将美国国防部、美军、CIA等排除出了OpenAI的用户范畴。

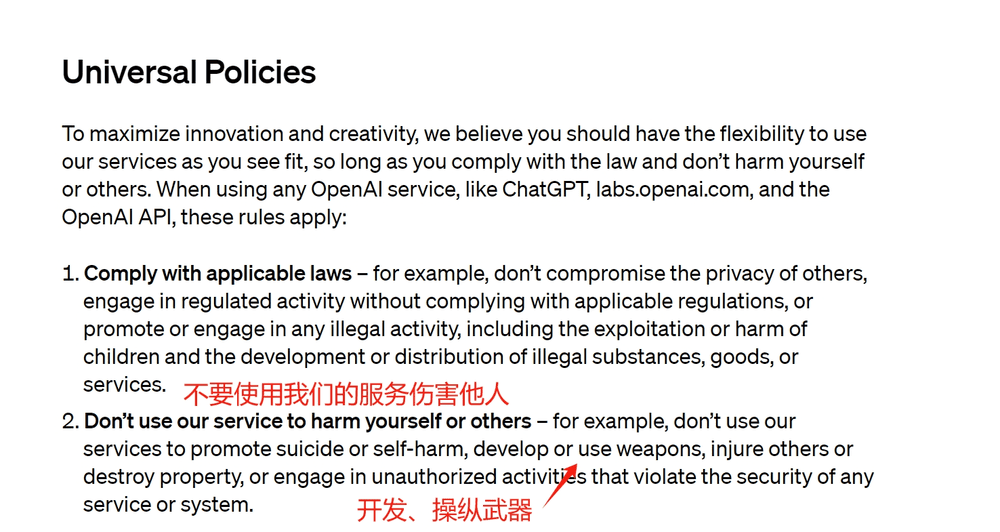

在上周的修改后,OpenAI在“通用政策”条款中虽然也有“不要使用公司服务伤害自己或他人”,并明确表示禁止“AI开发或操纵武器”,但军事这一关键限制性词汇,却从政策中消失了。

面对反应过来的媒体,OpenAI一开始依然在玩“文字游戏”。公司发言人在回应调查新闻网站The Intercept时表示,公司重写用户政策的目的是创建统一的原则,既容易被记住,也容易应用。像是“不要伤害他人”这样的原则就非常广泛,非常容易理解且能关联大量的语境。

这名发言人拒绝透露,“不伤害他人”是否等同于禁止一切军事用途,仅举了一堆例子强调,OpenAI的技术不得被用于武器、(伤害或摧毁)财产,或者在未获授权的情况下侵犯任何服务或系统的安全。

然而,面对死咬着“军事”这个词不放的媒体,OpenAI最终还是松口了。在发给科技媒体TechCrunch的追加声明中,公司确认这一条款的调整,就是为了满足“与公司使命一致的国家安全用例”。

OpenAI在声明中表示:

我们的政策不允许使用我们的工具来伤害人们、开发武器、进行通信监控,或伤害他人或破坏财产。然而,存在一些与公司使命一致的国家安全用例。例如,我们已经与美国国防部的高级研究计划局(DARPA)合作,促进创建新的网络安全工具,保护那些对关键基础设施和产业至关重要的开源软件。在之前的政策中,这些有益的用例是否被允许使用在“军事”领域并不清楚。因此,我们政策更新的目的是为了提供清晰性,并能够进行这些讨论。

总结来说,相较于上一份政策直接将“军事用途”排除在外,OpenAI的最新政策打开了“军事GPTs”的大门,当然前提是“与公司使命一致”。

国防用途=多金钱途。

事实上从数年前开始,美国《国防授权法案》中一直都有价值数亿美元的AI专项拨款。而在上个月最新通过的法案中,更是给美国国防部下达了多项与AI有关的任务,包括设立“首席数字和人工智能官员的治理委员会”,检测五角大楼可能用到的人工智能模型中,可能存在哪些缺陷。

举个“离钱更近”的案例,去年底美国国防部授予上市公司Palantir价值2.5亿美元的合同,为美军使用AI的能力提供支持。除了国防部外,Palantir的“大金主”还包括美国的中央情报局。

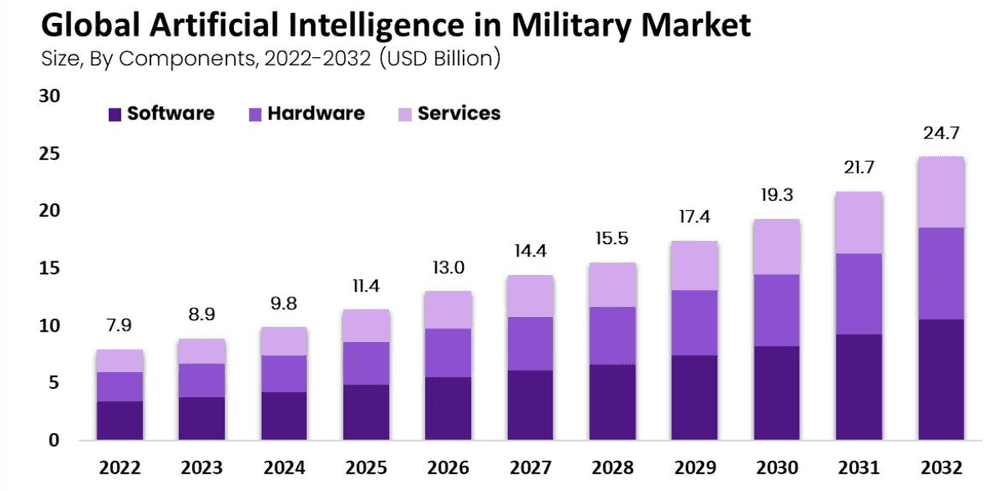

根据市场研究机构market.us的报告,2023年全球军事AI市场规模大致为89亿美元,这个市场有望维持12.4%的年化复合增长率,并在2032年达到247亿美元。

(军事AI市场预测,来源:market.us)

报告指出,人工智能在现代战争中正扮演着重要的角色,起到的作用包括高效处理大量军事行动中产生的数据。一系列军事应用中都有AI的身影,包括信息处理、威胁侦测、网络安全、战场物流和运输等。

本文来自:财联社,编辑:史正丞