题图来自:视觉中国

中国的投资人和创业者,很久没有这么开心过了。

长时间的所谓“资本寒冬”,让所有的融资动作都变得谨小慎微,科技行业仿佛集体从热带移民至南极,只觉过完了一个冬天,下面还是冬天。而这样的形式,在2023年短短的三个月内,完成了神奇的逆转:今年Q1,各赛道完成融资796.22亿元(数据来自睿兽分析),是前三个月的13倍,比2022全年还高1倍多,其中绝大部分融资事件,都出自AI赛道。

将模型参数冲到百亿以上,然后开一场发布会,是上半年许多大模型公司的主要工作。

所以,当与小冰CEO李笛在望京见面,交流了关于大模型的成本、技术以及其他关键信息后,我们才惊讶地发现:这场大模型创业者与投资人的蜜月期,可能结束得比预期更早。

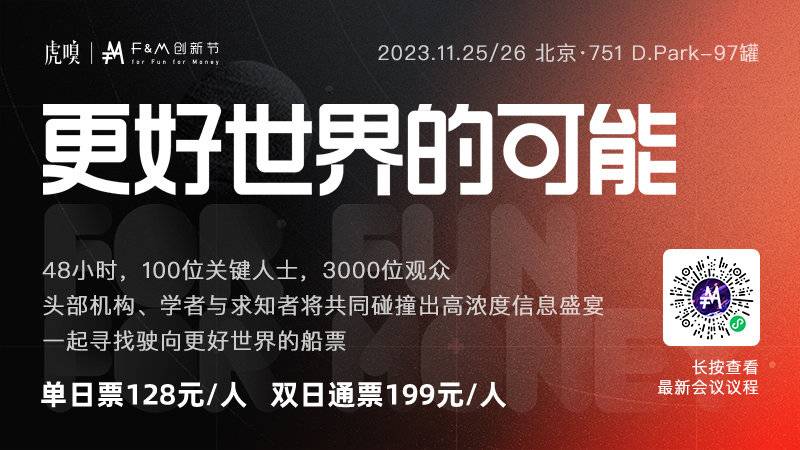

11月25日,李笛将参加虎嗅F&M创新节(11月25-26日,为期两天),他将在北京751D.PARK-97罐,为大家详细分享他在 AI、大模型领域的技术、产品和商业探索经验,以及过去一年在与国际专家交流中,形成的对于大模型发展趋势的最新判断。

“大模型的训练成本,已经成为行业内不得不关注的重点,”李笛说道,“并不是所有公司都适合做大模型。”

关于训练成本,其实业内早有认识,但从投资人到创业者,似乎都在回避这个问题。年初美团联合创始人王慧文高调宣称:“我的人工智能宣言,5000 万美元,带资进组。”没承想立刻就遭到行业内人士的批评,海通证券研究所科技产业链负责人郑宏达说:“5000 万美元,够干什么的?大模型训练一次就花500万美元,训练10次?”

然而大家可能还是太乐观了。根据此前 semianalysis 的爆料来看,如果使用 A100 来训练 GPT-4 ,单次训练成本约为 6300 万美元;如果使用 H100 进行训练,单次成本为 2150 万美元。如果加上实际工作中方方面面的额外成本,就算用上 H100,5000 万美元恐怕也只够训练一次。

这还没有计算实际的运营成本、研发成本、人力成本,2022年,OpenAI 巨亏 5.4 亿美元。反观中国创业市场目前存在 130 余家大模型企业,意味着所有人都挤上了这张“盲注”极大的牌桌。

这样的成本估算,就是终点吗?李笛表示,据可靠的技术判断,当下的大模型距离理想状态,至少还差三个数量级的参数,而大模型的技术标准,会在明年 Q1 基本确定。

留给大模型们的时间,已经不多了。

李笛提到,当下的 AI 产业,仅凭 AI 软件服务几乎很难取得丰厚的利润,大部分 AI 企业的方案是软件、硬件打包售卖,靠硬件赚取更多营收。这点从“ AI 四小龙”的财报上也能得到印证——市场规模越大,亏得越多,这是痼疾。

“ AI 服务当下还是以软件产品的形式,做一次性交付。客户不会考虑大模型预训练的成本,只会考虑大模型服务在推理过程中产生的成本。”李笛告诉虎嗅,“做成 SaaS 服务也不太行,做 SaaS 会发现市场很快就饱和了。即便参照云计算的发展路线,借鉴意义也十分有限,云计算毕竟有实打实的服务器可供租用,和大模型买GPU做预训练是两个概念。”

如果沿用互联网时代的流量思维,重心从 To B 转向 To C ,是否可行呢?现在 ChatGPT 付费版每月收费 20 美元,如果是调用 API,每输出100万个单词的价格约仅为 2.7 美元。百度文心一言付费版,连续包月的价格是 49.9 元/月。

无论是哪款,连订三个月,都不一定有东北人过冬买的几百斤大白菜开销大。

从成本最高、最有想象力的软件产品,到白菜一般的零售价格,中间到底谁在作祟?

我们把这一讨论的空间留给 2023 虎嗅 F&M 创新节,小冰公司 CEO 李笛,他将在 11 月 25 日登台发表演讲。活动报名开放中,让我们一块期待他的答案。

扫描下方图片二维码,立刻购票参与