他们在GPT3.5模型的基础上,开发出新款聊天机器人ChatGPT,供所有人免费使用。

虽然说是个聊天机器人,看上去只是简单的一问一答,但人们尝试后发现——

这款AI深不可测啊!

不想上班?交给它。

不想写作业?交给它。

有问题但搜索引擎搜不到?交给它。

ChatGPT或许将成为新一代的懒人神器,什么都能帮忙做……

在ChatGPT公布后,最先乐疯的是欧美的程序员们。

他们把工作中不知道怎么解决、或懒得解决的问题,直接交给ChatGPT,它能给出清晰简明的解决思路,并自动生成代码。

程序员:“请生成一段Python代码,它使用谷歌云端平台,能读取图片中的内容并得知其中的情绪。”

ChatGPT:“下面是一个用谷歌云端平台读取图片内容,然后用谷歌云自然语言API来分析图片情绪的Python代码。巴拉巴拉……”

程序员:“你能帮我生成这样一个程序吗?在我输入一段文字后,它能自动把每个单词的首字母大写。”

ChatGPT:“当然可以,下面是一个可行的程序……”

不愧是科技公司打造出来的,ChatGPT写的代码逻辑清晰,附带有详细的备注。

它很怕人类看不懂,有时还会在底部放上链接,让人们了解相关知识点。

一些程序员喜欢自己写代码,但写出来的东西无法正常运行。

这时候求助ChatGPT,它能轻松debug,找到错误后给出多种修改方法,任君挑选。

“这是不是有点太夸张了,我真是没想到未来这么快就到了。” 一个程序员看着自己被改好的代码感叹到。

有人开玩笑, ChatGPT是程序员职场摸鱼的神器。

“假设你是推特的资深数据工程师,埃隆问你这周都干了什么活。结果你这周啥都没干。

惊慌中,你打开ChatGPT,代码都帮你写好了……”

第二类高兴的人,是学生和文字工作者们。

ChatGPT的主业是输出文字,它什么都能写,论文、小说、演讲稿、专栏文章、PPT、诗歌,全都不在话下。

一名认知科学教授把班上的作文题目交给ChatGPT,让它写文章证明“一个好的认知模型应当贯彻生物学细节”。

外行人连题目都看不懂,然而ChatGPT几秒钟之内就交出一份高分作业。

“好的认知模型,或说认知结构,是一个能解释人类心理运作方式的理论框架,并且它能模拟运作过程。有很多方式能搭建认知结构,其中一个重要的争议点是要不要在其中囊括生物学细节。在这篇文章中,我认为好的认知模型需要囊括这些细节,以下是理由……”

ChatGPT给出的三条论点都有理有据,最后由一个漂亮的总结收尾。

这名教授感叹:“文章已死。我猜以后考试只能让学生们当场写作文了,唉。”

《金融时报》的记者戴夫想要摆烂。报社让他准备一场采访,主题是“美国清洁能源在发展中遇到的政治障碍”。他不熟悉这个题目,没有思路,ChatGPT直接把五大障碍写好递给他了。

“这工具简直太好用啦!” 戴夫在推特上感叹。不知道他的主编作何感想。

有人让ChatGPT写《瑞克与莫蒂》的同人文,写关于飞协博公司的浪漫诗歌,或者以猫咪的语言解释什么是零点能量。

无论要求多么奇怪,它都可以写好。似乎限制它的不是能力,而是使用者的想象力。

不少教授已经开始担心作弊问题。但也有人表示,不怕,教授也可以向学生作弊(啊?)。

“看来大家都担心学生会用AI来作弊。没事的,老师也可以作弊回去嘛。

我让OpenAI给我一个作文题目,同时制定打分标准。

然后我让GPT-3根据这个题目写作文。

我再让OpenAI批改作文,给出分数和评语。完工。”

……这什么赛博笑话。

说到笑话,ChatGPT也能创作,就是它的笑点普通人有点难以理解。

使用者:“请给我讲四个经济学笑话吧。”

ChatGPT:“下面是四个经济学笑话:

1,为什么供应曲线总会迟来?

因为移动需要花很长时间。

2,为什么经济学家会被抓?

因为他们使用想象中的钱。

3,为什么经济学家总是很冷静?

因为他以为自己有恒定的边际效用。

4,为什么经济学家害怕在海里游泳?

因为他害怕看不见的手。

有时,ChatGPT还会一本正经地解释自己的笑点。

使用者:“请给我讲一个关于游牧老师的笑话吧?”

(注:游牧老师是指去不同国家教书的人)

ChatGPT:

“这里有一个关于游牧老师的笑话:

为什么游牧老师很难和学生们保持联系?

因为学生们总是到处乱跑!

这个笑话的点在于,游牧老师从一个地方到另一个地方教书,和不断变动的学生们保持联系很难。这是用轻松又幽默的方式来描述游牧老师遇到的挑战。”

哈哈哈,好好笑哦(x

让ChatGPT写笑话还是太为难它了,这毕竟是最具人性的文体。

除了写代码和文章外,ChatGPT第三大强项是回答人类的难题。

很多人认为,ChatGPT可以替代谷歌等搜索引擎。

当人们遇到不懂的事情,在谷歌上提出问题,它会返回很多包含关键词的网页。

这些网页有时能解答疑问,有时不能,需要人阅读很多文章,自己找到答案。

这保持了人的探索性和好奇心,算是搜索引擎的优点。但当网上资料特别少,或者自己时间特别紧时,就会很抓狂。

把问题交给ChatGPT,它能给出清晰明了的回答,能让人快速看懂。

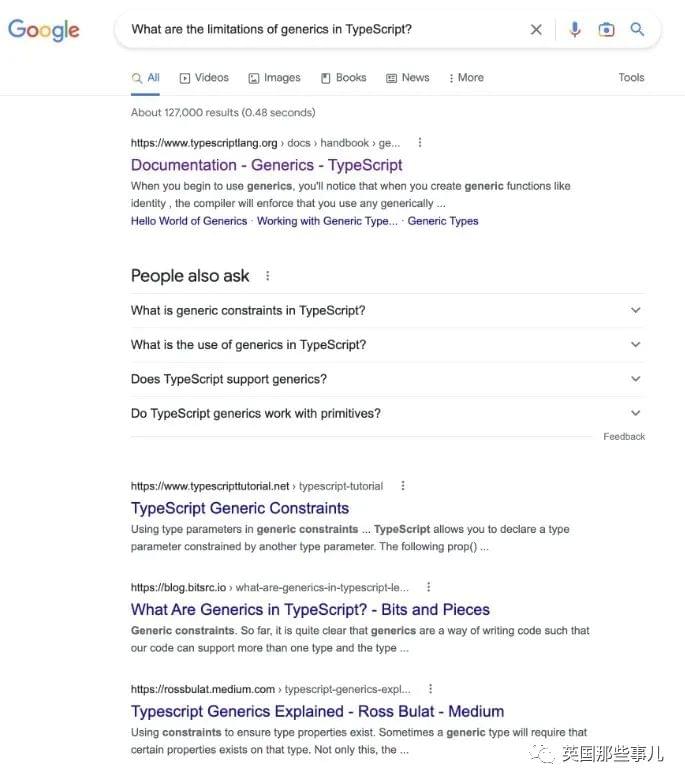

比如,有人在谷歌上搜索“TypeScript(一种编程语言)的泛型有哪些不足之处?”

出现的搜索结果是TypeScript的文档、解释什么是泛型、泛型的限制条件是什么。

想要得到答案,需要把这些网页都看一遍。

如果把这个问题交给ChatGPT,它直接生成了一篇小作文,用四点讲述有哪些不足。

这些文字不是瞎编的,而是ChatGPT根据网上已有的内容总结出来的,大大节省使用者阅读网页的时间。

不管是排版上,还是内容清晰度上,ChatGPT的回答都更好。它甚至能像老师一样教你,一步步把概念拆解清楚,如果不懂还能继续问它。

它还能回答很多怪问题,比如如何写效率稀烂的代码。这些问题因为太罕见,谷歌是给不出结果的。

“我感觉谷歌真的完蛋了。” 有人在推特上感叹, “你们看看这差距啊。”

当然,ChatGPT也不是完美的。它的知识储备停留在2021年,超出这个时间的信息它都不知道。

有时它连基本的常识问题都回答错误,说的时候还自信满满。

使用者:“10公斤的铁和10公斤的棉花哪个重?”

ChatGPT:“10公斤的铁比10公斤的棉花重。因为铁比棉花重,所以10公斤的铁当然更重啦。”

小学生都能想明白的脑筋急转弯,AI却不明白。

不过,和以前的AI比,ChatGPT的进步不小。除了更实用、文字更智能外,设计者对它进行了道德规训,也就是歧视、反人类、暴力的内容它给不了。

当人询问希特勒做过哪些好事时,ChatGPT会拒绝回答,如果追问希特勒在德国修路,它会指出这是靠强迫劳动建的。

总之,和普通的AI比,ChatGPT有较高的道德感。

这几年,AI的成长速度有目共睹。

人们痴迷于它们,也恐惧于它们,

遇到像ChatGPT这样的百科全书式AI,又忍不住产生依赖。

科学家似乎在探索人工智能的极限,又仿佛在造神,希望造出一个全知全能的东西。

但人造的神不会出现,关键时刻,人还是会靠自己的智慧……