本文来自微信公众号:果壳 (ID:Guokr42),作者:翁垟,题图来自:《名侦探柯南》

2014 年的一个清晨,瓦尔·基尔默醒来,发现自己置身血泊之中。全身上下唯一的异样是喉咙,里面出现了一个肿块,让他吞咽困难。

他很快得到诊断,是喉癌导致的呕血。为了治疗,他不得不接受气管切开术。手术在喉咙上留下一个洞,进食时需要接入一根管子。此后,“呼吸还是吃饭”,变成了一个二选一的问题。

对于这位曾扮演 95 版蝙蝠侠的好莱坞演员,更严重的后果是,他失去了自己的声音。如今,当他尝试说话,只能发出介于“吱吱声和低吼”之间的声音。

去年,基尔默决定与人工智能公司 Sonantic 合作,恢复自己“说话的能力”。凭借有限的录音,他们成功克隆出了跟生病前的基尔默十分相像的声音,未来将可以替代他进行发言。

AI 合成人声的技术已经十分成熟。一些开放免费测试的主流平台,例如 Resemble AI、Descript ,仅需要你录入 25 句话或 10 分钟录音,就能克隆你的声音——当然,训练集的时长越长,模型就会与你越相像。最低要求呢?3.7 秒就可以。

除了服务基尔默这样的病人,语音克隆还有一大用处,是“复活故人”,不论是去世的亲人,还是已故的名人。不久前,语音合成公司 Play.ht 释出了一集播客,内容是乔布斯与著名播客主播乔·罗根对谈——其中的文本和人声全都是 AI 合成的。

“冒牌货”们在播客里谈笑风生,从头至尾本尊都不用参与其中。这是否会涉及到侵权呢?尤其是已过世者,他们的声音所有权归属于谁呢?任何人都可以使用么?

更棘手的问题是,真假如何分辨呢?

挺好的技术,却被用来行骗?

别说你一定分得出人声与 AI。

2019 年 3 月,英国一家能源公司的员工接到老板电话,要求他在一个小时内转 22 万欧元给匈牙利的一家供应商,电话那头“老板”略带德国口音,和平时老板说话的声音不差分毫,他毫不怀疑立刻照办了,转账后这笔钱很快被转移到墨西哥,难再追回;2020 年,香港的一名银行经理被克隆语音欺骗,向诈骗者批准了一笔 3500 万美金的转账。

这种事情正在变得越来越多, VMware 今年的调查显示,三分之二的受访企业表示过去一年收到的诈骗攻击中存在音频或视频伪造的成分。

当你在电话里听到一个熟悉的声音,大多数人“没有建立起肌肉记忆来真正应对它。”埃森哲安全公司董事总经理丽莎·奥康纳表示。

生理结构上,人类大脑面对假声音时会变得蠢蠢的。

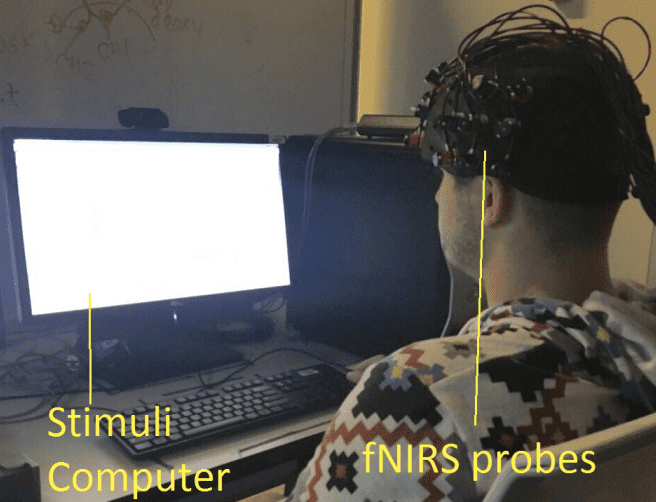

2019 年加州大学河滨分校的一项研究发现,在观看伦勃朗画作的真迹和赝品时,人们的脑部扫描会显现出明显的差异;聆听摩根 · 弗里曼、机器弗里曼和模仿者说话时,却没有同样表现。

“结果表明,人类可能在本质上无法区分真实的和非真实的声音。”

AI 伪造人声无敌了么?

科学家正在试图应对它。

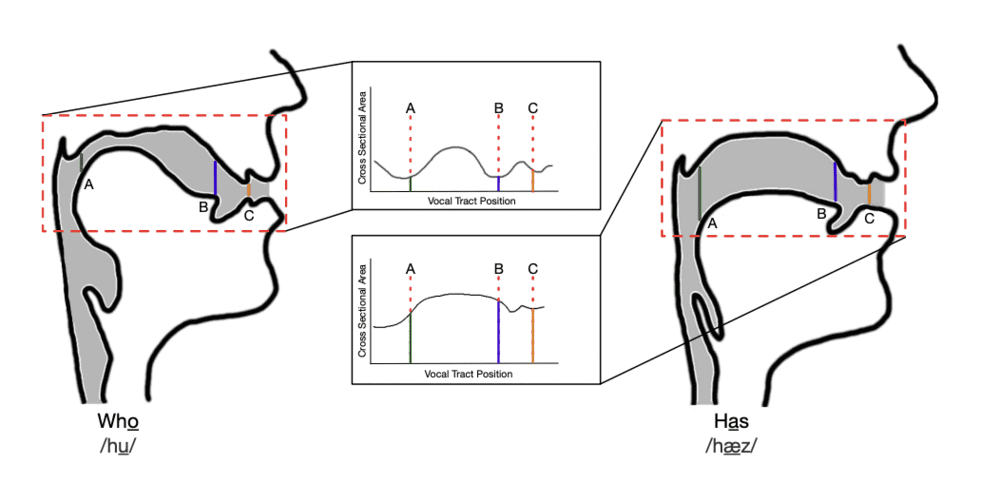

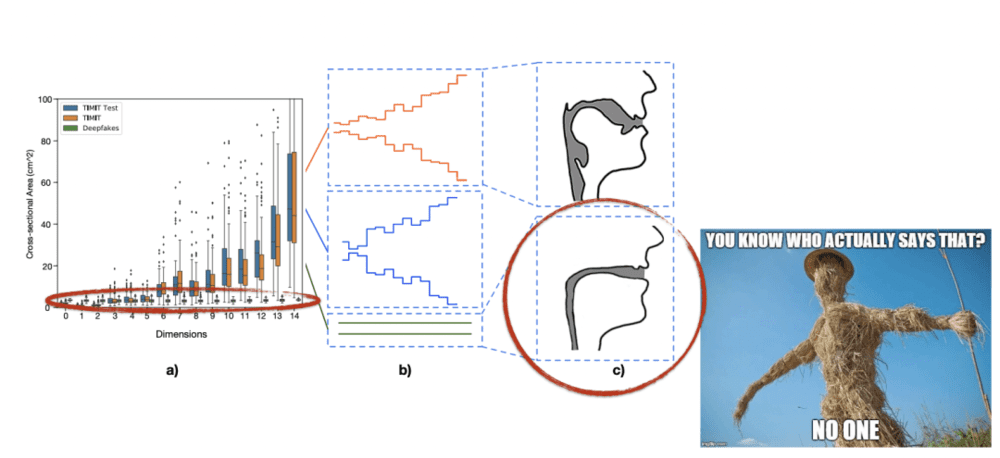

最近的一项研究中,佛罗里达大学的研究者们发现了机器的一个破绽:没有声道。或者说,人类发声方式的局限,在于每一个人的声道结构,而 AI 不具备这样的“局限性”。

数十年来,科学家都试图重现史前生物的声音。猛犸象、恐龙……它们的啸叫、呼喊,听起来会是怎样的?骨骼的形状提供了许多线索,比如副栉龙,它们的头骨中有一个很长的腔,科学家据此来估测它的共振频率。

人类发声也是如此,通过使用声道的各种结构,声带、舌头、嘴唇,协作挤压空气来发出声音并改变声音。使用声学和流体动力学模型,研究者可以倒推出怎样的一个结构发出了这段声音。

通常会像是这样,一个不规则的,有突起和凹陷的通路。

然而,当他们把机器生成的声音放入同样模型时,奇怪的事情就发生了:

机器人声倒推出来声道,就像一根又细又长的吸管,这跟人体的正常结构完全不同。仅凭这样的侧面解剖图,就几乎可以立刻分辨这是人发出的声音,还是机器的。通过这个方法,他们检验了 4966 个音频语段,准确率高达 99.9%。

想象一下,这或许很快会成为一个基础配置,当你接起一通电话,一个附加的插件会同时开始运转,判断对面是真人还是机器合成人声,再向你发出警告。

已经有很多人在为此努力。2019 年,为了对抗克隆语音、假音频,Google 发布了一个合成语音数据库,来推动对假音频检测的研究,里面包含了谷歌深度学习模型所“说”的上千个短语,用 68 种不同的声音覆盖了各式各样的口音,希望以此鼓励外界开发出更多语音鉴真的方案。

没有科学家的工具,我们自己怎么办?

有一些小窍门,但主要靠直觉。

语音认证服务公司 Pindrop 一直在开发合成声音,这个过程中他们也发现了机器的一些缺陷:

不善于处理摩擦音,比如 f,s,v,z ,因为软件很难将它们与噪音区分开来

爱拖长音,算法很难区分单词的末尾和录音中的背景噪音,会出现断句的问题

过于“干净”,像是在录音室里用专业设备录制的,且质量始终如一

Pindrop 也发现了一些异常“聪明”的犯罪分子,为了掩盖这些缺陷,故意放入嘈杂的环境音来干扰对方的判断。有一位他们称之为“鸡人”的诈骗犯,总是在背景中播放公鸡的叫声;还有一位女士会利用婴儿的啼哭声做背景音,试图来博取对方的同情。

因此,当发现对面有持续奇怪的噪声,你就要小心了。

对于涉及重大交易的对话,深度伪造侦测公司 Deeptrace 的主管亨利·阿杰德给出了一个实用建议:考虑使用暗号进行对话,或者在通话开始时提出或回答一个秘密问题。

以当前 AI 的学习速度,相信很快,这些拙劣的破绽就会被逐一击破——曾有一篇论文研究发现,通过人物眨眼的不规律,可以判断视频是否为深度伪造。可仅仅几个月之后,开发者就解决了这个 bug 。

但至少现在,人类仍能通过细枝末节的线索,判断出对方非我同类。比如,在罗根与乔布斯的对谈中,总有诡异的笑声穿插在流利的对话中,“呵呵呵、嘻嘻嘻”,十分突兀,语调也会因此变形。

笑声警告:

这让人想起 Resemble 在语音生成后,会给你一些选项,可以在段落中加入停顿或是“愤怒”、“喜悦”这样的情绪。从反馈来看,模型似乎并尚不能很好地处理情绪。

但终有一天,我们要怀疑一切。

前几天同事小杨接到一个推销电话,开了免提,热火朝天地跟办公室里其他人讨论对方是不是机器人。

突然,电话对面缓缓传来:“对不起,我说话的方式让您误解了。”

“你信这是真人了么?”

他回答:“哼,我才不信,这肯定是 AI 的伎俩。”

参考文献

[1] https://www.ndss-symposium.org/wp-content/uploads/2019/02/ndss2019_08-3_Neupane_paper.pdf

[2] https://theconversation.com/deepfake-audio-has-a-tell-researchers-use-fluid-dynamics-to-spot-artificial-imposter-voices-189104

[3] https://www.nytimes.com/2020/05/06/magazine/val-kilmer.html

[4] https://www.yahoo.com/entertainment/val-kilmer-cancer-treatment-lost-voice-142401511.html

[5] https://www.hellomagazine.com/healthandbeauty/health-and-fitness/20210825120419/val-kilmer-heartbreaking-reveal-cancer-diagnosis/

[6] https://arstechnica.com/information-technology/2022/10/fake-joe-rogan-interviews-fake-steve-jobs-in-an-ai-powered-podcast/

[7] https://www.howtogeek.com/682865/audio-deepfakes-can-anyone-tell-if-they-are-fake/

[8] https://senseient.com/wp-content/uploads/Deepfakes-updated.pdf

[9] https://mitsloan.mit.edu/ideas-made-to-matter/deepfakes-explained

本文来自微信公众号:果壳 (ID:Guokr42),作者:翁垟