本文来自微信公众号:果壳 (ID:Guokr42),作者:Jesse,编辑:沈知涵,题图来自:视觉中国

谷歌搞了个大麻烦。

2021 年 2 月,美国人马克在医生的授意下,用自己的安卓手机,给儿子肿胀疼痛的生殖器拍了几张照片,发给护士,让对方判断病情。之后的诊断和治疗进展顺利,马克的儿子很快没事了。

但麻烦找上马克。那些照片,在同步上传到谷歌相册后,被谷歌的 AI 工具标记为“儿童性侵内容”。很快儿童保护组织介入,开始对事件进行调查,进一步确认了这些照片涉嫌“儿童色情”。

案件被报送给当地警方。一周后,警察敲开了马克的家门。同时谷歌彻底封禁了马克的账户。

犯错的 AI

引发此次乌龙的“罪魁祸首”,是谷歌的图像识别 AI。

利用 AI 来预防、打击儿童犯罪,并不是什么新鲜事。早在 2009 年,微软就曾开发过一个名为 PhotoDNA 的工具,来帮助追溯、阻断儿童色情内容的传播。

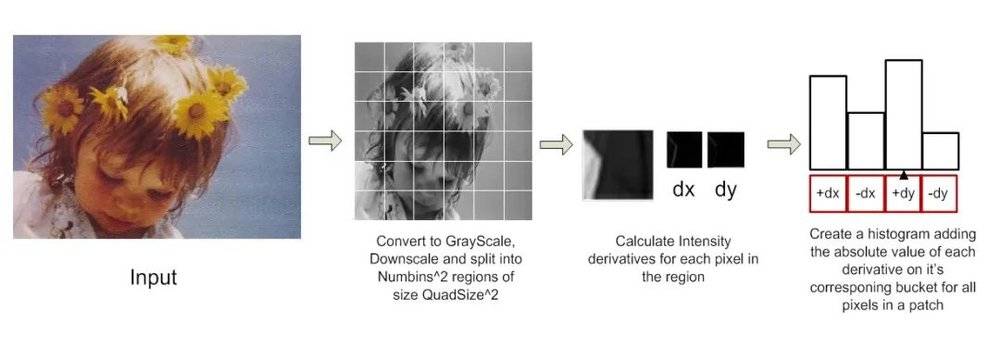

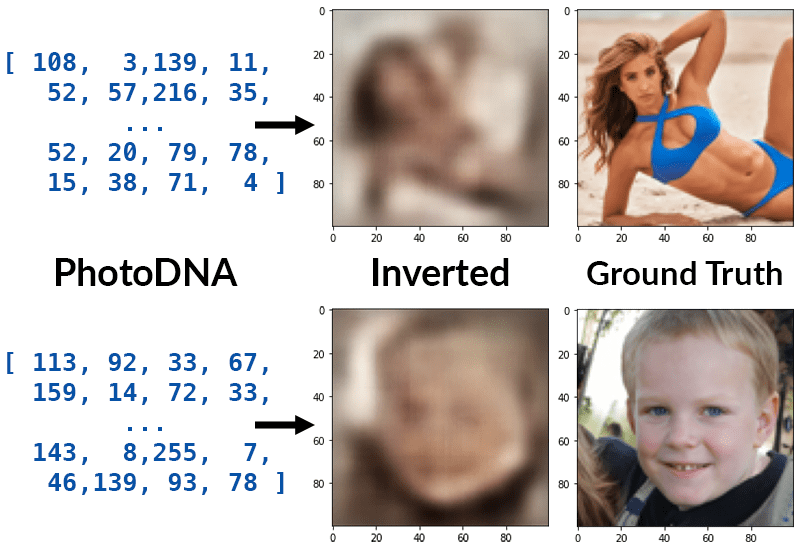

PhotoDNA 的核心原理,是一种名为“鲁棒哈希”(robust hashing)的技术。一般情况下,任何一个计算机文件,经过哈希算法,都只会得出一个唯一的“哈希值”,常被形容为“数据的指纹”。但 PhotoDNA 所采用的算法,可以得到一个更宽泛的哈希结果。

具体到应用层面,PhotoDNA 可以根据已有的一张儿童色情图片,算出一个宽泛的哈希结果。之后,即便这张图片被裁切、编辑,依然会保留原图的一部分特征,对应的哈希结果也能与原图进行匹配。用一个直观一点的类比,就像只通过“半个”指纹的特征,就匹配到原指纹,进而追溯到主人。借此方式,科技公司就可以追溯、阻断此类内容的传播。

在 PhotoDNA 的基础上,谷歌的 AI 工具更进一步,它将已知的儿童性侵内容作为样本,进行了深度学习,不仅能通过“哈希计算”,识别已知的儿童色情内容,还能挖掘出泛化的特征,比如裸露、特定的器官、姿势。谷歌的 AI 能直接识别一切“涉嫌儿童色情、虐待的图像”,即便这个图像是第一次被上传到网络。

2018 年,谷歌推出了这个 AI 工具,还把它提供给了 Facebook 等一系列公司。这项技术被视为一次重大突破,成为打击儿童性犯罪的利器。

美国对儿童性犯罪的打击非常严厉,相关联邦法律规定,公民实体有义务检举儿童性犯罪的相关线索。所以,在谷歌的算法推出之后,公司内部立刻建立起一套“报送机制”,将检测到内容的相关线索,报送到儿童保护机构。

儿童保护机构的工作也因此取得了突破。在此之前,儿童犯罪的线索,大部分依赖“电话举报”,因为儿童犯罪常常发生在私人场所、家庭内部,想要开展调查、取证都非常困难,打击起来也常常会力不从心。

但有了相关的 AI 工具之后,从调查到取证,难度被大大降低。根据美国国家失踪于受虐儿童援助中心的数据,仅在 2021 年,靠着 AI 识别报送的线索,就找到了 4260 名潜在的儿童受害者。

不过,再先进的 AI 也会犯错。无论是技术层面的 bug,还是事实层面的误判。

针对这类“鲁棒哈希算法”,不少技术人员都在尝试“逆向攻破”它们的死角。比如通过逆向算法,生成一张与原图类似,但又有本质不同的图片,输入后会被 AI 识别为与原图的“哈希结果”一致,这就是“AI 的 bug”。

更容易出现的问题,是事实层面的误判。马克事件里,AI 的识别并没有错误(马克拍的照片确实是他用手接触儿子生殖器的特写),但因为不了解事件背景,导致了乌龙发生。

不少观点认为,即便存在偶然的乌龙,也不能否定 AI 工具对打击儿童犯罪的积极意义。但科技公司、儿童保护组织、执法机构,也需要建立一个更灵活的系统,帮助马克这样的无辜者。

如何纠错?

马克很快洗脱了嫌疑。因为案子并不复杂,他向警探提供了当晚和医院医生、护士沟通的记录,证明了“照片是为了孩子求医”之后,警方很快就撤销了调查。

当马克提交相关信息,希望恢复自己的谷歌账号时,却遭到了拒绝。AI 把照片标记为“儿童色情”后,谷歌对账号展开进一步的调查,过程中发现另一段,马克的儿子和妻子,全裸躺在床上的视频。也被判断为“存在儿童侵犯的嫌疑。”

对于类似家庭隐私内容,几乎所有人无法接受它们被放置在某个人工审核员的屏幕上,接受审视。人工审核效率低、成本高,还涉及复杂的隐私问题,科技公司宁愿将“审核”交给AI。

很多科技公司在用人,还是AI上“进退两难”。

2019 年,《卫报》就曾报道,苹果在 Siri 的“改进计划”里,雇佣第三方公司的数据标记员,去听用户语音指令的“原声”。这项工作原本是针对 Siri 无法识别语音指令的情况,让真人去听过之后,补充、修正语音识别数据库的“样本”。但在这些“指令原声”中,包含了很多误触发 Siri 之后的用户录音,涉及大量隐私信息,比如商业交易、医疗沟通,甚至是犯罪和性行为。事件爆出后,苹果很快叫停了相关项目。

去年秋天,苹果也准备为 iCloud 照片系统部署一个与 PhotoDNA 类似的“哈希检测算法”。但因为隐私团体的反对,计划被无限期搁置。

马克的乌龙,任何一个“人”听了,都不难理解他是无辜的,所以警方很快就还了他清白。但对科技公司来说,很多时候,让“人”去介入这些事情,不仅高成本低效率,还牵扯道德、隐私和伦理。

在复杂的现实世界里,人需要 AI 的帮助,AI 也需要人的纠错。但两者到底如何合作,依然是一道难题。

互相负责

账号被封对于马克来说就是灾难。

他曾是忠实的谷歌全家桶用户,被封后,邮箱、Google Fi 手机号都不能用了,几乎与外界“断连”,多年以来的邮件、相册、日历数据也全都无法取回。

马克曾想过到法院起诉谷歌,但在咨询律师之后,他发现相关的起诉费、律师费需要约 7000 美元,还不能保证胜诉。考虑之后,他放弃了这个计划。

马克的遭遇并非个例。《纽约时报》报道马克遭遇的同时,还发现了另一名“受害者”卡西奥,他的遭遇和马克近乎一致,也是因为拍摄儿子的私密部位,发给家庭医生咨询病情,账号遭到封禁。

每年数十万的相关报告中,可能存在几百上千个类似的“误伤”。AI 可以识别出儿童的私密部位,但很难识别出这到底是“性侵的前奏”还是“父母帮孩子洗澡”。

比起恢复一个账号,谷歌更难做的是从“公共道德”角度重新审视这些内容。因此,它直接把问题丢给 AI,AI 采取对于儿童裸露“零容忍”的政策。直到这次事件被媒体报道,谷歌仍坚持自己的做法:不会给报道中涉及的两名无辜父亲解封。

无论是学界还是技术界,在评价这一事件时,人们几乎无一例外地肯定了 AI 工具在打击儿童犯罪方面起到的作用,同时也都认为 AI 需要一套纠错机制。

这个问题绝非无解,事情的关键依然在于各方(尤其大公司)如何主动负起责任,而不是过度依赖技术工具。

人和 AI,最终需要互相负责。

本文来自微信公众号:果壳 (ID:Guokr42),作者:Jesse,编辑:沈知涵