8月10日下午,宁波一处高架桥上,一辆小鹏P7电动车以80km/h时速撞上一辆在路边临时停靠的故障车辆。道路监控和行车记录仪视频显示,肇事车在接近故障车辆时几乎没有减速和转向,径直撞向前方,导致前车尾部严重损毁、站在车尾后方的人员不幸身亡。

肇事车主王先生对红星新闻表示,事发时他正使用电动车的LCC(车道居中辅助)功能,但该功能没能识别前方的人和车,在撞击发生前没有任何警告,而自己因为在辅助驾驶状态下跑神没有做出应对,最终酿成车祸。

8月11日,小鹏汽车官方对此事故作出了回应,称交警部门已经立案处理,小鹏也将全力配合相关部门进行事故调查,持续跟进后续结果。

这场悲剧并非毫无预告,同样的事件已经发生过预演。

今年3月13日,小鹏P7车主邓先生在湖南临湘-岳阳高速路段上发生严重车祸,车祸时同样开启着LCC功能、同样是80km/h速度巡航,同样是撞上前方侧翻的静止车辆。邓先生在社交媒体上称:“撞击前车辆毫无减速,碰撞预警提示或者紧急制动的迹象……我认为辅助驾驶功能存在致命的安全隐患。”

车祸频发,车主们还能放心把性命攸关的大事交给辅助驾驶系统吗?

LCC模式能解放车主吗?

这次事故的争议核心LCC(车道居中辅助),是一个能帮助车辆在车道正中间行驶的功能。在有清晰车道线的道路上,如果车辆偏离车道中心,系统会自动施加转向辅助力使车辆回正以保证行车安全。驾驶员开始变道时,系统会自动退出以避免干预驾驶员的操作。

在LCC开启时,车外摄像头会检测车道线,使车辆维持设定时速在车道中央行驶,同时,摄像头和毫米波雷达会判断前方车辆的远近,自动保持安全距离。

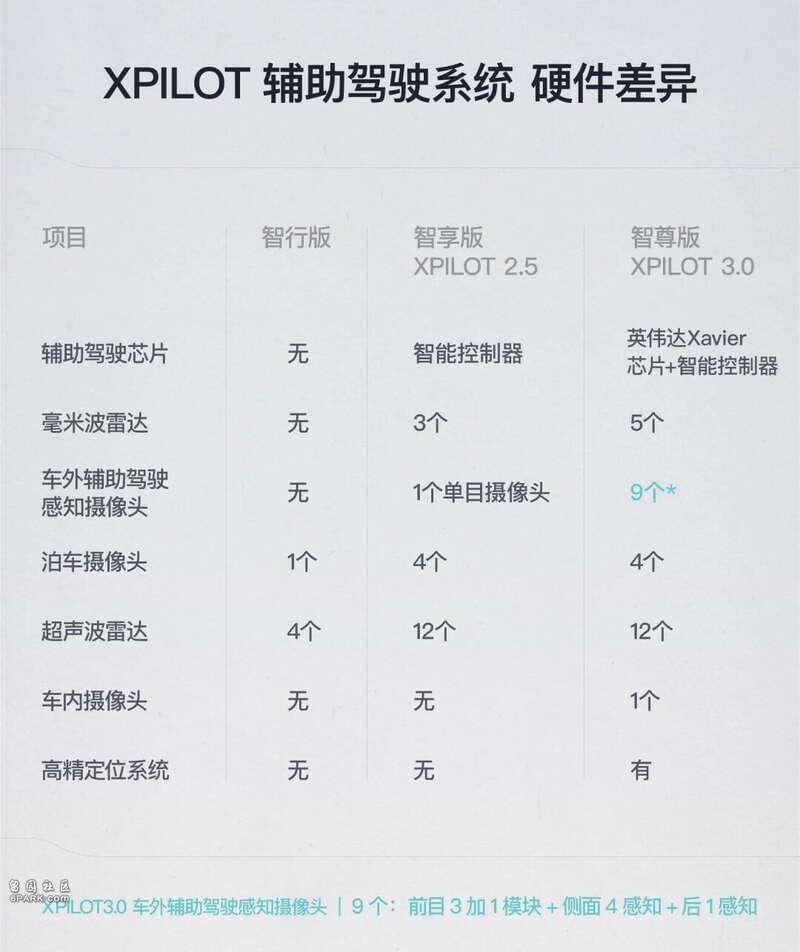

根据官网介绍,小鹏目前最高配的辅助驾驶系统XPILOT 3.0使用了英伟达Xavier芯片+智能控制器的双组合,高精毫米波雷达5个,车外有13个摄像头,车内也有一个摄像头,全车共计14个摄像头。

XPILOT不同版本的硬件配置差异|小鹏官网

但就算是最高配的XPILOT 3.0 系统也有致命短板。

摄像头+毫米波雷达的组合对非标准静态物体的识别存在困难,在高速场景下尤其明显。因为静止物的反射波没有相位差,静态目标的信息很容易和附近的干扰目标信号掺杂在一起,导致雷达无法准确地识别。同时,“静态杂波滤除”的算法,也会过滤掉一些静止物体。这就可能会导致前方的静止车辆和行人被误判或忽略。

毫米波雷达工作示意图

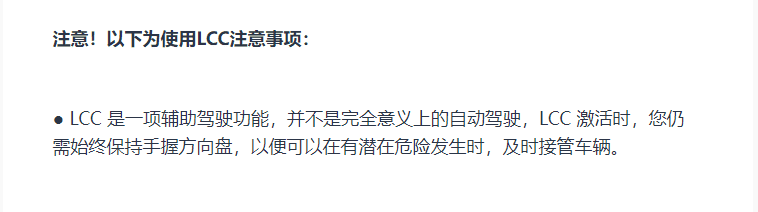

在LCC的各种介绍中,小鹏汽车都标注了“车道居中辅助(LCC)启用时,驾驶员仍需始终保持手握方向盘并在必要时接管方向盘”、“LCC 激活时,您仍需始终保持手握方向盘,以便可以在有潜在危险发生时,及时接管车辆”等警示。

XPILOT小助手的LCC介绍文章 | 小鹏社区

辅助驾驶失灵,车主负责

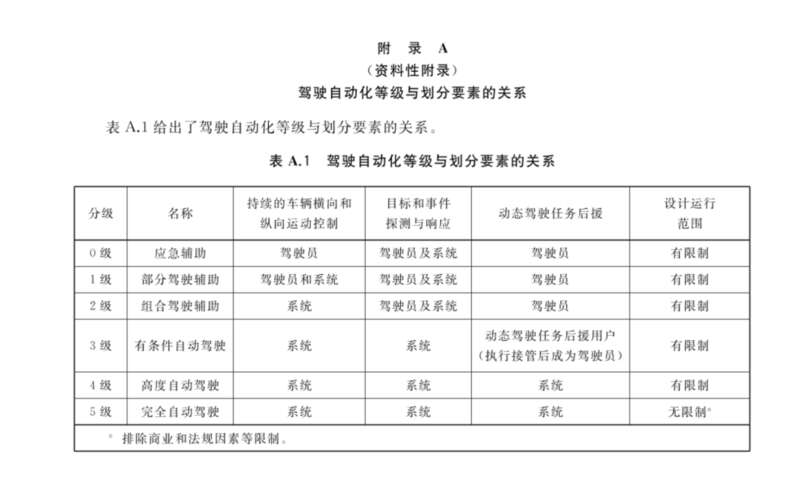

根据美国高速公路安全管理局(NHTSA)和美国汽车工程师学会(SAE)提出的自动驾驶分级制度,自动驾驶被分为L0、L1、L2、L3、L4、L5五个等级,L0-L2属于辅助驾驶,L4-L5属于无需接管的自动驾驶,而L3级别的自动驾驶,车主需要在功能请求时接管汽车。

SAE自动驾驶等级 | SAE

今年3月,国家市场监督管理总局、中国国家标准化管理委员会也推出了适用于我国的《汽车驾驶自动化分级》国家推荐标准。

《汽车驾驶自动化分级》|国家标准委

车企认为,在辅助驾驶模式下出现事故,责任在车主一方。

小鹏在用户手册中不断强调,车主不能依赖ACC/LCC系统,需要随时准备好做出人工干预,并列举了各种系统可能失灵的场景,其中就包括无法检测到静止车辆和物体。就算在事故发生时辅助驾驶系统失灵,但因为用户手册已经强调过了车主双手不得离开方向盘,需要随时注意接管汽车,因此车主仍需负主要责任。

小鹏用户手册 | xiaopeng.com

从法律法规执行的角度来讲,在国内的交通事故认定中,辅助驾驶汽车的责任主体也都是驾驶员。

8月1日,《深圳经济特区智能网联汽车管理条例》(简称《条例》)实施,《条例》中定义的“智能网联汽车”包括了有条件自动驾驶(即L0-L2)、高度自动驾驶和完全自动驾驶3种类型,也因此被视为国内首部L3级的法规。

《条例》规定:配备驾驶人的智能网联汽车发生交通违法行为,由公安机关交通管理部门依法对驾驶人进行处罚;发生交通事故且智能网联汽车一方负有责任的,该车辆的驾驶人应当承担相应的损害赔偿责任;因智能网联汽车质量缺陷造成交通事故的,驾驶人依法承担损害赔偿责任后,可以向智能网联汽车的生产者、销售者追偿。

也就是说,依据现行法律,因辅助驾驶功能失灵造成的交通事故,驾驶人虽然承担责任,但可以向车企追偿。

虽然根据用户手册说明,小鹏P7的辅助驾驶系统属于L2级别,但在百度搜索“小鹏P7 L3”,查询8月9日(车祸发生前一天)前的搜索结果,会发现网上有很多宣传小鹏P7拥有L3级自动驾驶的文章,消费者很可能会因此而过分信任汽车的辅助驾驶功能,从而在驾驶时掉以轻心。

普通车主来说,很难分辨到底什么才是真正的L3 | 百度截图

2016年6月,40 岁的美国司机约书亚·布朗(Joshua Brown)在将特斯拉Model S置于Autopilot(自动辅助驾驶)模式中行驶时,因传感器无法识别前方明亮天空下的白色货车而撞车身亡。约书亚成为了第一个死于自动驾驶车祸的人。

约书亚生前的社交网站照片 | Facebook

特斯拉随后发布的事件声明强调了Autopilot功能并不完美,依然需要车主随时接管,撇清了公司的责任:Autopilot“是一项辅助功能,要求你的手始终放在方向盘上”,并且在使用时 “你需要保持对车辆的控制和责任”。

2019 年底,美国司机凯文·里亚德(Kevin George Aziz Riad)驾驶的特斯拉Model S在Autopilot模式中冲出加州高速公路,闯红灯,撞上另一辆车,造成车内两人死亡。今年1月,洛杉矶县检察官对现年 27 岁的里亚德提出了“过失杀人罪”和“交通肇事杀人罪”指控。此案也是对涉及特斯拉Autopilot功能车祸的首次刑事起诉,而特斯拉在需要定责时不见踪影。

我们离“真正的自动”还很远

从自动驾驶概念出现之初的L5大饼到L2的现实,从一开始的高歌猛进,到如今声量越来越小,“自动驾驶”的宣传也悄悄改口成了“辅助驾驶”。这都是因为L3的分水岭会让车企承担更多的追责风险。

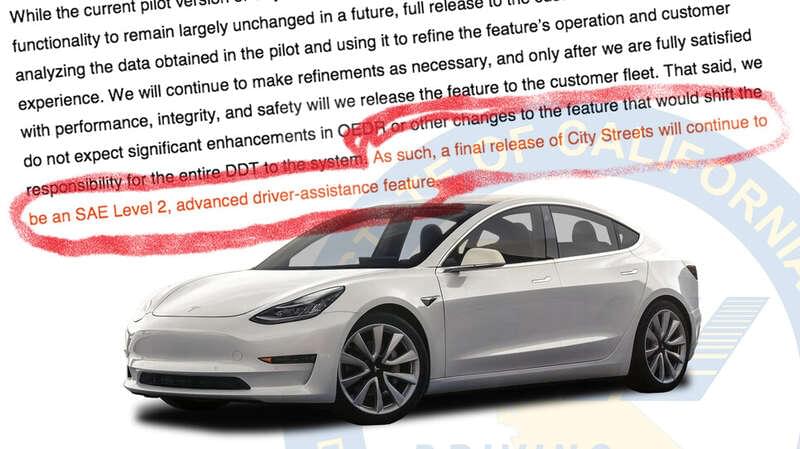

作为自动驾驶的先驱,特斯拉首当其冲。根据 CNBC 8月5日的报道,加州机动车辆管理局正在指控特斯拉在自动驾驶方面存在虚假宣传。加州车管局认为,特斯拉把辅助驾驶系统称作Autopilot(字面意义是自动驾驶)和FSD(全自动驾驶系统的简称),将这些系统宣传为“全自动”,属于一种夸大宣传。特斯拉有两个星期的时间来回应调查,否则可能暂时失去在加州的经营许可。

特斯拉与加州车管局此前曝光的邮件|DMV

这个口径上的拉锯过程,也是人类在是否要把控制权交给机器这件事上的徘徊。

如果一棵小树枝探出了公路,而且没有来往的车辆,我们会简单地变到对面车道绕行。但是自动驾驶汽车可能会完全停下来,因为它尽职尽责地遵守了禁止跨越双黄线的交通法规。这种意外的举动会避免撞到前面的物体,但会与后面的人类司机发生碰撞。

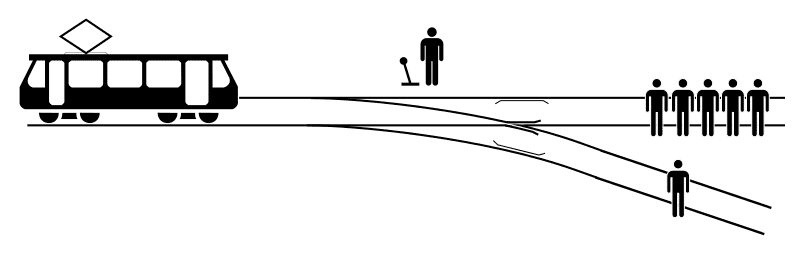

又比如经典的电车问题:一辆失控的电车即将碾过并杀死站在铁轨上的五个人,你可以拉动开关,让电车进入另一条只有一人的轨道,牺牲一人拯救五人。或者扔掉开关,任五人死亡。人类尚且无法判断的伦理难题,自动驾驶系统又会如何抉择?

电车难题

2004年上映,根据阿西莫夫同名小说改编的电影《我,机器人》中,威尔·史密斯饰演的男主斯普纳十分厌恶人工智能机器人,因为在他几年前经历的一场车祸中,前来救助的机器人因存活率太低为由放弃了了另一个12岁女孩,选择营救斯普纳。在性命攸关的情况下,自动驾驶汽车面临的考验恐怕只会更大。

《我,机器人》剧照

人们也可能认为,在车祸中,由自己以外的人控制自己的命运是有违伦理。工程师们根据自己的道德规范和观念开发自动驾驶的算法技术,而他们的决定影响着司机、乘客和路人的生命。政策制定者和政府也试图为自动驾驶汽车制定规则和条例,增加了对司机、乘客和路人的额外影响。

德国则试图用事先设定指导方针来解决自动驾驶汽车的伦理问题。德国政府提出,“自驾车应该总是试图将人的死亡降到最低,不应该根据年龄、性别或任何因素对个人进行歧视。人的生命也应始终优先于动物或财产”。从《科学》杂志发表的一项研究来看,超过75%的参与者支持这种实用主义的做法。

在技术与伦理问题上,我们或许还要很久才能放心地将控制权全部交给机器,获得真正的自动驾驶车辆。希望在这条发展的道路上,悲剧会越来越少。