本文来自微信公众号:数据实战派(ID:gh_ff93f845912e),作者:Neil C. Thompson(麻省理工学院学者), Svenja Spanuth(瑞士苏黎世联邦理工学院博士研究生),译者:LZM,原文标题:《麻省理工学院学者万字长文:计算机作为一种通用技术的衰落》,头图来自:unsplash

也许没有一种其他技术能像计算机技术一样,在过去几十年里有如此巨大的进步。据估计,自 1974 年以来,美国总生产力增长的三分之一来自信息技术,它是国家繁荣的最大贡献者之一。

关键点

揭示处理器发展规律的摩尔定律由两股力量推进,科技进步和通用技术的经济周期规律。后者简称 GPT(general purpose technology),受到市场增长和技术投资的相互作用左右。二者相互刺激,产生了强烈的经济动力,促使用户对快速改进的 CPU 进行标准化,而不是发展专用处理器。

今天,促进通用技术发展的两股力量逐渐解开纠缠,导致市场增长和技术进步放缓。

随着 CPU 技术发展减速,经济动机将推动用户转向专用处理器。在这样的计算环境中,一些用户将走在快车道上,从定制的硬件中受益,而另一些用户将留在慢车道上,受困于更新缓慢的 CPU。

计算机的兴起一部分是由于技术上的成功,另一部分是由于资助它们的经济力量。Bresnahan 和 Trajtenberg 创造了 “通用技术”(general purpose technology, GPT)这一术语,指的是具有广泛技术适用性,且产品改进和市场增长会相互推动的技术,如计算机技术。但是,他们也预测,GPT 在其生命周期结束时可能会遇到挑战:随着通用技术发展放缓,其他技术可能会在特定的利基领域取代通用技术,并破坏这种经济强化周期。我们今天正在观察这样的转变:中央处理器(CPU)发展缓慢,因此应用程序转而求助于专用处理器,例如图形处理单元(GPU)。专用处理器比传统的通用处理器提供更少种类的功能,但能更好地执行某些特定功能。许多应用已经在追随这一趋势,包括深度学习(机器学习的一种形式)和比特币挖矿。

在此背景下,我们可以更精确地给出这一论点:“计算机作为一种通用技术正在衰落。” 我们并不是说计算机技术将失去其自身的科技能力,“忘记” 如何做计算。我们的意思是,以快速迭代的通用处理器支撑的通用计算平台为主体的经济周期,正在让位于一个分裂周期。在这个周期中,经济效益将把用户推向由专用处理器驱动的不同计算平台。

这种分裂意味着不同的计算将以不同的速度发展。对于那些进入 “快车道” 的应用来说,这并没什么问题。快车道上的改进将继续保持快速,但对于那些不再从推动计算技术进步的领导者那里获得好处、因此不得不留在计算技术改进 “慢车道” 的应用和市场来说,情况就不妙了。这种转变也可能减缓计算机发展的整体速度,危及这一经济繁荣的重要来源。

通用计算和专用计算

早期 —— 从专门化到通用化。早期的电子技术产品,并非可执行多种不同计算任务的通用计算机,而是有专门用途的设备,如收音机和电视机。这些设备被设计用来完成某一项任务,而且只能完成这一项任务。这种专门化有如下优点:设计复杂且易于管理,处理器效率高,工作速度快,耗电量少。但与之对应的,专用处理器也 “更窄”,只能被很少一些上层应用所使用。

早期的电子计算机实际上都是为特定算法量身定制的,很难适应其他算法,即使是那些为 “通用” 目的而设计的计算机。例如,1946 年的 ENIAC 在理论上是一台通用计算机,但它主要用于计算火炮射程表。如果需要稍微不同的计算,计算机将不得不手动重新连接,采用新的硬件设计。解决这一问题的关键是一种能够存储指令的新型计算机架构。这种架构使计算机更加灵活,使它能够在通用硬件上执行许多不同的算法,而不是在专门的硬件上才能工作。这种 “冯・诺伊曼架构”(von Neumann architecture)十分成功,以至于它仍然是当今几乎所有通用处理器的设计基础。

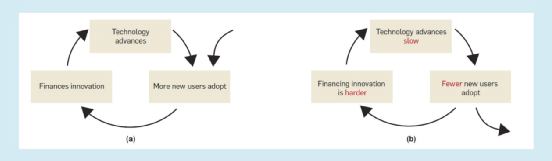

通用处理器的崛起。许多技术,当它们被引入市场时,大多都经历了一个良性的强化循环,帮助它们发展(图 1a)。早期使用者购买产品,然后获得投资,使产品更好。随着产品的改进,更多的消费者购买它,从而为下一轮的发展提供资金,依次类推。对于许多产品来说,随着产品改进变得过于困难或市场增长停滞,这个周期会在中短期内逐渐结束。

通用技术的定义包括它在发展过程中持续受益于这一良性经济周期的能力 —— 就像通用处理器几十年来所经历的那样。这个市场已经从军事、太空等领域的一些高价值应用发展到全球使用的 20 多亿台个人电脑。这种市场增长推动了对改进处理器的更大投资。例如,在过去的十年里,英特尔已经在研发和制造设施上花费了 1830 亿美元。这带来了巨大的回报:据估计,自 1971 年以来,处理器的性能提高了约 400,000 倍。

另一种选择:专用处理器。通用处理器必须能够很好地进行许多不同类型的计算。这导致设计上需要妥协,许多计算速度较快,但做不到最优化。对于适合专门化的应用来说,这种折衷带来的性能损失是很高的,比如:

大量可并行的计算

稳定的计算

需要内存访问的范围和次数较少的计算

不需要高精度的计算

在这些情况下,专用处理器(例如,专用于应用的集成电路ASIC)或异构芯片的专用部件(例如,I.P. 块)可以执行得更好,因为它们可以通过定制以适应这些计算。

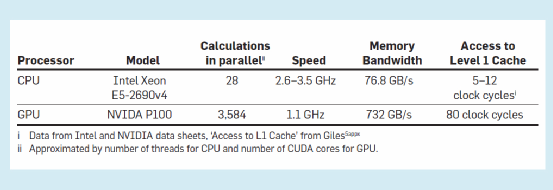

专门化导致处理器设计变化的程度,可以从典型 CPU(占主导地位的通用处理器)和典型 GPU(最常见的专门化处理器类型)的比较中看出。

GPU 运行速度较慢,频率大约是 CPU 的三分之一。但在每个 clock 周期中,它可以并行执行比 CPU 多 100 倍的计算。这使得在具有大量并行度的任务中,GPU 比 CPU 要快得多,但是对于那些并行度很低的任务,它要慢得多。

GPU 通常有 5~10 倍的内存带宽(决定一次可以移动多少数据),但是在访问数据时有更长的延迟(最近的内存仍需至少 6 倍的 clock 周期)。这使得 GPU 在可预测的计算(从内存中需要的数据可以在正确的时间被带到处理器中)方面做得更好,而在不可预测的计算方面做得更差。

对于与专用硬件匹配良好的应用程序[并且可以使用编程模型(例如 CUDA)来利用该硬件],性能上的提高是相当可观的。例如,在 2017 年,据 GPU 的领先制造商英伟达(NVIDIA)估计,深度学习(AlexNet with Caffe)在 GPU 上的运行速率可以达到 CPU 的 35 倍以上。

专用处理器的另一个重要好处是,它们使用更少的电力来进行相同的计算。这对于受电池寿命限制的应用程序(手机、物联网设备),以及那些进行大规模计算的应用程序(云计算 / 数据中心、超级计算)尤其有价值。

截至 2019 年,功率效率最高的 10 台超级计算机中有 9 台使用的是英伟达的 GPU。

专用处理器也有严重的缺点:它们只能运行有限范围的程序,很难编程,通常需要运行操作系统的通用处理器来控制它们。设计和制造专门的硬件也很昂贵。对于通用处理器,它们的固定成本(也称为非经常性工程成本,NRE)可以均摊到大量的芯片上。相比之下,专用处理器通常只拥有更小的市场,因此每个芯片的固定成本更高。更具体地说,使用尖端技术生产带有特殊处理器的芯片的总成本约为 8000 万美元(截至 2018 年)。使用老一代的技术可以将成本降低到 3000 万美元左右。

尽管专用处理器有很多优点,但是它们的缺点也很成问题,以至于在过去的几十年里很少有人采用它们(GPU 除外)。只有在性能提升非常有价值的领域,像军事应用、游戏和加密货币挖掘,专用处理器确实得到了应用。而这种情况正在开始改变,专用处理器的应用越来越为广泛。

专用处理器的现状。所有主要的计算平台,PC、移动端、物联网(IoT)和云 / 超级计算机,都变得越来越专业化。其中,个人电脑仍然是最通用的。相比之下,由于电池寿命的关系,能源效率在移动端和物联网领域更为重要。因此,智能手机芯片上的大部分电路和传感器,如 RFID 标签,都使用专门的处理器。

云 / 超级计算机也变得更加专业化。例如,2018 年,全球最快的 500 台超级计算机中新增的超级计算机,其专用处理器的性能首次超过了通用处理器。

国际半导体技术路线(International Technology Roadmap for Semiconductors,ITRS), 作为协调了维持摩尔定律所需技术发展的重要组织,在 2015 年的执行报告中也暗示了这种向专用化转变的趋势。他们承认,传统的 “一刀切” 的缩小晶体管方法不应再被确定为设计要求,而应针对特定的应用量身定制专用处理器。

在下一部分里,我们将探讨所有主要计算平台向专用处理器的转变,以及这一过程将对生产通用处理器产生的经济学方面的影响。

通用技术的碎片化

支持通用技术的良性循环,来自相互加强的一系列科学技术和经济力量。不幸的是,这种相互加强也适用于相反的方向:如果在周期的某个部分中改进变慢,则在周期的其他部分中改进也会变慢。我们将此称为 “分裂周期”,因为它有可能将计算碎片化为一组松散相关的筒仓,这些筒仓以不同的速度前进。

如图 1(b)所示,分裂周期分为三个部分:

技术进步缓慢

更少的新用户

为创新筹集资金更加困难

这个周期背后的直觉很简单:如果技术进步缓慢,那么采用的新用户的人数就会减少。但是,如果没有这些用户提供的市场增长,则改进该技术所需的不断上升的成本可能变得令人望而却步,从而减缓了技术进步。因此,该协同反应的每个部分进一步增强了碎片化。

在这里,我们描述了计算技术循环周期的这三个组成部分中每个部分的状态,并表明分裂已经开始。

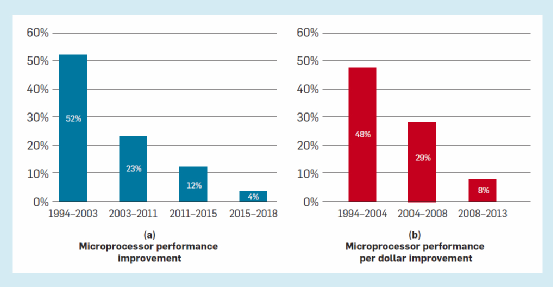

科学技术进步缓慢。为了衡量处理器的升级改进速度,我们考虑两个关键指标:性能和每美元性能。从历史上看,这两个指标均在迅速提高,这主要得益于晶体管的小型化使得每个芯片的晶体管密度更高(摩尔定律)并且晶体管开关速度(通过 Dennard Scaling)也变得更快。不幸的是,由于技术原因,Dennard Scaling 于 2004/2005 年结束,而现在,摩尔定律也即将终结。这是由于制造商达到了现有的材料和设计的物理极限,而突破这些极限将需要付出大量的努力。在经济放缓过程中,我们可以明显地看到性能提升和每美元性能提升都有所放缓。

基于 Hennessy 和 Patterson 对 SPECInt 进度的描述(见图 2.a)以及基于美国劳工统计局生产者价格指数(图 2.b),显示了通用计算机性能提升的显著放缓。我们需要正确地看待这些比率,如果每美元的性能每年以 48%的速度提高,那么在 10 年内,其性能将提高 50 倍。相比之下,如果每年仅以 8%的速度提高,那么在 10 年内,它只会提高 2 倍。

更少的新用户。随着通用处理器的改进步伐放慢,开发人员将创建更少的具有新功能的应用程序,因此客户将失去更换其计算机设备的动力。英特尔首席执行官克赞尼希(Krzanich)在 2016 年证实了这一点,他说,PC 的更换率已从每四年一次逐步增加到现在的每 5~6 年一次。有时,客户甚至跳过了多代处理器的改进,直到真的值得更新自己的电脑。在其他平台方面,美国的智能手机在 2014 年平均每 23 个月进行一次升级;但到 2018 年时,这一时间延长至 31 个月。

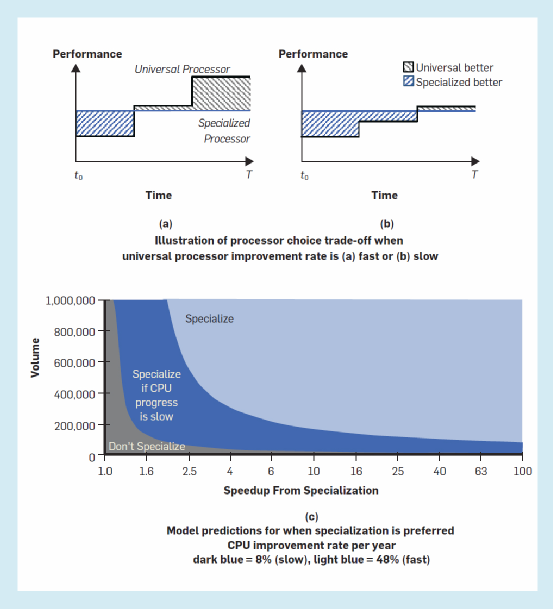

用户从通用处理器向专用处理器的迁移,是我们关于计算碎片化的论点的核心。因此我们将对其进行详细地讨论。考虑一个既可以使用通用处理器也可以使用专用处理器的用户,同时他也是一个希望以最低成本获得最佳性能的用户。图 3(a)和 3(b)给出了我们进行分析所需要的直观信息。每个面板均显示了通用处理器和专用处理器随时间的性能变化曲线。图 a 假设通用处理器的改进速度较快,而图 b 假设通用处理器的改进速度较慢。在所有情况下,我们假设到时间 T,专用处理器的较高价格与对通用处理器进行一系列改进的成本所平衡。这意味着两条曲线是成本均衡的,那么更好的性能同时意味着更卓越的每美元性能。这也是为什么在这两张图中,我们把专用处理器的性能描述成了恒定的。(当专用处理器得到了更新,它也同样会受益于我们刚刚所描述的通用处理器受益于改进的过程。那么用户将重复相同的决策过程)。

如果专用处理器可以提供更强大的性能初始收益,那么它将会更具吸引力。但是,如果通用处理器的改进从(a)中快速发展模式到(b)中的较慢发展模式,它也会变得更具吸引力。我们通过考虑两条时间路径中的哪一条可带来更多收益,来对此进行正式的建模。也就是说,专用处理器会更有吸引力,如果

其中,通用处理器和专用处理器在时间 T 上可提供性能分别为 Pu 和 Ps,通用处理器的改进速率记为 r。我们在在线附录(https://doi.org/10.1145/3430936)中展示了该模型的完整推导过程。该推导使我们能够从数字上估算专用处理器需要提供多少优势,才能得以抵消更高的成本(图 3(c)所示,CPU 的年改进率从每年 48%降低到每年 8%)。

专用处理器在提供更大的加速比或将其成本摊销到更大的数量时,对消费者们更具吸引力。但是,基于通用处理器改进的步伐,当专业化变得更有吸引力时,这些临界值将发生变化。重要的是,这种变化其实是不会出现的,因为我们假设总体上专用处理器与通用处理器之间的改进速率有所不同,即假定所有处理器都能够使用当前最先进的制造技术。相反地,它的出现是因为必须分摊较高的专用处理器的每单位 NRE,以及在此期间与升级通用处理器相比带来多少好处。

数值示例清楚地表明了这一变化的重要性。在摩尔定律的顶峰时期,当时每年的改进速度为 48%,即使专用处理器的速度比通用处理器快 100 倍,也需要至少 83000 个专用处理器的体量才能使投资获得回报。考虑另一个极端,如果性能收益仅为 2 倍,则需要约 100 万的产量才能使专用处理器变得有吸引力。这些结果清楚地说明了为什么在摩尔定律的鼎盛时期,专用处理器厂商很难进入市场。

然而,如果我们使用 8%(20082013 年的增长率)增长率重新计算处理器的选择问题,则最终结果将发生显著的变化:对于提速 100 倍的应用程序,所需的处理器数量从 83,000 降至 15,000;对于那些提速 2 倍的应用程序,所需的处理器数量从 1,000,000 下降到 81,000。因此,在通用处理器的发展速度变慢之后,更多的应用程序就有机会开始其专用化处理器的研发进程了。

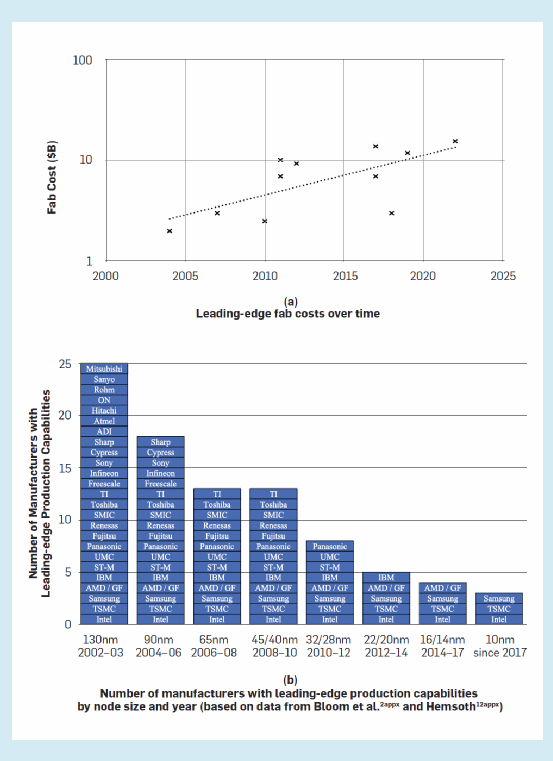

为创新筹集资金更加困难。2017 年,根据半导体行业协会的估计,为下一代芯片建造和配备制造设施(“fab”)付出的总成本约为 70 亿美元。“下一代” 是指芯片的下一个小型化组件(即 “process node”)。

投资于芯片制造设施的成本必须由它们产生的收入来补偿。2016 年,该行业 3430 亿美元的年收入中,多达 30%来自尖端芯片。因此,尽管收入是可观的,但是成本也在增长。在过去的 25 年中,建造领先的晶圆厂(如图 4a 所示)的投资每年以 11%的速度增长,这其中的主要推动因素是极高的光刻成本。将过程开发成本包括在此估算中,则进一步将成本增长率将提高到每年 13%(由 Santhanam 等根据 2001 至 2014 年间的数据测算)。这些事实都导向了芯片制造商间广为流传的 “摩尔第二定律”,即:芯片厂的成本每四年翻一番。

从历史上看,如此快速的固定成本增长对单位成本的影响,只能部分被强劲的整体半导体市场增长所抵消(1996~2016 年的复合增长率为 5%),这使半导体制造商能够依靠更大的体量摊销固定成本。固定成本每年增长 13%与市场每年增长 5%之间的巨大缺口,预计将导致竞争力较弱的参与者退出市场,而其余参与者则通过继续增大体量来摊销其固定成本。

如图 4(b)所示,行业中确实存在着巨大的整合,生产领先芯片的公司越来越少。从 2002/2003 年到 2014/2015/2016 年,拥有领先晶圆厂的半导体制造商数量已从 25 家减少到只有 4 家,他们分别是:英特尔,台积电(TSMC),三星和 GlobalFoundries。GlobalFoundries 最近宣布,他们不会继续开发下一代通用处理器芯片。

我们发现,这种不正常的产业合并很有可能是由于固定成本快速上升且市场规模有限增长带来的经济恶化所致。通过一些更详细的计算,我们可以看出市场整合在多大程度上改善了这些经济性。如果将市场平均分配给不同公司,则意味着平均市场份额将从 2002/2003 年的 4% 增长到 2014/2015/2016 年的 25%。以年复合增长率表示,这个数字将是 14%。这意味着,生产商可以通过市场增长并占据现有工厂的市场份额(13%<5%+ 14%)来弥补晶圆厂建设方面日益恶化的经济状况。

在实践中,市场不是平均分配的,英特尔占有主导地位。因此,英特尔将无法通过这种方式抵消固定成本的增长。实际上,在过去十年中,英特尔固定成本与其可变成本的比率已从 60%上升到 100%以上。考虑到英特尔近年来已经放慢了发布新处理器的步伐,那么他们其实已经减缓了继续投资固定资产的节奏,这个比率的增长更令人震惊。

市场整合抵消固定成本增长的能力只能持续一段时间。我们根据当前的趋势预测未来的发展,预计到 2026 年至 2032 年(取决于市场增长率),领先的半导体制造将只能支持单个垄断制造商,并且为每款芯片建立一个新设施的年固定成本将等于年度行业收入。我们提出这一点并不是因为它在二十一世纪 20 年代末会变成现实,而是要强调当前的趋势不能再继续下去,否则仅在大约 10 年内,制造商们就将被迫大大放慢新技术和芯片的发布速度,并被迫寻找其他控制成本的方法。这两方面的压力都会进一步减缓通用处理器的研发速度。

分裂周期。在碎片化周期循环的三个部分中,每个部分都在相互加强的情况下,我们会看到越来越多的用户将发现通用处理器更新甚微而因此转向到专用处理器。对于那些有足够需求和非常适合专用处理器(例如深度学习)的计算来说,这将意味着专用处理器能够带来显著改善。对于其他人来说,专用化将不是他们的选择。他们将留在通用处理器上,然而通用处理器却发展地越来越慢。

深入理解 / 延伸

谁会使用专用处理器?如图 3(c)所示,专用处理器技术将被那些从变革中获得大幅度提速的任务处理器所采用,并且需要足够的处理器需求量来平衡固定成本。根据以上这些标准,大型科技公司摇身变为最早投入研究专用处理器芯片的公司并不奇怪,例如 Google、Microsoft、Baidu 和 Alibaba。与已经被广泛应用使用的 GPU 不同的是,我们所说的专业处理器是在一些更专业的领域中,因为只需要少量的处理器就可以使收益具有足够的吸引力。

我们还期望那些原本不是专用处理器的硬件设计者,能像深度学习使用者利用 GPU 一样,重新为专用处理器设计新算法,充分利用新的硬件。

预计小型化的最终好处将是价格溢价,并且仅可能由占市场主导地位的商业应用来支付。

谁会被抛在专用化潮流后面?不迁移到专用处理器的应用程序可能会失败,因为它们:

收效甚微

没有足够大的市场来证明前期固定成本的合理性

无法协调他们的需求

先前,我们描述了四个特征,这些特征使得使用专用处理器可以加快计算速度。如果没有这些特性,那么专门化只能带来最小的性能提升(如果有的话)。一个重要的例子是数据库。正如我们采访的一位专家告诉我们的那样:在过去的几十年中,很明显,专用于数据库的处理器可能非常有用,但是数据库所需的计算却不适合采用专用处理器。

第二类将无法获得专用处理器赋能的,是那些需求不足以证明前期固定成本合理的应用。正如我们从模型中得出的那样,需要数以千计的处理器市场来证明专用化的合理性。这可能会影响那些在小范围内进行密集计算的人(例如,研究科学家进行的罕见计算任务)或那些计算随时间而快速变化从而需求迅速消失的人。

可能会落在后面的第三类,是那些没有单个用户代表足够需求且协调困难的人群。例如,即使成千上万的小型用户集体有足够的需求,要他们共同为生产专门的处理器做出贡献也将是极其困难的。一种可能的方式是,云计算公司可以为创建专用处理器提供资金,然后将其出租出去。

技术进步会帮助我们摆脱困境吗?回到一个用户继续使用通用处理器的循环中,处理器的性能和 / 或每美元性能都需要有快速提高。但是技术趋势指向了相反的方向。例如,在性能方面,预计微型化的最终好处将是价格溢价,并且仅可能由重要的商业应用来支付。我们甚至不禁疑虑,所有剩余的、在技术上实际可行的小型化是否还要继续完成?Gartner 预测,到 2026 年将有规模生产 5nm 节点尺寸,将会实现更多功能。而台积电(TSMC)最近宣布了一项 195 亿美元的 3nm 芯片工厂的计划,但我们接触的许多受访者对是否值得将其小型化仍然表示怀疑。

是否有可能有其他的技术进步能恢复通用处理器改进的步伐吗?当然,有关此类技术的讨论很多:量子计算,碳纳米管,光学计算等等。不幸的是,专家们预计,至少要再过十年,工业界才能设计出一种更广泛使用的量子计算机,从而有可能替代传统的通用计算机。拥有更广阔前景的其他技术可能仍将需要大量资金来开发和生产,直至投入市场。

结论

传统意义上,计算经济学是由通用技术模型驱动的:通用处理器的发展越来越好,市场增长不断推动了处理器的改进和对它们的改进的投资。几十年来,这个良好的通用技术经济周期使计算机成为经济增长的最重要驱动力之一。

本文提供的证据表明,通用处理器的通用技术周期已被一种新的碎片化的周期所取代。在这个碎片化的周期当中,计算速度开始放缓,并且过去的用户群体开始分崩离析。我们展示了碎片化周期的三个部分,每一个部分都已经处于正在进行中。通用处理器的改进速率已经出现了急剧且程度不断加深的放缓。购买通用处理器和专用处理器之间的经济权衡已急剧转向专用处理器一边。而且,建造更好的通用处理器的固定成本不断上升,以至于无法再由市场增长率来弥补。

总而言之,这些发现清楚地表明,处理器的经济状况已经发生了巨大变化,将计算推入了截然不同的专业领域,彼此之间也很难互相促进减少了。而且,由于此循环是自我增强的,因此它将永久存在,从而进一步分散通用计算的份额,最终将会拆分出更多的应用程序以及它们的专用硬件。通用处理器的改进速度将进一步放慢。

总的来说,我们的文章强调了经济学推动计算机技术发展的重大转向,并对想要抵制碎片化循环的人提出了挑战。

References:

1、 Amazon Web Services: Elastic GPUs, 2017; https://aws.amazon.com/de/ec2/elastic-gpus/

2. Bloom, N., Jones, C., Van Reenen, J. and Webb, M. Are Ideas Getting Harder to Find? Cambridge, MA, 2017; https://doi.org/10.3386/w23782

3. Bresnahan, T.F. and Trajtenberg, M. General purpose technologies 'Engines of growth'? J. Econom. 65, 1 (Jan. 1995), 83–108; https://doi.org/10.1016/0304-4076(94)01598-T

4. Byrne, D.M., Oliner, S.D. and Sichel, D.E. Is the information technology revolution Over? SSRN Electron. J. (2013), 20–36; https://doi.org/10.2139/ssrn.2303780

5. Cavin, R.K., Lugli, P. and Zhirnov, V. V. Science and engineering beyond Moore's Law. In Proceedings of the IEEE 100, Special Centennial Issue (May 2012), 1720–1749; https://doi.org/10.1109/JPROC.2012.2190155

6. Dent, S. Major AMD chip supplier will no longer make next-gen chips, 2018; https://www.engadget.com/2018/08/28/global-foundries-stops-7-nanometer-chip-production/

7. Eastwood, G. How chip design is evolving in response to IoT development. Network World (2017); https://www.networkworld.com/article/3227786/internet-of-things/how-chip-design-is-evolving-in-response-to-iot-development.html

8. Economist. The future of computing—After Moore's Law (2016); https://www.economist.com/news/leaders/21694528-era-predictable-improvement-computer-hardware-ending-what-comes-next-future

9. Economist. The chips are down: The semiconductor industry and the power of globalization (2018); https://www.economist.com/briefing/2018/12/01/the-semiconductor-industry-and-the-power-of-globalisation.

10. ENIAC Report. Moore School of Electrical Engineering, 1946.

11. Feldmann, M. New GPU-accelerated supercomputers change the balance of power on the TOP500, 2018; https://www.top500.org/news/new-gpu-accelerated-supercomputers-change-the-balance-of-power-on-the-top500/

12. Gartner Group. Gartner Says Worldwide Semiconductor Revenue Grew 22.2 Percent in 2017. Samsung Takes Over No. 1 Position. Gartner. 2018; https://www.gartner.com/newsroom/id/3842666

13. Google Cloud. Google: Release Notes, 2018; https://cloud.google.com/tpu/docs/release-notes

14. Hemsoth, N. An Early Look at Baidu's Custom AI and Analytics Processor. The Next Platform; https://www.nextplatform.com/2017/08/22/first-look-baidus-custom-ai-analytics-processor/

15. Hennessy, J. and Patterson, D. Computer Architecture: A Quantitative Approach (6th ed.). Morgan Kaufmann Publishers, Cambridge, MA, 2019..

16. International Technology Roadmap for Semiconductors 2.0: Executive Report. International technology roadmap for semiconductors, 79, 2015; http://www.semiconductors.org/main/2015_international_technology_roadmap_for_semiconductors_itrs/

17. Jao, N. Taiwanese chip maker TSMC to build the world's first 3nm chip factory. Technode, 2018; https://technode.com/2018/12/20/taiwanese-chip-maker-tsmc-to-build-the-worlds-first-3nm-chip-factory/

18. Johnson, B., Tuan, S., Brady, W., Jim, W. and Jim, B. Gartner Predicts 2017: Semiconductor Technology in 2026.

19. Jouppi, N.P. et al. In-datacenter performance analysis of a tensor processing unit. In Proceedings of the 44th Annual Int. Symp. Comput. Archit. (2017), 1–12; https://doi.org/10.1145/3079856.3080246

20. Khan, H.N., Hounshell, D.A. and Fuchs, E.R.H. Science and research policy at the end of Moore's Law. Nat. Electron. 1, 1 (2018), 14–21; https://doi.org/10.1038/s41928-017-0005-9

21. Khazraee, M., Zhang, L., Vega, L. and Taylor, M.B. Moonwalk? NRE optimization in ASIC clouds or accelerators will use old silicon. In Proceedings of ACM ASPLOS 2017, 1–16; https://doi.org/http://dx.doi.org/10.1145/3037697.3037749

22. Krzanich, B. Intel Corporation Presentation at Sanford C Berstein Strategic Decisions Conference, 2016.

23. Lapedus, M. Foundry Challenges in 2018. Semiconductor Engineering, 2017; https://semiengineering.com/foundry-challenges-in-2018/

24. Leiserson, C.E., Thompson, N., Emer, J., Kuszmaul, B.C., Lampson, B.W., Sanchez, D. and Schardl, T.B. There's plenty of room at the top: What will drive growth in computer performance after Moore's Law ends? Science (2020).

25. Martin, T.W. and Fitzgerald, D. Your love of your old smartphone is a problem for Apple and Samsung. WSJ (2018); https://www.wsj.com/articles/your-love-of-your-old-smartphone-is-a-problem-for-apple-and-samsung-1519822801

26. Mims, C. Huang's Law is the new Moore's Law, and explains why Nvidia wants arm. WSJ (2020); https://www.wsj.com/articles/huangs-law-is-the-new-moores-law-and-explains-why-nvidia-wants-arm-11600488001

27. NVIDIA Corporation. Tesla P100 Performance Guide. HPC and Deep Learning Applications, 2017.

28. Patton, G. Forging Intelligent Systems in the Digital Era. MTL Seminar, 2017; https://www-mtl.mit.edu/mtlseminar/garypatton.html#simple3

29. Pham, S. 2018. Who needs the US? Alibaba will make its own computer chips. CNN Business, 2018; https://edition.cnn.com/2018/10/01/tech/alibaba-chip-company/index.html

30. Prickett Morgan, T. Intel Takes First Steps To Universal Quantum Computing. Next Platform, 2017; https://www.nextplatform.com/2017/10/11/intel-takes-first-steps-universal-quantum-computing/

31. Putnam, A. et al. A reconfigurable fabric for accelerating large-scale datacenter services. Commun. ACM 59, 11 (Oct. 2016), 114–122; https://doi.org/10.1145/2996868

32. Santhanam, N., Wiseman, B., Campbell, H., Gold, A. and Javetski, B. McKinsey on Semiconductors, 2015.

33. Shalf, J.M. and Leland, R. Computing beyond Moore's Law. Computer 48, 12 (Dec. 2015), 14–23; https://doi.org/10.1109/MC.2015.374

34. Shao, Y.S., Reagen, B., Wei, G.Y., and Brooks, D. Aladdin: A pre-RTL, power-performance accelerator simulator enabling large design space exploration of customized architectures. In Proceedings of the Int. Symp. Comput. Archit. (2014), 97–108; DOI:https://doi.org/10.1109/ISCA.2014.6853196

35. Semiconductor Industry Association: 2017 Factbook; http://go.semiconductors.org/2017-sia-factbook-0-0-0

36. Smith, S.J. Intel: Strategy Overview, 2017; https://doi.org/10.1016/B978-0-240-52168-8.10001-X

37. Top500. The Green500 List (June 2019); https://www.top500.org/green500/lists/2019/06/

38. Worldometers. Computers sold in the world this year, 2018; http://www.worldometers.info/computers/

* 经作者授权翻译,宾夕法尼亚大学经济政治研究中心高级数据研究员戈书宁对本文亦有贡献

原文:The Decline of Computers as a General Purpose Technology

本文来自微信公众号:数据实战派(ID:gh_ff93f845912e),作者:Neil、Svenja