本文来自微信公众号:极客公园(ID:geekpark),作者:脸脸,原文标题:《Google AI 再曝黑人女员工离职,这是所有科技公司都将面对的问题》,头图:视觉中国

在 AI 行业在全球快速发展的当下,也只有 Google 内部爆出了如此大范围的严肃讨论。

2 月 20日,谷歌 Ethical AI(AI 伦理)团队的创始人 Mitchell 在推特上发了一条简短的声明:“I am fired”,这与去年另一位女性研究员 Timnit Gebru 的遭遇如出一辙,而这两位女性正是谷歌 Ethical AI 部门曾经的两位联合负责人。

去年年底,Gebru 发推表示自己被公司开除,她因一篇论文的发表与公司上层产生矛盾,被要求撤稿后,她在一篇内部邮件中表示了自己对公司种族偏见问题的不满,随后被解雇。

在从外界角度来看,似乎很难不将 Mitchell 的解雇和 Gebru 事件联系起来。

推特上的唇枪舌战

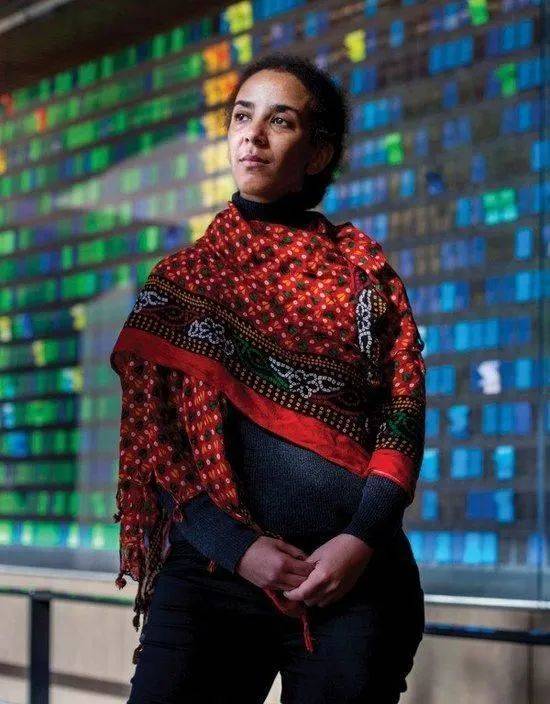

这位 Gebru 是谷歌 AI 伦理部门的联合负责人,也是谷歌内部极少数的黑人女研究员(根据该公司 2020 年年度多样性报告,Google 员工中有 3.7%是黑人),同时她也是 Black In AI 的联合创始人,致力于黑人在算法领域的平权。

而谷歌方,Gebru 的上司 Jeff Dean 站出来表示,“论文未达到发表标准,是女方主动拿辞职要挟”。双方各有说法,在推特上来来回回唇枪舌战。

事件发生后,AI 界大多都站在了 Gebru 这一边。据 BBC 报道,超过 4500 名来自微软、谷歌等大公司的科研人员在支持 Gebru 的公开信上签了名,要求谷歌方进一步解释开除 Gebru 的原因。今年 1 月,谷歌内部员工还成立了 AIphabet 工会,该工会向所有 AIphabet 员工开放,包括临时工、供应商等,为少数群体利益发声,并要求恢复 Gebru 的职位。

公司 CEO Pichai 率先出来灭火,承诺将会进行进一步调查,以期能为这场轰轰烈烈的闹剧划上一个句号。今年 2 月,Dean 也向解雇 Gebru 和对其他女性员工造成的伤害致歉,谷歌还宣布了新的多元化政策,包括将 DEI(多元、公正、包容)目标与副总裁以上级别员工的绩效评估挂钩。这似乎是进一步的灭火行为,但随后 Mitchell 就被解雇。

如今被开除的 Mitchell 也是一位 AI 道德专家,曾从事机器偏见,种族和性别多样性以及用于图像捕获的语言模型方面的工作,她与 Gebru 共同领导该公司的道德 AI 团队。同时值得注意的是,她也是那篇导火线论文的共同创作者。

Gebru 被炒鱿鱼后,Mitchell 多次在公共平台表示对谷歌的不满。今年 1 月份,她被限制了公司内部电子邮件访问权限,就在被开除的几小时前,Mitchell 还在推特上抨击谷歌“一向疏远黑人女性”。

谷歌方对于开除 Mitchell 给出的回应是:“在对这位经理的行为进行审查之后,我们确认存在多次违反我们的行为守则和安全政策的行为,其中包括泄露机密的业务敏感文件和其他员工的私人数据。”

算法偏见

回到导致 Gebru 和 Mitchell 均被解雇的最初,引起争议的论文《随机鹦鹉之险:语言模型会太大吗?(On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?)》,它从环保和成本角度、种族和性别方面探讨了大型语言模型(如 BERT)带来的高耗电等风险。同时 Gebru 指出如果不加区分地使用现有数据训练人工智能,会进一步加深 AI 语言模型中对少数边缘群体的偏见。

该论文的引言中写道:“我们问是否已对与开发这些风险相关的潜在风险以及减轻这些风险的策略进行了足够的思考。”

谷歌 AI 在 2017 年首先发明了 Transformer 语言模型,2018 年,在此基础上推出的 BERT 语言模型在人工智能领域引起轰动,同时也广泛运用到谷歌搜索引擎的训练上,已经成为谷歌经济收入的重要来源。

这篇论文是对谷歌目前最有利可图的 AI 研究提出的担忧,而这种担忧并不是空穴来风,AI 中涉及的伦理偏见已经不是第一次出现。

2015 年,谷歌相册将两个深肤色的人标记为“大猩猩”,谷歌公司当时保证“立即采取措施”,以防止再犯重复错误。不过随后为了解决这一问题,谷歌直接从搜索结果中删除了这一词条的标签。《连线》杂志在谷歌相册上测试了 4 万多张动物图片,最终得出了这样一个结论:谷歌不再将任何图片标记为大猩猩、黑猩猩、猴子,即使就是这种动物的图片也是如此。

而去年,最令人震惊的 AI 偏见应该是 PULSE 算法将奥巴马识别为一位白人男性。这个由英伟达开发出的算法,使用一种叫“upscaling”的技术来处理视觉数据,把原始的低分辨率图片生成为一个全新的高分辨率面部图像。该算法的创建者解释称这种偏差可能继承于训练 AI 的数据集,这些数据集中缺少有色人种的存在,在此基础上训练出的 AI 将会默认使用白种人特征。

在今年的疫情期间,谷歌 AI 也出现了类似情况。

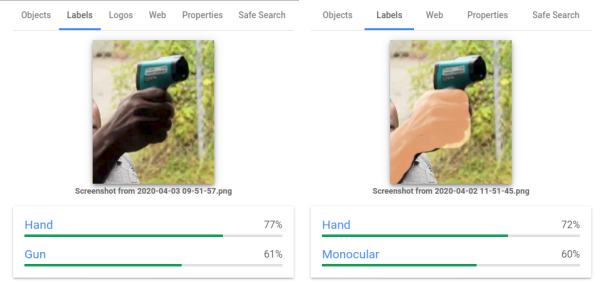

经非盈利研究和倡导组织 AIgorithmWatch 证实,谷歌旗下计算机服务 Google Vision Cloud 会将手持测温计的深肤色人员图像标记为“枪”,而相同条件下,浅肤色人员图像则被标记为“电子设备”。究其原因,这与深肤色的人员图像在数据训练时在暴力场景出现的高频率有关,随后谷歌致歉并更新了算法,测温计图像中不再出现“枪支”标记。这种对于有色人种在数据训练中的忽视,已经成为 AI 偏见常出现的情况。

冲突中心的谷歌

AI 伦理问题产生的根源,是人类社会中存在着相同的偏见。

一直以来,硅谷科技公司向外界展示着它开放、平等的文化。早在 2014 年,硅谷的 33 家科技公司就共同签订了多元化承诺。然而除算法偏见,近几年,微软、亚马逊、Uber 等公司却频频爆出关于性别歧视、肤色偏见的道德丑闻,曾经的全球最佳雇主谷歌也难逃其中。

2018 年,据《纽约时报》报道,谷歌向因性骚扰传闻离职的“安卓之父”Andy Rubin 支付了约 9000 万美元,并在过去 10 年中保护了包括鲁宾在内的三位被指控性行为不端的男性高管。

这引发了谷歌员工的强烈抗议,全球 20 多个办事处的 20000 多名员工进行了历史性的集体大罢工,走上街头喊出“我们要透明度、追责和架构调整”的口号。随后谷歌致歉,并承诺将会撤销针对性不端行为的强制仲裁。

虽然近年来 Google 内部不断出现各种 AI 相关的伦理讨论时间,外界持续不断地批评 Google 在这些方面做得不够好。但从另一个角度看,在 AI 行业在全球快速发展的当下,也只有 Google 内部爆出了如此大范围的严肃讨论,这恰恰是从 Google 一直以来自由管理、直言不讳的文化中诞生的。

在 Gebru 离职风波后,不只是 Ethical AI 团队,整个谷歌公司的氛围都持续紧张。沸沸扬扬的争议声和谷歌内部多次抗议中,谷歌成立了硅谷的第一个大型工会 AIphabet Workers Union,旨在让员工自由发声。

在今年,经过多拨讨伐的 Dean 向 Gebru 事件致歉,并且任命了另一位黑人女性 Mariian Croak 为 Ethical AI 的主管,继续向他汇报工作。Ethical AI 成立的初衷就是为了监控 Google AI 的道德走向,为此,这个部门也是公司中多元化程度最高的一个部门,将那些在算法中那些最有可能受到偏见伤害的弱势群体聚集到一起。

值得注意的是,AIphabet 工会并没有在这件事后停下脚步。今年 2 月 11 日,AIphabet 工会向谷歌提出不公平劳动指控,这是该工会的第一个法律行动,与先前的公开信等行动不同,本次指控具备法律效力。

对于一个充满黑箱和未知的技术,AI 值得人们探讨的问题还有很多。Google 是第一家爆发激烈讨论的公司,但它绝不会是最后一家。

本文来自微信公众号:极客公园(ID:geekpark),作者:脸脸